自然语言处理

0 人感兴趣 · 122 次引用

- 最新

- 推荐

大语言模型的创意能力到底几何?探索从 GPT-2 到 GPT-4 的演进

编者按:大语言模型可以提供许多创意性内容,如写诗、写小说等。那么到底应该如何评估大语言模型生成的创意性内容的水平呢? 本文探讨了GPT-2到GPT-4的创造性,并分析了这些模型在不同创造性测试中的表现。作者使用了三种测试来衡量模型的创造性:Remote A

深度学习进阶篇 [7]:Transformer 模型长输入序列、广义注意力、FAVOR+ 快速注意力、蛋白质序列建模实操。

基于Transformer模型在众多领域已取得卓越成果,包括自然语言、图像甚至是音乐。然而,Transformer架构一直以来为人所诟病的是其注意力模块的低效,即长度二次依赖限制问题。随着输入序列长度的增加,注意力模块的问题也越来越突出,算力和内存消耗是输入序列

Generative AI 新世界 | 走进文生图(Text-to-Image)领域

在之前的四篇 “Generative AI 新世界” 中,我们带领大家一起探索了生成式 AI(Generative AI),以及大型语言模型(LLMs)的全新世界概览。并在文本生成(Text Generation)领域做了一些概述、相关论文解读、以及在亚马逊云科技的落地实践和动手实验。

深度学习进阶篇 - 国内预训练模型 [6]:ERNIE-Doc、THU-ERNIE、K-Encoder 融合文本信息和 KG 知识;原理和模型结构详解。

经典的Transformer在处理数据时,会将文本数据按照固定长度进行截断,这个看起来比较”武断”的操作会造成上下文碎片化以及无法建模更长的序列依赖关系。基于此项考虑,ERNIE-Doc提出了一种文档层级的预训练语言模型方法:ERNIE-Doc在训练某一个Segment时,允

深度学习进阶篇 - 国内预训练模型 [5]:ERINE、ERNIE 3.0、ERNIE- 的设计思路、模型结构、应用场景等详解

ERINE是百度发布一个预训练模型,它通过引入三种级别的Knowledge Masking帮助模型学习语言知识,在多项任务上超越了BERT。在模型结构方面,它采用了Transformer的Encoder部分作为模型主干进行训练,如 图1 (图片来自网络)所示。

深度学习进阶篇 - 预训练模型 [4]:RoBERTa、SpanBERT、KBERT、ALBERT、ELECTRA 算法原理模型结构应用场景区别等详解

深度学习进阶篇-预训练模型[4]:RoBERTa、SpanBERT、KBERT、ALBERT、ELECTRA算法原理模型结构应用场景区别等详解

深度学习进阶篇 - 预训练模型 [3]:XLNet、BERT、GPT,ELMO 的区别优缺点,模型框架、一些 Trick、Transformer Encoder 等原理详细讲解

自回归模型(Autoregressive Model, AR),通过估计一串文本序列的生成概率分布进行建模。一般而言,AR模型通过要么从前到后计算文本序列概率,要么从后向前计算文本序列概率,但不论哪种方式的建模,都是单向的。即在预测一个单词的时候无法同时看到该单词位

Prompt 工程师指南 [高阶篇]:对抗性 Prompting、主动 prompt、ReAct、GraphPrompts、Multimodal CoT Prompting 等

对抗性Prompting是Prompting工程中的一个重要主题,因为它有助于理解与 LLMs 相关的风险和安全问题。这也是一门重要的学科,用于识别这些风险并设计解决问题的技术。

Prompt 工程师指南 [应用篇]:Prompt 应用、ChatGPT|Midjouney Prompt Engineering

Prompt工程师指南[应用篇]:Prompt应用、ChatGPT|Midjouney Prompt Engineering

Prompt 工程师指南 [从基础到进阶篇]:用于开发和优化提示,以有效地使用语言模型(LMs)进行各种应用和研究主题

Prompt工程是一种相对较新的学科,用于开发和优化提示,以有效地使用语言模型(LMs)进行各种应用和研究主题。Prompt工程技能有助于更好地理解大型语言模型(LLMs)的能力和局限性。研究人员使用Prompt工程来改善LLMs在各种常见和复杂任务上的能力,

Prompt learning 教学 [最终篇]:Chatgpt 使用场景推荐、优秀学习资料推荐、AI 工具推荐

Prompt learning 教学[最终篇]:Chatgpt使用场景推荐、优秀学习资料推荐、AI工具推荐

Prompt learning 教学 [技巧篇]:通过增加示例、引导词、特殊符号指令等方式让 chatgpt 输出更好的答案

在问答场景里,为了让 AI 回答更加准确,一般会在问题里加条件。比如让 AI 推荐一部电影给你 Recommend a movie to me 。但这个 prompt 太空泛了,AI 无法直接回答,接着它会问你想要什么类型的电影,但这样你就需要跟 AI 聊很多轮,效率比较低。

Prompt learning 教学 [基础篇]:prompt 基本原则以及使用场景技巧助力你更好使用 chatgpt,得到你想要的答案

Prompt learning 教学[基础篇]:prompt基本原则以及使用场景技巧助力你更好使用chatgpt,得到你想要的答案

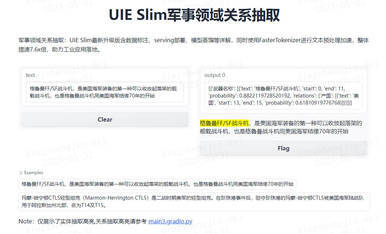

基于 Label studio 实现 UIE 信息抽取智能标注方案,提升标注效率!

基于Label studio实现UIE信息抽取智能标注方案,提升标注效率!

大语言模型 (LLMs) 和新兴机器学习技术栈

编者按:过去,NLP开发人员依赖于文本分类、命名实体识别和命名实体消歧等技术栈来优化NLP任务。然而,随着大语言模型(LLM)的快速发展,新的技术栈开始出现,以支持和加速这些大型语言模型的实现和应用。

3 分钟快速了解 GPT-4

编者按:3分钟快速了解GPT-4,高效获取目前关于GPT-4的重点信息。话不多说,Enjoy!

LLaMA 快速上手指南

近期,Meta发布了人工智能大语言模型LLaMA,包含70亿、130亿、330亿和650亿这4种参数规模的模型。其中,最小的LLaMA 7B也经过了超1万亿个tokens的训练。