Tensor:Pytorch 神经网络界的 Numpy

摘要:Tensor,它可以是 0 维、一维以及多维的数组,你可以将它看作为神经网络界的 Numpy,它与 Numpy 相似,二者可以共享内存,且之间的转换非常方便。

本文分享自华为云社区《Tensor:Pytorch神经网络界的Numpy》,作者: 择城终老 。

Tensor

Tensor,它可以是 0 维、一维以及多维的数组,你可以将它看作为神经网络界的 Numpy,它与 Numpy 相似,二者可以共享内存,且之间的转换非常方便。

但它们也不相同,最大的区别就是 Numpy 会把 ndarray 放在 CPU 中进行加速运算,而由 Torch 产生的 Tensor 会放在 GPU 中进行加速运算。

对于 Tensor,从接口划分,我们大致可分为 2 类:

1. torch.function:如 torch.sum、torch.add 等。

2. tensor.function:如 tensor.view、tensor.add 等。

而从是否修改自身来划分,会分为如下 2 类:

1. 不修改自身数据,如 x.add(y),x 的数据不变,返回一个新的 Tensor。

2. 修改自身数据,如 x.add_(y),运算结果存在 x 中,x 被修改。

简单的理解就是方法名带不带下划线的问题。

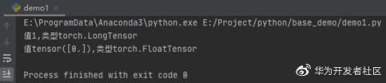

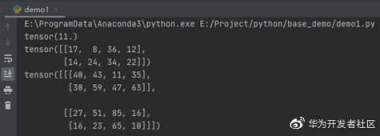

现在,我们来实现 2 个数组对应位置相加,看看其效果究竟如何:

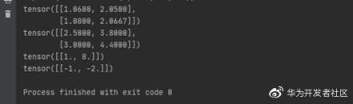

运行之后,效果如下:

下面,我们来正式讲解 Tensor 的使用方式。

创建 Tensor

与 Numpy 一样,创建 Tensor 也有很多的方法,可以自身的函数进行生成,也可以通过列表或者 ndarray 进行转换,同样也可以指定维度等。具体方法如下表(数组即张量):

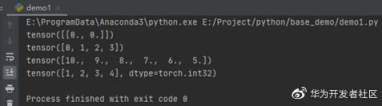

这里需要注意 Tensor 有大写的方法也有小写的方法,具体效果我们先来看看代码:

运行之后,效果如下:

其他示例如下:

其他例子基本与上面基本差不多,这里不在赘述。

修改 Tensor 维度

同样的与 Numpy 一样,Tensor 一样有维度的修改函数,具体的方法如下表所示:

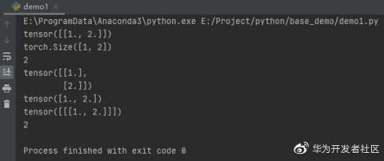

示例代码如下所示:

运行之后,效果如下:

截取元素

当然,我们创建 Tensor 张量,是为了使用里面的数据,那么就不可避免的需要获取数据进行处理,具体截取元素的方式如表:

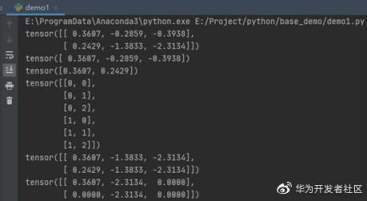

示例代码如下所示:

运行之后,效果如下:

我们 a =torch.gather(t1, 0, index)对其做了一个图解,方便大家理解。如下图所示:

当然,我们直接有公式计算,因为这么多数据标线实在不好看,这里博主列出转换公式供大家参考:

简单的数学运算

与 Numpy 一样,Tensor 也支持数学运算。这里,博主列出了常用的数学运算函数,方便大家参考:

需要注意的是,上面表格所有的函数操作均会创建新的 Tensor,如果不需要创建新的,使用这些函数的下划线"_"版本。

示例如下:

运行之后,效果如下:

上面的这些函数都很好理解,只有一个函数相信没接触机器学习的时候,不大容易理解。也就是 sigmoid()激活函数,它的公式如下:

归并操作

简单的理解,就是对张量进行归并或者说合计等操作,这类操作的输入输出维度一般并不相同,而且往往是输入大于输出维度。而 Tensor 的归并函数如下表所示:

示例代码如下所示:

运行之后,效果如下:

需要注意的是,sum 函数求和之后,dim 的元素个数为1,所以要被去掉,如果要保留这个维度,则应当 keepdim=True,默认为 False。

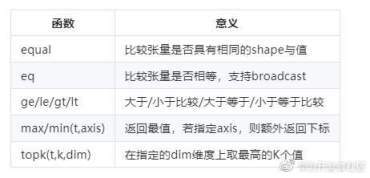

比较操作

在量化交易中,我们一般会对股价进行比较。而 Tensor 张量同样也支持比较的操作,一般是进行逐元素比较。具体函数如下表:

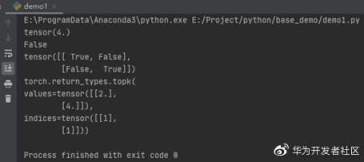

示例代码如下所示:

运行之后,输出如下:

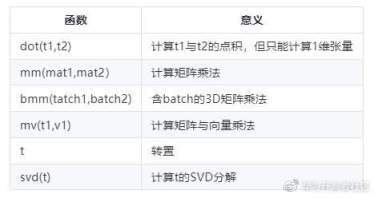

矩阵运算

机器学习与深度学习中,存在大量的矩阵运算。与 Numpy 一样常用的矩阵运算一样,一种是逐元素相乘,一种是点积乘法。函数如下表所示:

这里有 3 个主要的点积计算需要区分,dot()函数只能计算 1 维张量,mm()函数只能计算二维的张量,bmm 只能计算三维的矩阵张量。示例如下:

运行之后,输出如下:

版权声明: 本文为 InfoQ 作者【华为云开发者社区】的原创文章。

原文链接:【http://xie.infoq.cn/article/85a99de644d8d1405ee3d0841】。文章转载请联系作者。

评论