IDEA 开发 Spark 应用实战 (Scala),java 高级开发简历

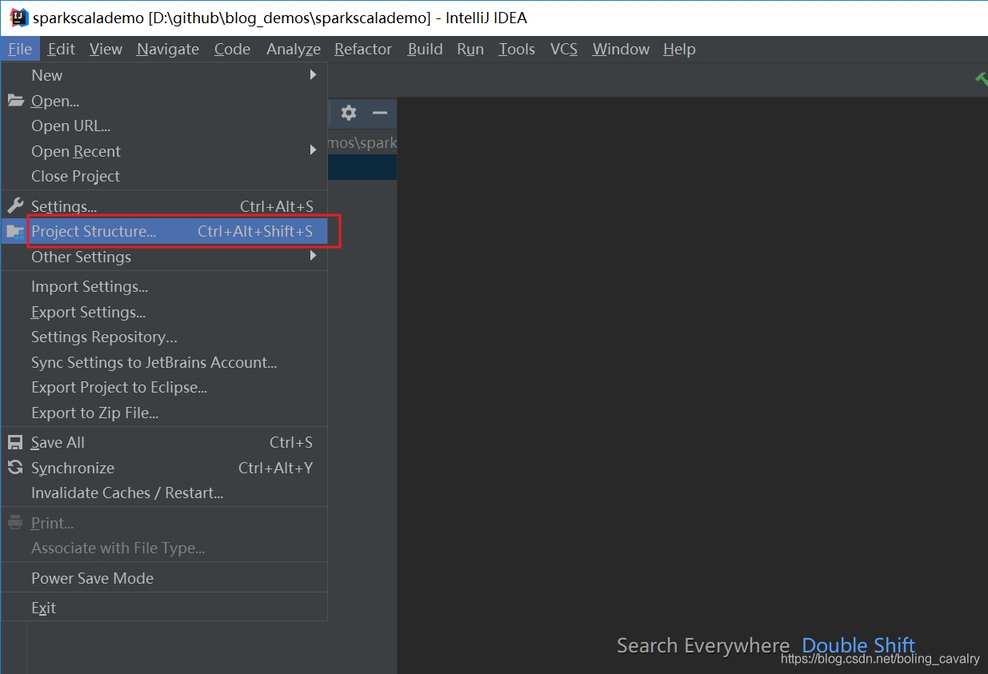

在弹出窗口选择新增一个 jar 库,如下图:

在弹出窗口选择前面安装的 spark-2.3.3-bin-hadoop2.7 文件夹下面的 jar 文件夹,如下:

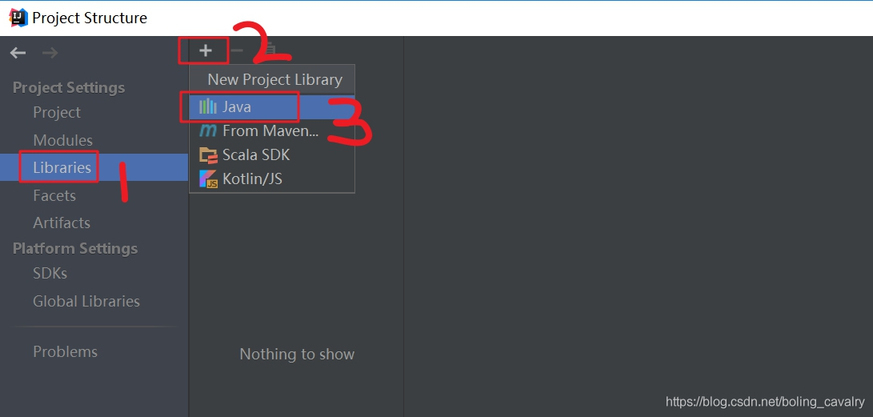

如下图,弹出的窗口用来选择模块,就选工程目录即可:

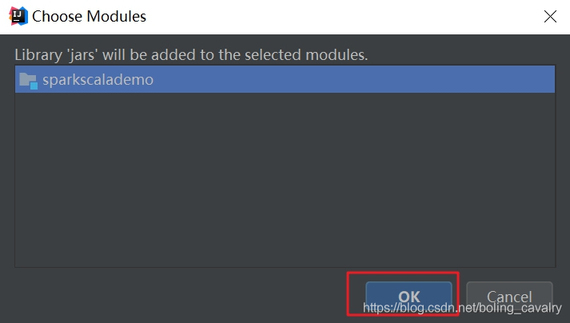

至此,整个 spark 开发环境已经设置好了,现在写一个 demo 试试,创建一个 object,源码如下:

package com.bolingcavalry.sparkscalademo.app

import org.apache.spark.{SparkConf, SparkContext}

/**

@Description: 第一个 scala 语言的 spark 应用

@author: willzhao E-mail: zq2599@gmail.com

@date: 2019/2/16 20:23

*/

object FirstDemo {

def main(args: Array[String]): Unit={

val conf = new SparkConf()

.setAppName("first spark app(scala)")

.setMaster("local[1]");

new SparkContext(conf)

.parallelize(List(1,2,3,4,5,6))

.map(x=>x*x)

.filter(_>10)

.collect()

.foreach(println);

}

}

以上代码的功能很简单:创建用一个数组,将每个元素做平方运算,再丢弃小于 10 的元素,然后逐个打印出来;

11. 代码完成后,点击右键选择"Run FirstDemo",即可立即在本机运行,如下图:

12. 由于 windows 环境并没有做 hadoop 相关配置,因此控制台上会有错误堆栈输出,但这些信息并不影响程序运行(本例没有用到 hadoop),输出如下,可见结果已经被打印出来(16、25、36):

2019-02-17 09:04:21 INFO TaskSchedulerImpl:54 - Removed TaskSet 0.0, whose tasks have all completed, from pool

2019-02-17 09:04:21 INFO DAGScheduler:54 - ResultStage 0 (collect at FirstDemo.scala:20) finished in 0.276 s

2019-02-17 09:04:21 INFO DAGScheduler:54 - Job 0 finished: collect at FirstDemo.scala:20, took 0.328611 s

16

25

36

2019-02-17 09:04:21 INFO SparkContext:54 - Invoking stop() from shutdown hook

2019-02-17 09:04:21 INFO AbstractConnector:318 - Stopped Spark@452ba1db{HTTP/1.1,[http/1.1]}{0.0.0.0:4040}

2019-02-17 09:04:21 INFO SparkUI:54 - Stopped Spark web UI at http://DESKTOP-82CCEBN:4040

2019-02-17 09:04:21 INFO MapOutputTrackerMasterEndpoint:54 - MapOutputTrackerMasterEndpoint stopped!

2019-02-17 09:04:21 INFO MemoryStore:54 - MemoryStore cleared

2019-02-17 09:04:21 INFO BlockManager:54 - BlockManager stopped

2019-02-17 09:04:21 INFO BlockManagerMaster:54 - BlockManagerMaster stopped

2019-02-17 09:04:21 INFO OutputCommitCoordinator$OutputCommitCoordinatorEndpoint:54 - OutputCommitCoordinator stopped!

2019-02-17 09:04:21 INFO SparkContext:54 - Successfully stopped SparkContext

2019-02-17 09:04:21 INFO ShutdownHookManager:54 - Shutdown hook called

2019-02-17 09:04:21 INFO ShutdownHookManager:54 - Deleting directory C:\Users\12167\AppData\Local\Temp\spark-4bbb584a-c7c2-4dc8-9c7e-473de7f8c326

Process finished with exit code 0

构建打包,提交到 spark 环境运行

生产环境下一般是将应用构建打包成 jar,放到 spark 集群中运行,所以我们来操作构建打包;

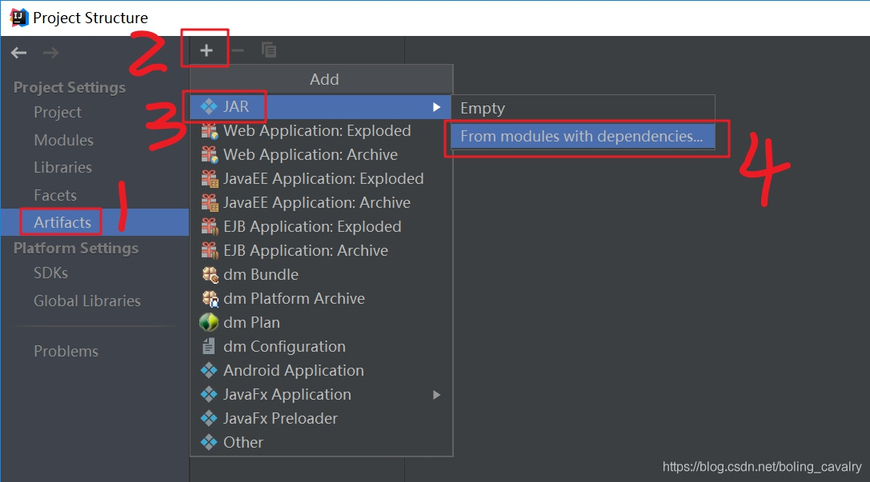

在菜单上选择"File"->“Project Structure”,弹出窗口点击"Artifacts",选择新增 jar,如下图:

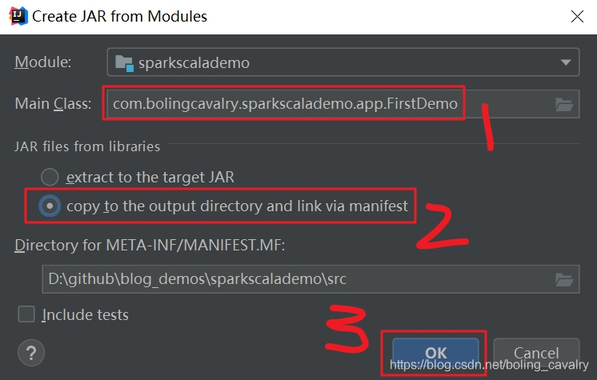

如下图,在弹出的窗口中,红框 1 位置输入要运行的 class,红框 2 选择的是单选框的第二个"copy to the output …":

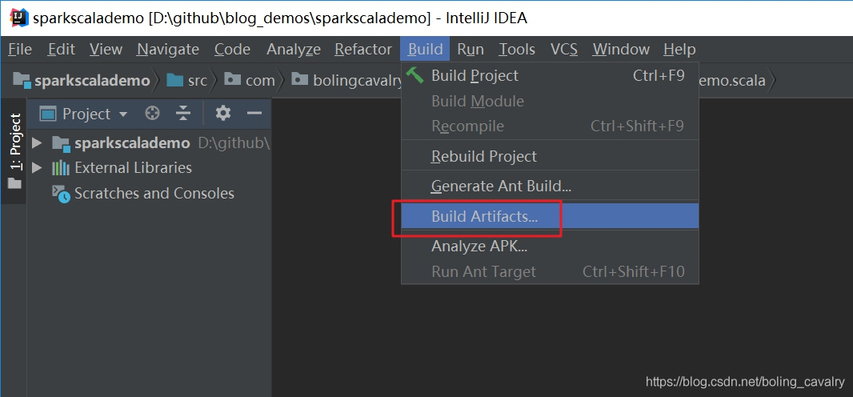

在菜单上选择"Build"->“Build Artifacts…”,如下图:

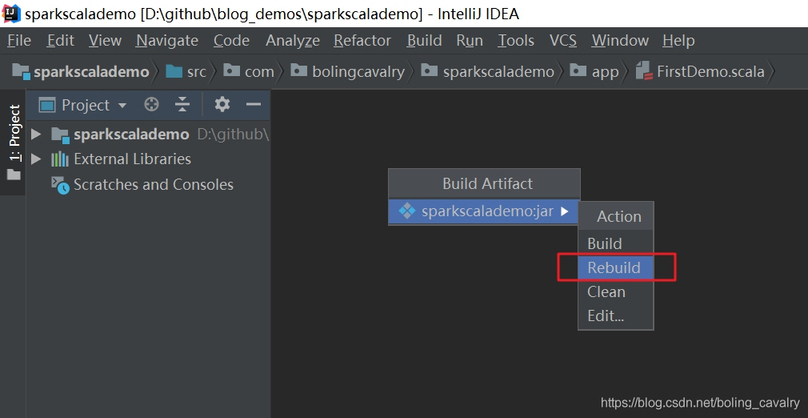

在弹出的菜单中选择"sparkscalademo:jar"->“Rebuild”,如下:

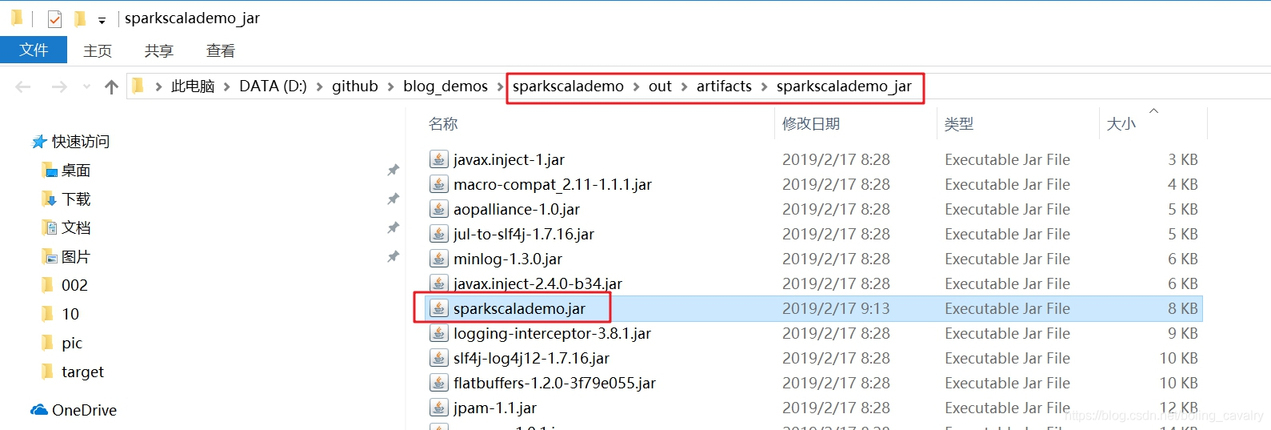

如果编译成功,在项目的 out\artifacts 目录下就会生成文件 sparkscalademo.jar,如下:

将文件上传到 spark 服务器上,执行提交命令:

spark-submit --class com.bolingcavalry.sparkscalademo.app.FirstDemo /root/jars/sparkscalademo.jar

评论