NVIDIA 英伟达发布 H100 GPU,水冷服务器适配在路上

导语

1.GPU 的价值不止体现在深度学习,在高性能计算、人工智能、生物信息、分子模拟、计算化学、材料力学、系统仿真、流体力学、机械设计、生物制药、航空动力、地质勘探、气候模拟等领域,算法越来越复杂,需要处理的海量数据越来越巨大,高性能计算能力就显得尤为重要。近日为满足 GPU 服务器、高性能服务器、深度学习服务器、水冷工作站、水冷服务器、液冷工作站、液冷服务器等的高速运转,英伟达发布产品——H100 GPU。

2.随着信息技术的快速发展,高性能服务器的需求不断增长。为保障服务器长期可靠稳定运行,合适的散热技术显得至关重要。

3.基于蓝海大脑超融合平台的水冷 GPU 服务器及水冷 GPU 工作站采用绿色冷却技术,Gluster 分布式架构设计,提供大存储量,拥有开放融合的特性和超能运算的能力。

1 蓝海大脑服务器于 NVIDIA H100 GPU

蓝海大脑宣布服务器产品线全力支持最新的 NVIDIA H100 GPU。蓝海大脑服务器产品在单机上最多可支持 4、8 甚至 9 个 H100 GPU,可为多种人工智能场景提供超强算力、灵活的资源调度和成熟的生态支持。

搭载 NVIDIA H100 GPU 的蓝海大脑服务器具有更强计算性能、更高的 GPU 间通信带宽和创新的计算架构,支持用户对更大、更复杂的模型进行训练和推理。同时,搭配蓝海大脑算力资源管理平台,用户可以更加便捷高效地使用 AI 集群算力资源。

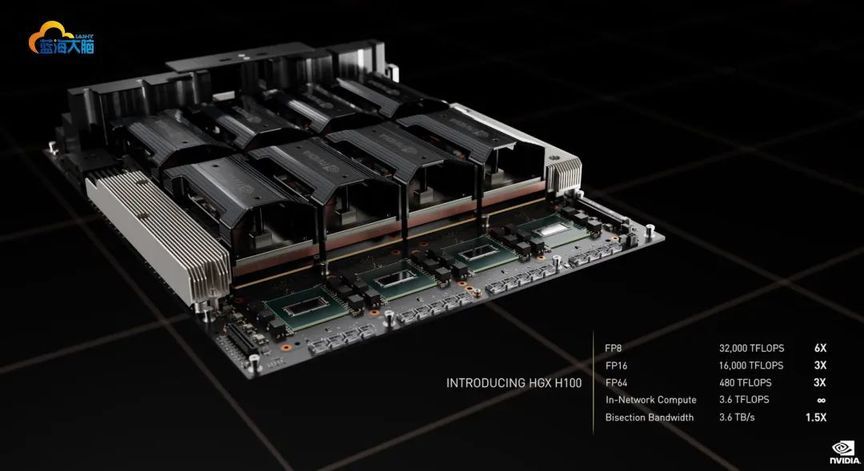

基于 GH100 GPU

据官方数据显示,全新的 NVIDIA GH100 GPU 不是基于之前传闻的台积电 N5 工艺,而是使用更先进的 N4 工艺。整个芯片面积 814mm²,相比 GA100 要小,但集成 800 亿晶体管,并采用更高频率的设计。

完整版 GH100 GPU 架构框图

完整规格的 GH100 GPU 规格,包含总计 8 个 GPC 图形集群,72 个 TPC 纹理集群,144 个 SM 流式多处理器,共计 18432 个 FP32 CUDA 核心(与目前传闻中 AD102 完整版完全吻合),专用于 AI 训练的第四代张量核心 TensorCore 为每组 SM 配备 4 个,共计 528 个。显存方面最大支持 6 个 HBM3 或 HBM2e 堆栈,6144bit 显存位宽,L2 缓存提升到 60MB,并支持第四代 NVLink 和 PCIe Gen5。

Hopper 架构的 SM 流式多处理器框图

不过,GH100 是面向人工智能、数据分析等负载构建的,不是图形处理。SXM5 版和 PCIe H100 所使用的 GH100 GPU 中,只有两个 TPC 具有图形处理能力。

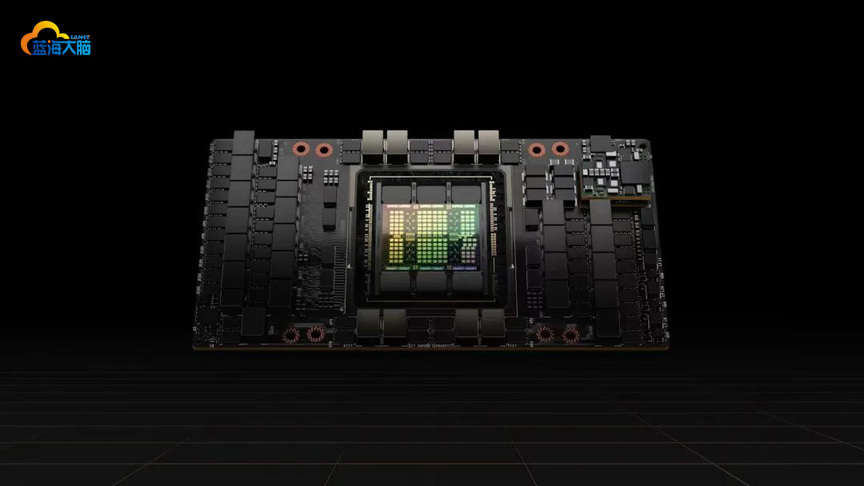

H100 SXM5 加速器

GH100 GPU 用于两个款式的加速卡上,分别为 SXM5 版和 PCIe5 版,SXM 协议更多用在密集计算的数据中心上,规格也更高一些。大概是受制于良率,即便是高规格的 SXM5 版也并不是满血的 GH100 核心。

H100 SXM5 使用的 H100 GPU 规格为 66 个 TPC 纹理集群,SM 数量下降到 132 组,而 CUDA 数量也下降到 16896 个(但相比于目前的 GA100 岂止于翻倍),张量核心为 528 个。显存方面,H100 SXM5 启用 5 个 HBM3 堆栈,共计 80GB,显存位宽为 5120Bit。L2 缓存也下降到 50MB,对比 A100 依然有 25%提升。

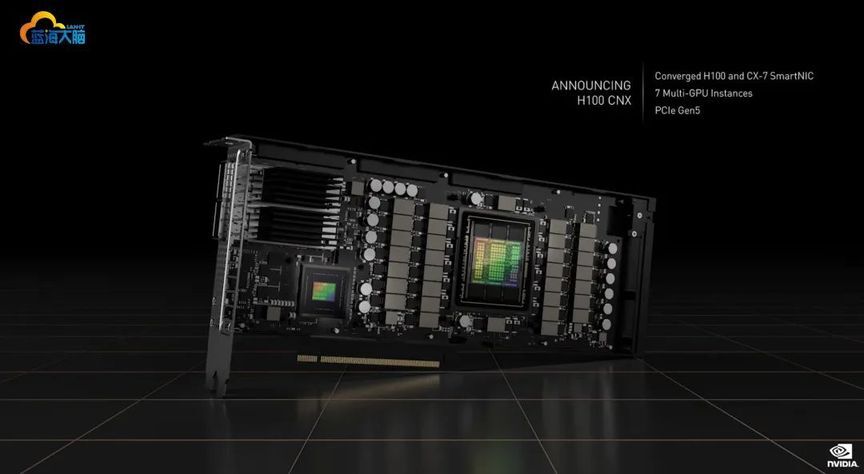

H100 PCIe5 加速器

PCIe5 版的 H100 CNX,集成 CX7 芯片,可将网络数据以 50GB/s 的速度直接传输给 GH100 GPU 处理

PCIe 版虽然更多用于小型企业,但是 PCIe 版的性能也是不容小觑。PCIe 版采用进一步缩减的 GH100 GPU,SM 数量下降到 114 组,CUDA 数量下降到 14592 个,张量核心则缩减到了 456 个。显存方面,启用的是 5 个 HBM2e 堆栈,容量与 SXM5 版相同,为 80GB 5120Bit 位宽,L2 缓存大小一致。

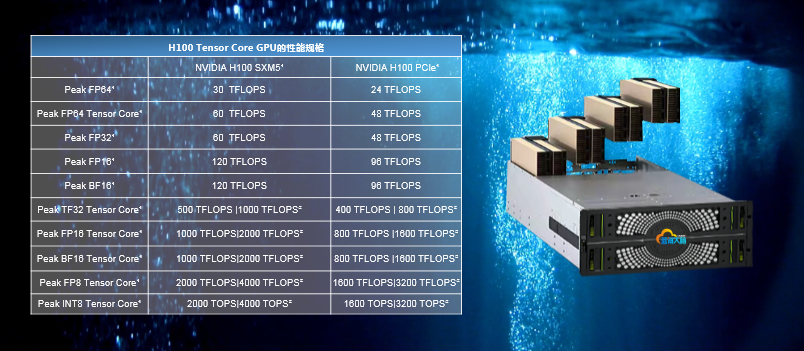

碾压性的性能对比

白皮书揭露了新的 H100 两款 FP32 算力(一般用户可以关注的指标),132 组 SM/16896CUDA 的 SXM5 版本,FP32 单精度算力为 60TFlops。根据 CSDN 一篇文章提供的公式:单精度理论峰值=FP32 cores*GPU 频率*2,可以推出工作频率约为 1775MHz。而 A100 加速卡的 GA100 核心工作频率为 1410MHz,频率提升近 26%。GeForce 产品使用的 GPU 往往会给到更高的频率,下一代 RTX 40 有望 2G 起步?

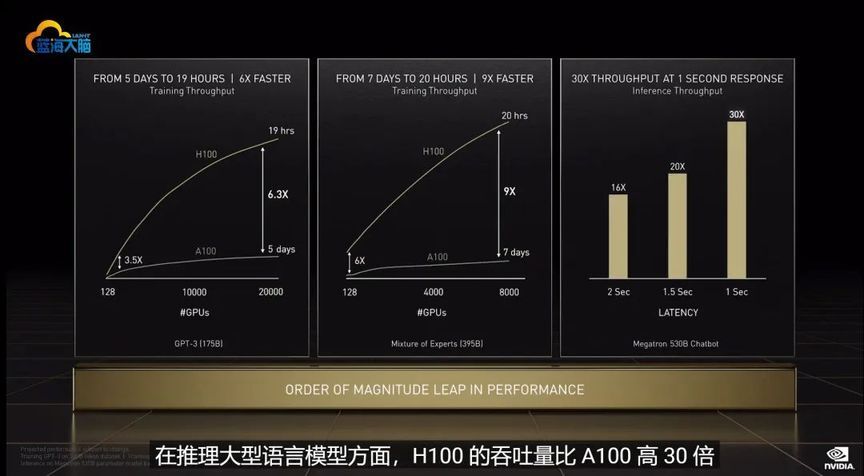

在算力方面,H100 SXM5 对比现在的 A100 在多个项目中都超过 200%的提升,最低的 FP16 半精度运算也有 50%的性能提升,可谓是碾压级。

在演讲上,老黄更是直接带来 H100 在三种负载下对比 A100 的效率提升,训练 Transformer 模型从 5 天缩短到了 19 小时,而在结合英伟达多项尖端软硬件条件下,整个模型训练从 7 天缩短到了 20 小时,效率足足提升 9 倍。

新一代 DGX H100,内置 8 块 H100 加速器

蓝海大脑是全球领先的 AI 服务器厂商,拥有丰富的 AI 计算产品阵列,并和 AI 客户紧密合作,帮助其在语音、语义、图像、视频、搜索等各方面取得数量级的 AI 应用性能提升。

2 高性能机架式服务器散热

随着信息技术的快速发展,对高性能服务器的需求越来越大。为保证服务器长期可靠稳定的运行,合适的散热技术非常重要。下面以高性能机架式服务器为研究对象,分析比较强制风冷与间接液冷下服务器的散热效果。结果表明,在低负荷下,强制风冷与间接液冷差别不大。在高负荷下,间接液冷的散热效果优于强制风冷。

一、研究背景

随着信息技术的快速发展,尤其是 5G 通信技术的出现,支撑大数据运行的服务器需求不断增长。为保障服务器稳定运行,合适的散热技术显得至关重要。机架式服务器是指按照工业标准可以直接安装在 19 英寸宽机柜中的服务器。目前机架式服务器的主流散热方式为强制风冷和间接液冷。

二、基于强制风冷的服务器散热仿真研究

2.1 仿真边界条件设置

一般情况下,当流体速度小于 1/3 风速时,可将流体看作不可压缩流体,因此可将服务器内部空气视作不可压缩流体。服务器内部一共有 6 颗轴流式风扇,其中电源模块单独有一个轴流风扇冷却。轴流风扇采用吹风散热方式冷却 CPU 和内存,硬盘最靠近进风口,出风口压力设为大气压力,环境温度设为 25℃。

2.2 仿真结果分析

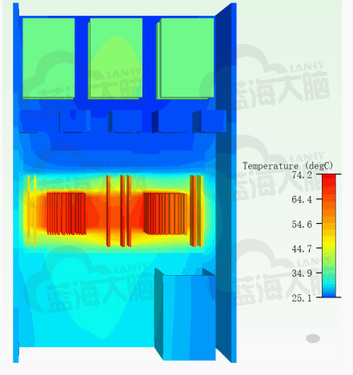

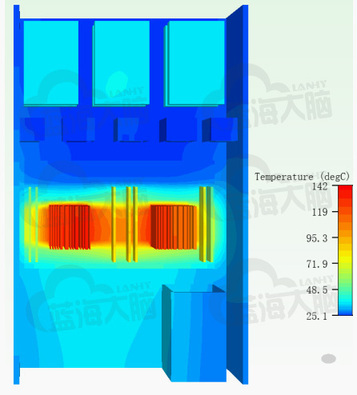

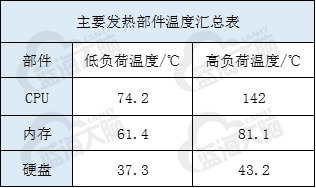

服务器散热效果评价指标有 CPU、内存、硬盘的最高温度。环境温度 25℃,忽略服务器与外界环境的辐射换热,分别对服务器低负荷和高负荷两种状态进行仿真。

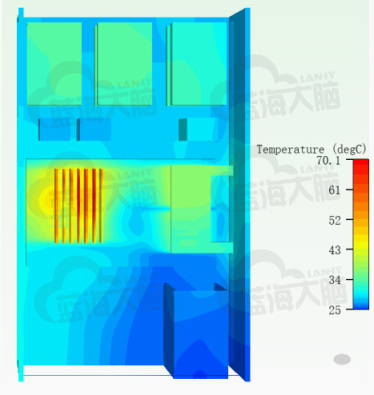

低负荷下服务器内部温度云图

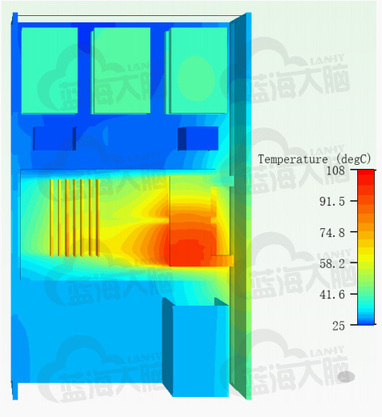

高负荷下服务器内部温度云图

从图可以看出,无论是低负荷还是高负荷,服务器内部最高温度出现在 CPU 上,其次是内存的温度较高,而硬盘最靠近进风口,其温度最低。

下表为服务器主要发热部件的温度汇总表。在低负荷状态下,服务器各部件的温度均得到较好的控制,CPU 温度低于长期运行允许的温度值;而在高负荷状态下,CPU 的温度急剧上升,超过峰值允许的温度值。

三、基于间接液冷的服务器散热仿真研究

3.1 机架式服务器液冷仿真模型建立

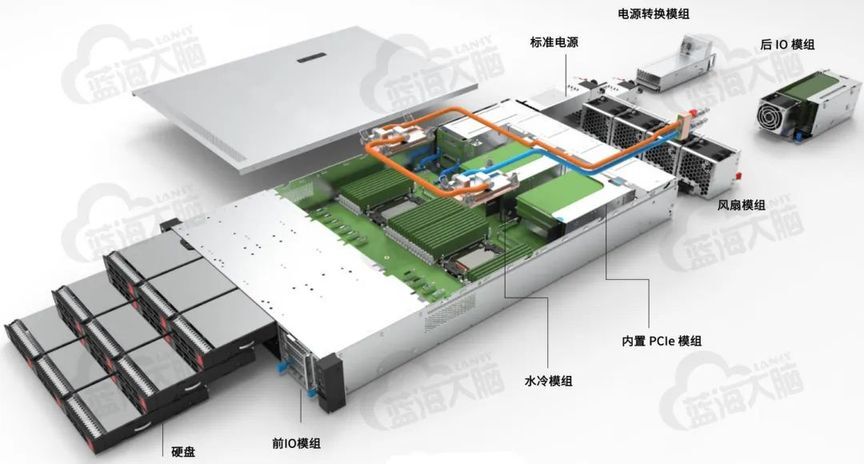

间接液冷机架式服务器内含电源模块、CPU(两个)、内存、硬盘、液冷板、水泵等部件。

间接液冷机架式服务器简化模型

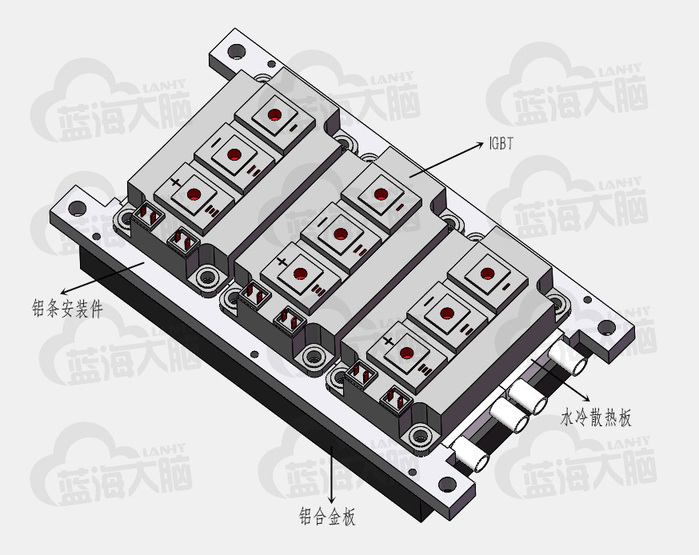

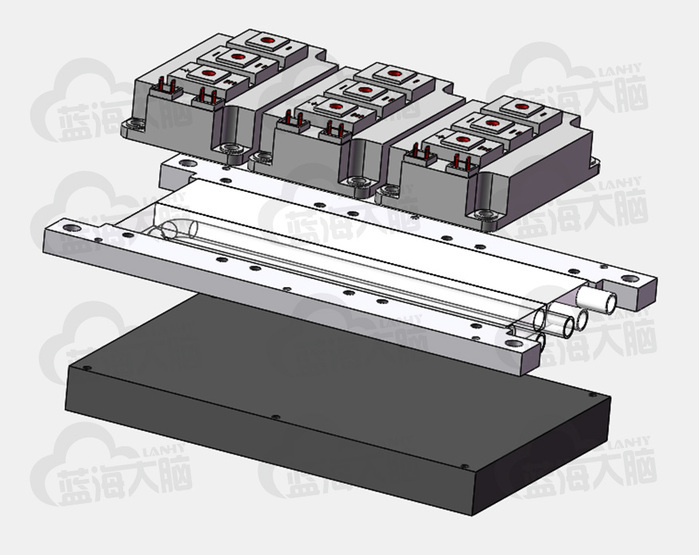

液冷散热板作为水冷系统的重要组成部分,主要是将发热元器件产生的热量与冷却液充分交换。水冷系统部分如图所示,由 IGBT、水冷散热板、铝合金板以及铝条安装件组成。

水冷系统部分三维示意图

水冷系统部分三维爆炸图

一般情况下,当流体速度小于 1/3 风速时,可将流体看作不可压缩流体,因此可将服务器内部空气以及流道内液体视作不可压缩流体。服务器内部一共有 4 颗轴流式风扇,其中电源模块单独有一个轴流风扇冷却。轴流风扇采用吹风散热方式冷却 CPU 和内存,硬盘最靠近进风口,出风口压力设为大气压力,环境温度设为 25℃,液冷板入口流体温度为 25℃。

3.2 仿真结果分析

服务器散热效果评价指标有 CPU、内存、硬盘的最高温度。环境温度 25℃,忽略服务器与外界环境的辐射换热,分别对服务器低负荷和高负荷两种状态进行仿真。

低负荷下服务器内部温度云图

高负荷下服务器内部温度云图

从图可以看出,在低负荷状态时,最高温度出现在内存上,当服务器处于高负荷时,服务器内部最高温度出现在 CPU 上,其次是内存的温度较高,而硬盘最靠近进风口,其温度最低。

下表为服务器主要发热部件的温度汇总表。在低负荷状态下,服务器各部件的温度均得到较好的控制,CPU 温度低于长期运行允许的温度值;在高负荷状态下,CPU 的温度稍有上升,但没超过峰值允许的温度值。与强制风冷相比,间接液冷方式下,内存和硬盘的温度稍有升高,这是因为减少风扇的原因;而 CPU 的温度降低,因为水的导热系数和比热容等远大于空气的导热系数和比热容。因此对于高负荷的服务器,建议采用间接液冷散热方式。

3 蓝海大脑液冷散热服务器

基于蓝海大脑超融合平台的水冷 GPU 服务器及水冷 GPU 工作站采用绿色冷却技术,Gluster 分布式架构设计,提供大存储量,拥有开放融合的特性和超能运算的能力。支持多块 GPU 显卡,提供出色的静音效果和完美的温控系统。借助 NVIDIA GPU 计算卡可加快神经网络的训练和推理速度,更快地创作精准的光照渲染效果,提供高速视频、图像、声音等处理能力,加速 AI 并带来更流畅的交互体验。

END

评论