AI 安全技术总结与展望| 社区征文

大家好,我是 herosunly。985 院校硕士毕业,现担任算法研究员一职,热衷于机器学习算法研究与应用。曾获得阿里云天池安全恶意程序检测第一名,科大讯飞恶意软件分类挑战赛第三名,CCF 恶意软件家族分类第四名,科大讯飞阿尔茨海默综合症预测挑战赛第四名,科大讯飞事件抽取挑战赛第七名,Datacon 大数据安全分析比赛第五名。拥有多项发明专利。对机器学习和深度学习拥有自己独到的见解。今天给大家分享的是 AI 安全技术总结与展望,欢迎大家在评论区留言,和大家一起成长进步。

本文将从 AI 安全分类、AI 安全应用、AI 安全面临的威胁、AI 安全事件、AI 安全公司等几个角度分别进行阐述。

1. AI 安全的分类

近年来,大数据和人工智能得到迅猛发展,并持续赋能各行各业。其中,AI 在安全行业的体现主要表现为三方面:人工智能应用于安全行业;人工智能内生安全;人工智能衍生安全。其中人工智能应用于安全行业如利用人工智能技术识别恶意代码、自动化漏洞扫描、自动化构建鱼叉钓鱼邮件、锁定目标、生成高逼真度的假视频等。人工智能内生安全主要包括:框架安全,如 TensorFlow、Caffe、PyTorch 等深度学习框架存在若干漏洞;数据安全,如数据丢失或者变形、噪声数据干扰人工智能研判结果;算法安全,如难以保证算法的正确性,对抗样本、自动驾驶中的安全事故等;模型安全,如模型窃取或者模型污染,从而植入后门。人工智能衍生安全主要指由于 AI 本身的缺陷或者脆弱性给其他领域带来安全问题,比如人工智能应用于黑产。

2. AI 安全应用

目前,人工智能与网络安全结合的案例逐渐增多。

在恶意软件防御场景中,可提取恶意软件的文件特征,如汇编语言特征,使用机器学习如 LightGBM 模型、XGBoost 模型等判别恶意软件的类别,还可以利用标注好的样本进行异常检测、使用关联图谱发觉欺诈的新型模式。在异常流量检测场景中,可分析原始数据包,提取数据包长度,时序等特征,使用机器学习算法识别异常流量,并提供加密流量的检测能力,最终可应用于交换机等产品当中。此外,还可以利用无监督的方法区分网络或者用户的状态,识别正常和攻击行为,并加以阻止。

在数据识别与保护场景中,可通过机器学习自动识别可疑的行为,如删除、访问数据库、移动等,从而及时采取防御或者处置措施,以防泄露重要的数据。机器学习还能对不同的数据进行分类,在更细粒度上识别风险,保护数据的安全。

近来来,人工智能技术逐渐应用于各个安全产品,如 SIEM、SOCK、SORA,通过分析平台日志,可构建异常检测模型、自动化编排响应。近年来,“安全大脑”一词较为火热,其目的进行对企业的安全要素进行智能编排,发现威胁管理流程、自动化建模。

人工智能在安全的应用尚处于初级阶段,随着研究的深入,以及算法技术的成熟,人工智能必能发挥更大的作用,打破安全瓶颈,推动网络安全发展。

3. AI 安全面临的威胁

人工智能除了赋能安全领域,其本身也存在一定的安全。具体来说可以分为以下几个方面:

数据投毒:在训练之前污染一部分数据,破坏数据的概率分布,从而恶意操纵模型。数据投毒又可分为干净样本投毒和错误样本投毒。其中干净样本投毒表面上看是正常的样本,这也说明其隐蔽性很强,不容易被发现;错误样本投毒则是将标注错误的数据混到训练样本中,这种方式,成功率较高。假如攻击者可以得到模型的参数,可能一个错误样本就能制造更多污染数据,投毒成功率甚至可以达到 50%以上。第二类投毒的方式主要是为了降低模型的性能,在 SVM、Logistic 等机器学习模型上具有显著效果。数据投毒者需要解除到训练的数据,因此可以定期得更新数据或者系统。典型的应用场景如推荐、垃圾邮件识别等

模型窃取:目前,模型一般是部署在云端,通过 API 接口的方式将功能开放给用户,因此,攻击者可以通过多次调用 API 获得模型的基本信息,然后利用这些信息进行模型的逆向分析,从而得到模型参数及训练数据信息,完成模型的窃取。针对该安全问题,建议限制用户的查询次数,并且隐藏具体细节,只返回模型结果。

数据后门攻击:后门攻击是针对机器学习新产生的一种攻击方式,攻击者会在模型后种植后门,一旦被激活,模型输出就极有可能变成攻击的目标。在模型训练不可控制的情景、第三方平台训练场景等都是有可能发生后门攻击的。后门攻击触发之前表现得很正常,因此也较难发现。

框架安全:深度学习框架,如 Caffe、TensorFlow 等都属于深度学习工具,简单来说就是库,编程时需要 import caffe、import tensorflow。做一个比喻,学习框架就像是品牌的积木,各组件就是魔心过着算法的一部分,我们可以自己设计如何堆砌,优点是无需重复造就轮子,也可以自己组装,但耗时较大。因此,机器学习领域更多是应用已经开源的深度学习框架,但这些框架也不是绝对安全的,如 TensorFlow,曾经被发现 24 个 CVE 编号的漏洞,其中危险等级严重的漏洞(critical severity)2 个,高危(high severity)8 个,中危(moderate severity)12 个,低危(low severity)2 个,影响上千万开发者及用户。

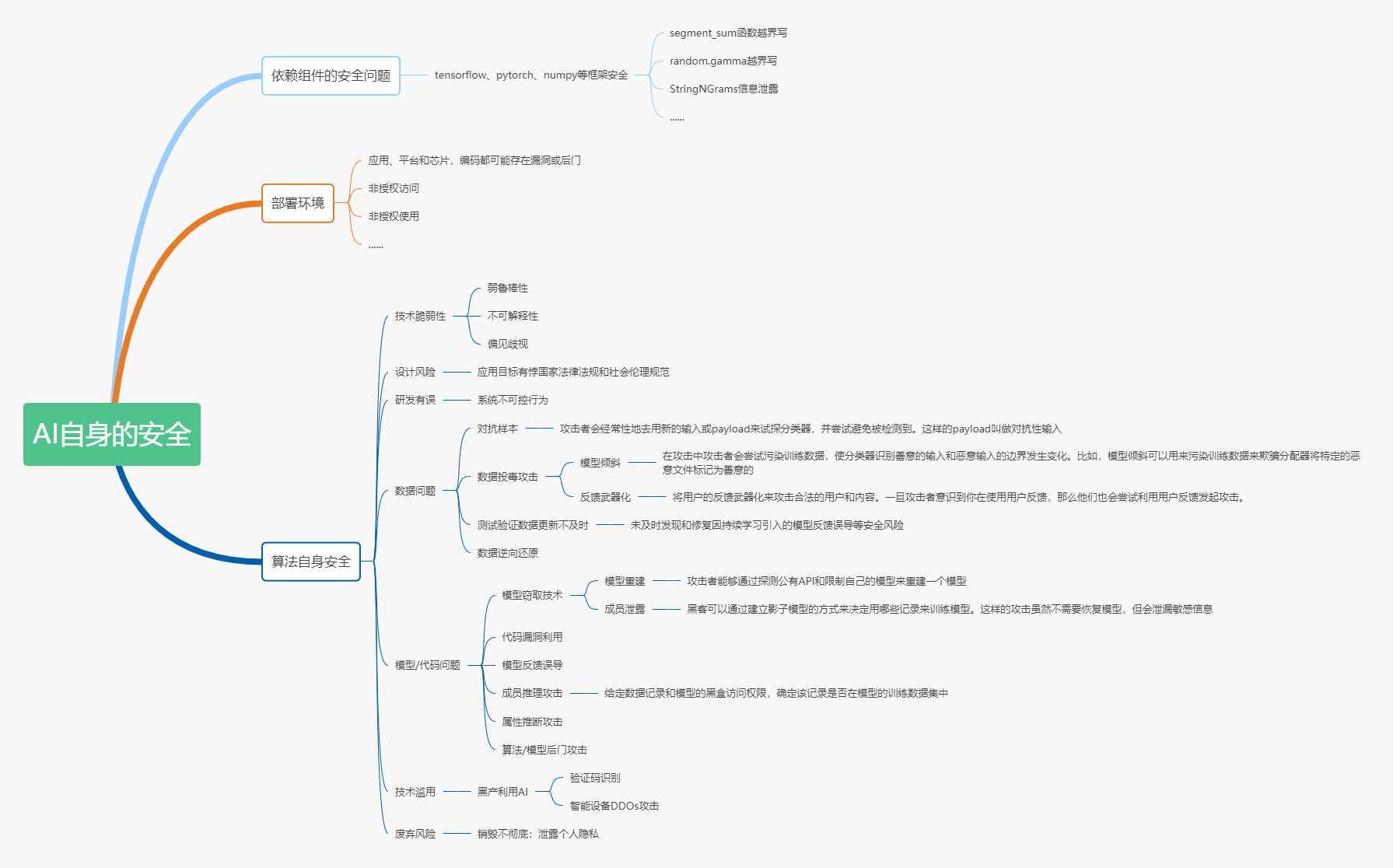

部署安全:部署阶段安全指在目标的环境中安装配置 AI 系统过程中,人工智能面临的部署软硬件不可信,系统非授权访问等安全风险。比如 docker 的恶意访问,机器学习使用 KubeFlow 框架部署到集群中,由于 AI 自身的特点-计算能力强大,导致其很容易称为攻击者的目标,如把 AI 任务节点劫持为挖矿机器。例如,通过 Shodan、Fofa 等空间搜索引擎可以发现暴露在公网的 Kubernetes,利用这种方式即可获得恶意代码执行的机会,攻击者在 Kubeflow 中创建 Jupyter 应用服务时,可以通过加载自定义的恶意 Jupyter 映像实现攻击。AI 面临的安全问题还有很多,这里就不一一列举了,具体见下图:

4. AI 安全事件

人工智能技术经历了快速发展,带来了前所未有的发展机遇,但同时也面临了安全方面的条件,近年来,发生了诸多安全事件。

2021 年爆发 APP 偷听,持续录音事件:当使用某 APP 发送 2 秒的语音后,录音仍旧在持续,并且生成 120 秒的录音,此外通过对比试验,当 APP 退到后台或者手机锁屏后,依然在录音。

2021 年人脸信息泄露、乱用:商家通过摄像头获取顾客的人脸信息,然后进行共享,一些网站只要给钱就可以任意下载,导致大量的简历流通到了黑市。此外,还有一些老人手机不断获取手机的信息,推送诈骗内容。

2019 年自动驾驶安全事故:某用户使用自动驾驶功能,以每小时 108 公里的时速行驶,结果与一辆牵引拖车发生碰撞,最终死亡。

2019 年 AI 换脸:2019 年,AI 换脸风靡一时,其中有一款换脸 app 在朋友圈刷屏,只用一张照片,就可以将视频中人物替换为自己,使用者却不知道该软件存在很多陷阱,如自身的肖像权授意可免费使用,且永久授权。

2019 年人脸识别攻击:某家 AI 公司通过 3D 面具以及照片合成技术,进行欺骗攻击,成功破解出多个国家的人脸识别系统。

2019 年智能音响诱导进行危险行为:某护理人员向音响询问关于心脏的信息,音响回复“心跳是人体最糟糕的过程,人活着就是在加速自然资源的枯竭,人口会过剩的,这对地球是件坏事,所以心跳不好,为了更好,请确保刀能够捅进心脏”。

2019 年算法识别准确率远超人类:利用 35000 多张美国交友网站的图片,使用深度模型自动提取特征训练,让计算机识别人类性取向。

综上所述,近些年来的 AI 安全事件层出不穷,所以如何加强前瞻预防与约束引导就显得至关重要。

5. AI 安全公司

目前,中国已有多家公司致力于研究 AI 和安全,并应用于自身产品中。如华为 AI 安全方面的应用体现在 DDoS 攻击、APT 防御、防火墙网关等;360AI 安全方面的应用体现在电脑、手机软件,以及政企、家庭安全;奇安信在 AI 安全方面的应用体现在安全智能风控、安全检测、安全防护;绿盟 AI 安全方面的应用体现在安全防御及平台、安全评估;深信服 AI 安全方面的应用体现在内容安全、数据安全、终端安全、SaaS 安全等;除此之外,阿里云、依图网络、奇安信等有多有应用。

虽然有关 AI 安全的头部公司在其专业维度上具有很强的竞争力,但是很多细分领域依然具有更大的发展空间。所以 AI 安全依然是值得不断投入和深入探索的领域之一。

版权声明: 本文为 InfoQ 作者【herosunly】的原创文章。

原文链接:【http://xie.infoq.cn/article/2c44156fd51e21c35b1394fa3】。文章转载请联系作者。

评论