大数据开发之如何用 Scala 进行 spark 开发

1、开发第一个 Spark 程序

1)创建一个 Spark Context

2)加载数据

3)把每一行分割成单词

4)转换成 pairs 并且计数

2、wordCount 程序

3、打包配置 jar 包大数据培训build

然后 build

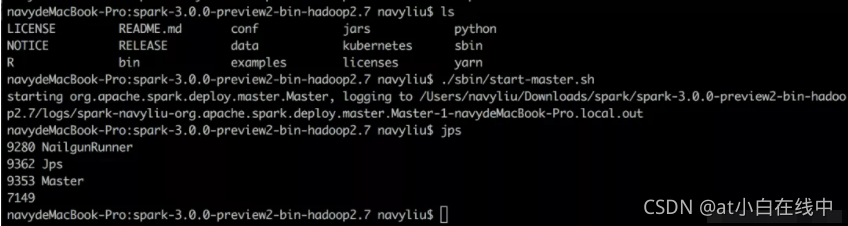

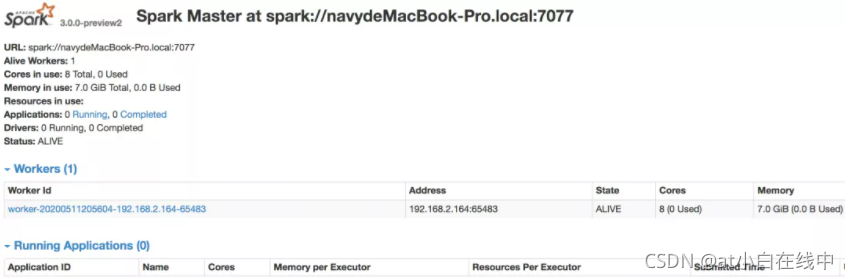

4、启动集群 1)启动 master

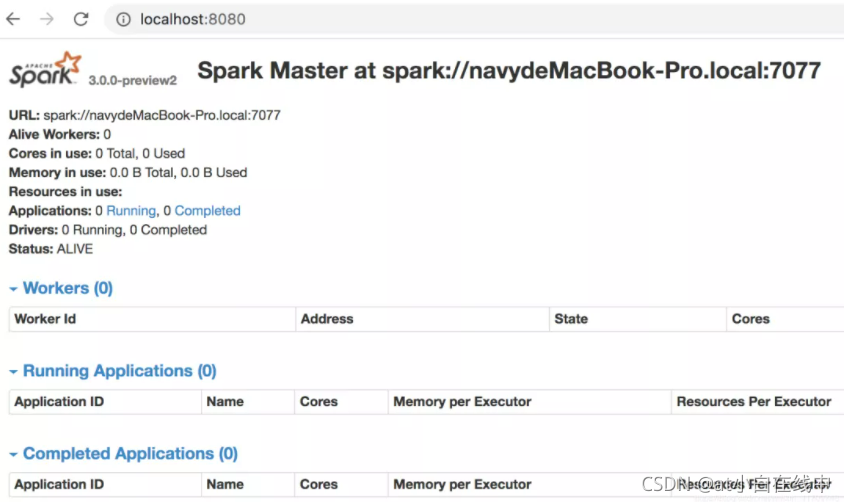

master 启动之后,可以访问下面地址:http://localhost:8080/

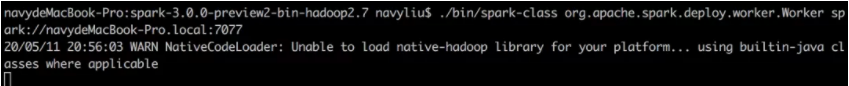

2)启动 worker

启动 work 要用到这个地址:

启动 work 的命令为:

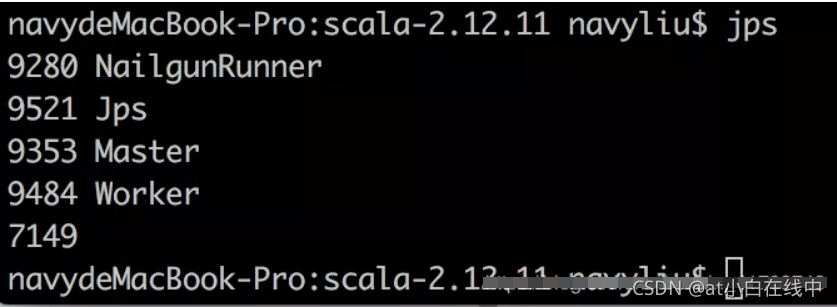

查看进程

也可以在页面中看到 worker 进程

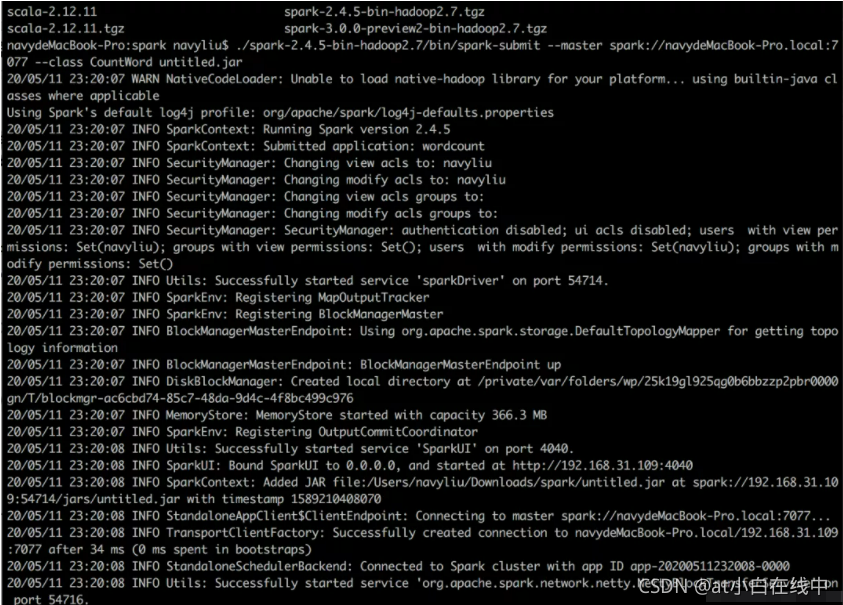

3)提交作业

提交命令

把生成的 jar 包拷到当前目录

提交作业的命令为:

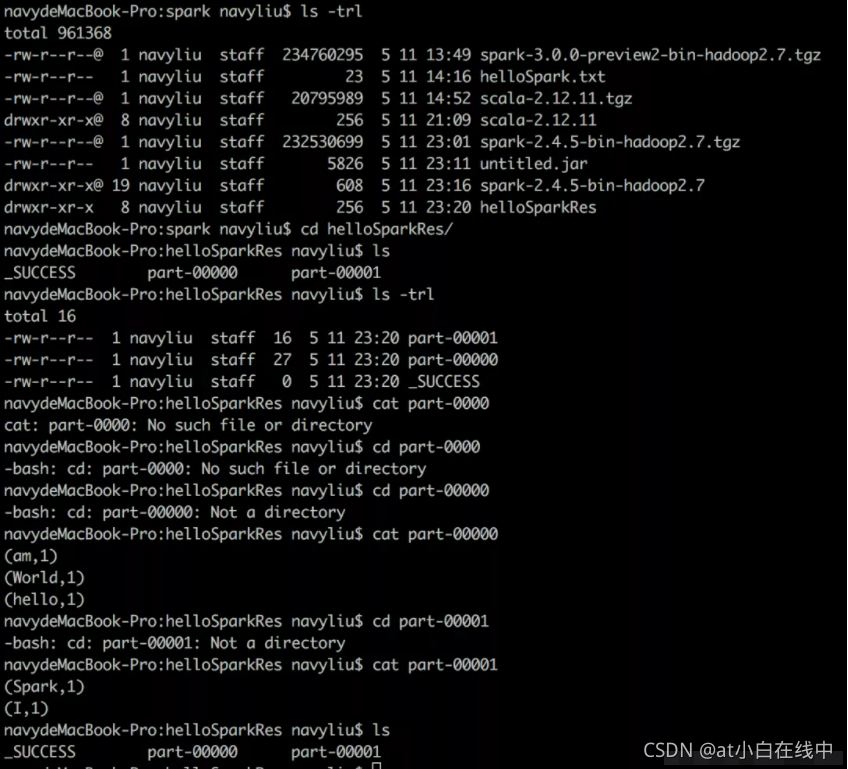

结果为:

可以看到生成了文件目录 helloSparkRes

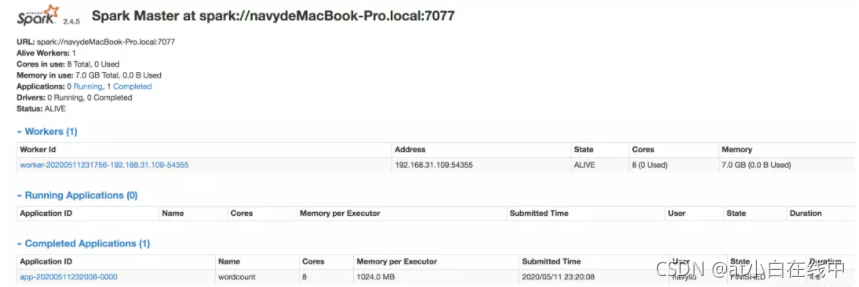

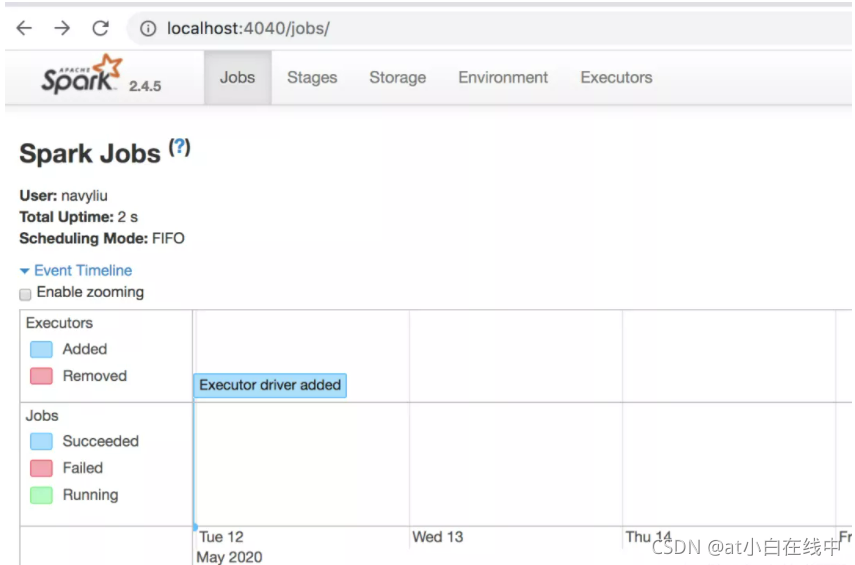

jobs 任务截图:

5、遇到的问题

如果报这种错误:

dyld: lazy symbol binding failed: Symbol not found: ____chkstk_darwin

Referenced from: /private/var/folders/91/6g1y3wp163jbr7tgdrqgkjg80000gn/T/liblz4-java-8731604412047028366.dylib

Expected in: /usr/lib/libSystem.B.dylib

dyld: Symbol not found: ____chkstk_darwin

Referenced from: /private/var/folders/91/6g1y3wp163jbr7tgdrqgkjg80000gn/T/liblz4-java-8731604412047028366.dylib

Expected in: /usr/lib/libSystem.B.dylib

原因是 scala 版本与 spark 版本冲突,重新下载 spark,版本是 2.4.5(spark-2.4.5-bin-hadoop2.7),对应的 scala 是 scala-2.12.11.

重新运行即可.

作者:归来少年 666

评论