DW-Siam:Deeper and Wider Siamese Networks for Real-Time Visual Tracking 更宽更深的孪生网络

论文地址:https://arxiv.org/pdf/1901.01660.pdf

摘要

目前在孪生网络追踪器中使用的主干网络相对较浅,例 AlexNet。本文研究如何利用更深和更广的卷积神经网络来增强跟踪的鲁棒性和准确性。使用改进后的网络直接替换,例如 ResNet 和 Inception,并没有带来改进。主要原因是 1)神经元感受野的大幅增加导致特征可辨性和定位精度降低; 2)卷积的网络 padding 在学习中引起位置偏差。

为了解决这些问题,我们提出了新的残差模块,以消除 padding 的负面影响,并进一步设计使用这些模块的新架构,具有受控的感受野大小和步长。设计的架构应用于 SiamFC+和 SiamRPN 时保证了实时跟踪速度。实验表明,仅仅由于所提出的网络架构,我们的 SiamFC+和 SiamRPN+分别在 OTB-15,VOT-16 和 VOT-17 数据集上,相对于原始版本获得了高达 9.8%/ 5.7%(AUC),23.3%/ 8.8%(EAO)和 24.4%/ 25.0%(EAO)的相对改进。

1.介绍

1.1 相关研究

RPN 详细介绍:https://mp.weixin.qq.com/s/VXgbJPVoZKjcaZjuNwgh-A

SiamFC 详细介绍:https://mp.weixin.qq.com/s/kS9osb2JBXbgb_WGU_3mcQ

SiamRPN 详细介绍:https://mp.weixin.qq.com/s/pmnip3LQtQIIm_9Po2SndA

1.2 本文介绍

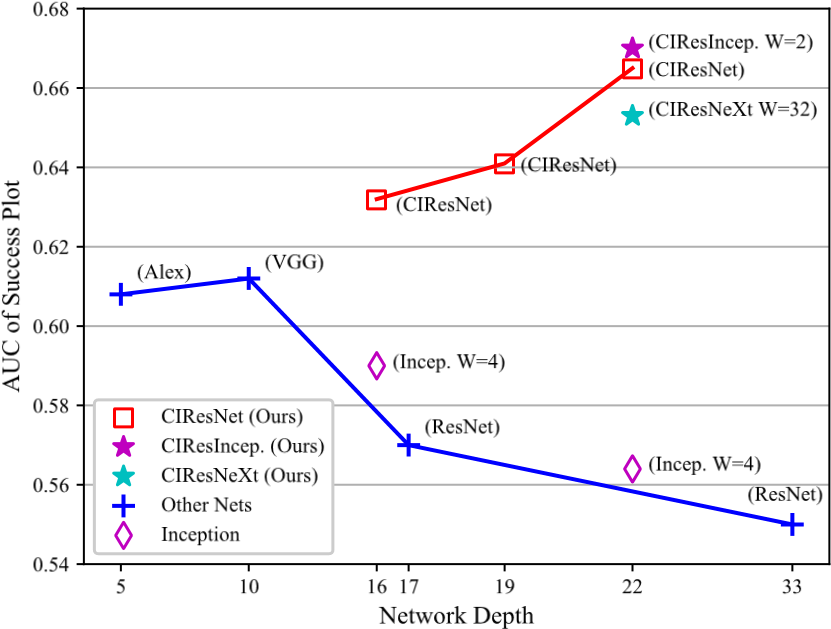

我们用更深更广的网络取代 VGG,Inception 和 ResNet 等网络的浅层主干网。但这种简单的替换并没有带来太大的改进,甚至可能在网络深度或宽度增加时导致性能大幅下降,如图 1 所示。

图 1:成功图的 AUC 与网络深度和宽度。宽度 width 是指模块中分支的数量。通过对 OTB-13 的评估,使用具有不同主干网络的 SiamFC 获得了这个结果。

分析了 Siamese 网络架构,确定神经元的感受野大小、卷积步长、padding 是影响跟踪精度的三个重要因素。感受野确定用于计算特征的图像区域。较大的感受野提供更大的图像上下文,而较小的感受野可能无法捕捉目标对象的结构。stride 影响定位精度,同时控制输出特征图的大小。padding 在模型训练中引起潜在的位置偏差。

在本文中,我们通过设计新的残差模块和网络架构来解决这些问题。首先,我们提出了一组基于“瓶颈(bottleneck)”的残差块的内部裁剪(cropping-inside residual,CIR)单元。CIR 单元在块内部裁剪出受填充 padding 影响的特征(即接收填充信号的特征),从而防止卷积滤波器学习位置偏差。其次,我们通过堆叠 CIR 单元设计了两种网络架构,即更深和更宽的网络。为了提高定位精度,我们设计了特定的步幅和感受野。

2. 性能退化分析

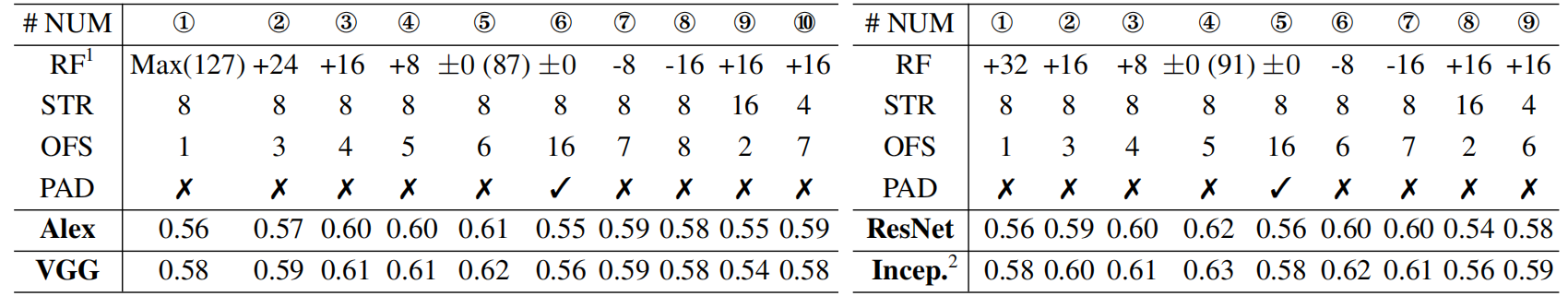

性能下降可以直接归因于网络结构,是图 1 实验中唯一改变的设置。因此,我们首先确定这些网络架构之间的结构差异。如表格 2 所示,除了深度和宽度之外,网络中还有其他几个不同的内部网络因素,包括步幅(STR),填充(PAD),最后一层神经元的感受野(RF)和输出特征尺寸(OFS)。

我们修改了 AlexNet,VGG,Inception 和 ResNet 的结构,并揭示了内部因素的影响。如表格 1 所示,Siamese 更喜欢中级特征(步幅 4 或 8),这些特征在物体定位方面比高级特征更精确(步幅≥16)。对于感受野(RF),最佳感受野大小覆盖输入样本图像 z 的约 60%~80%。对于输出特征尺寸,观察到小尺寸(OFS≤3)不利于跟踪精度。

表 1:AlexNet,VGG 10,Inception -22 和 ResNet-33 上的网络内部因素分析。数字①- ⑩代表不同的版本,其中修改卷积内核大小,下采样层和填充以显示趋势。由于空间有限,补充材料中给出了有关修改的详细信息。

1.为了更好地显示趋势,我们将±0 表示为网络的原始 RF 大小。+和-表示相对于原来的增大和减小尺寸。Max(127)表示最大有效 RF,其与示例图像的大小相同,即 127x127 像素。

2.对于 Inception 网络,其 RF 大小位于一个范围内。这里我们只列出理论上的最大尺寸,与 ResNet 对齐进行比较。

表 2:不同网络的内部因素:最后一层网络中的神经元的感受野(RF),步幅(STR),输出特征尺寸(OFS),填充(PAD)和宽度(W)。由于 Inception 在一个块中包含多个分支,因此其 RF 位于一个范围内。

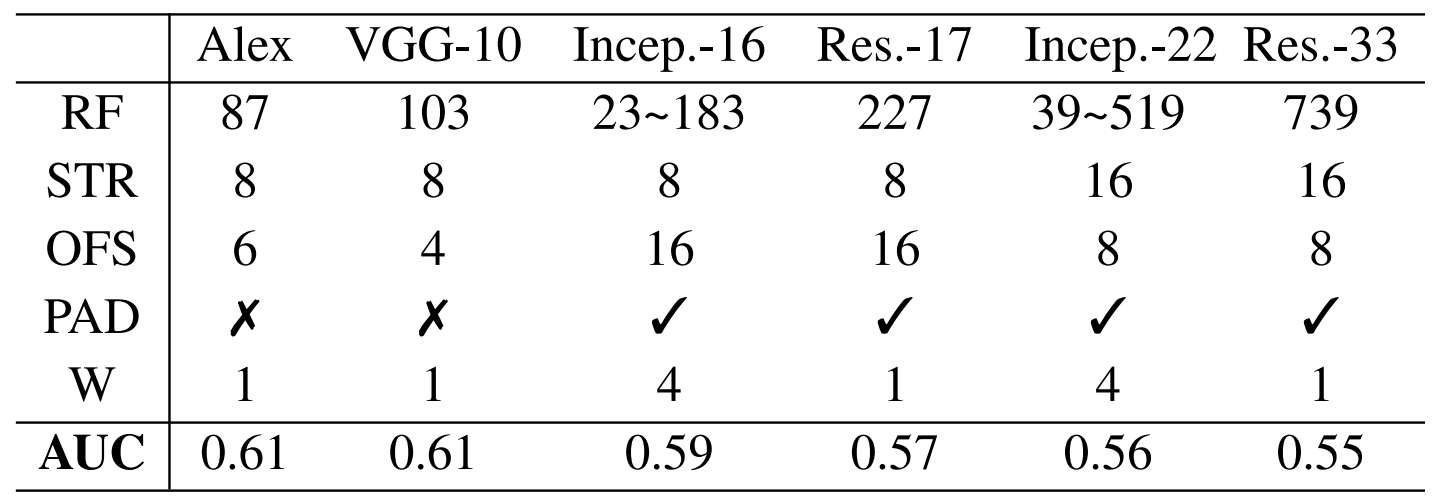

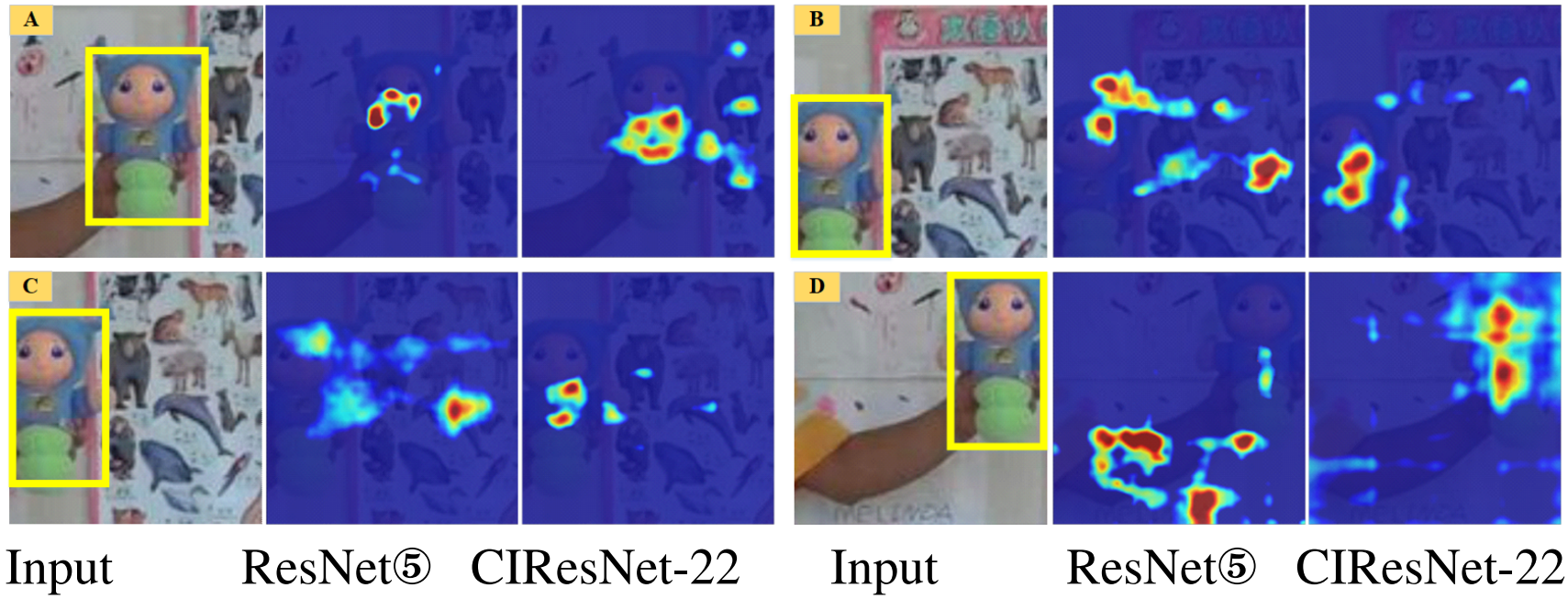

Siamese 框架将中心裁剪的图像对作为训练数据传入,其中目标对象始终存在于图像中心。如果输出单元的感受野延伸超出图像边界(受 padding 影响),网络模型学习位置产生偏差。图 2 给出了测试阶段中这种学习偏差的可视化示例。它显示当目标对象移动到图像边界时,其峰值不能精确指示目标的位置。这是由跟踪器漂移引起的常见情况。

图 2:模型中学习的位置偏差的可视化

3. 方针

1.将步幅设定为 4 或 8。

2.最佳感受野大小覆盖输入样本图像 z 的约 60%~80%

3.在设计网络架构时,应将 stride,感受野和输出特征尺寸视为一个整体。这三个因素并不是彼此独立的。如果一个改变,其他人将相应改变。将它们结合在一起可以帮助设计的网络在 Siamese 框架中提取更多的有判别力的特征。

4.对于全卷积的 Siamese 网络,删除 padding 操作重要。padding 引起的位置偏差会降低孪生跟踪器的准确性和鲁棒性。

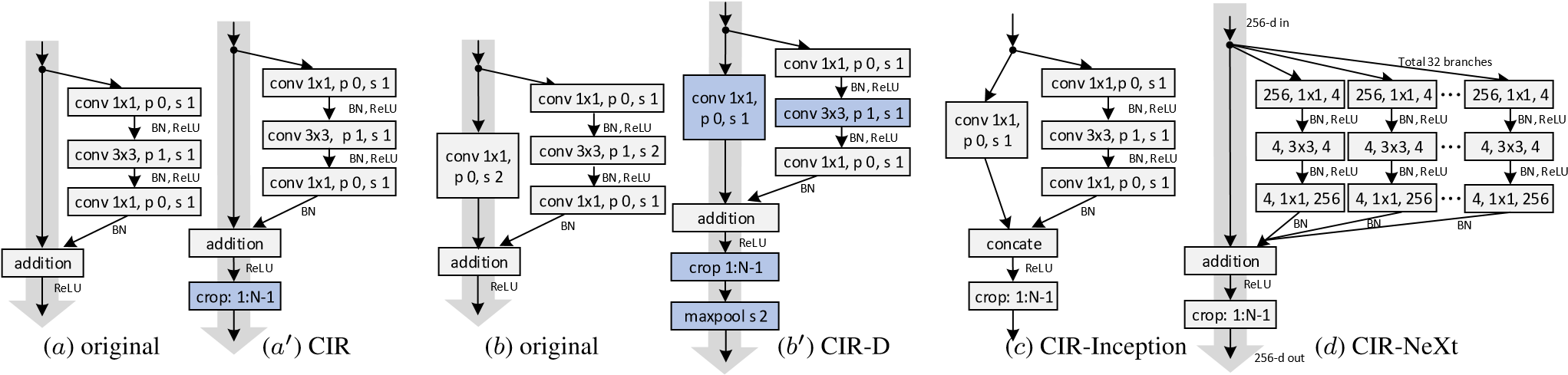

4. 内部裁剪残差(CIR)单元

残差单元(residual unit)是网络架构设计中的关键模块。它由 3 个堆叠的卷积层和绕过它们的快捷连接(shortcut connection)组成,如图 3(a)所示。这三层是 1×1,3×3 和 1×1 个卷积,其中 1×1 层负责减少或恢复尺寸,使 3×3 层成为具有较小输入和输出尺寸的瓶颈(bottleneck)。此瓶颈卷积包括大小为 1 的 zero-padding,以确保在添加之前兼容的输出大小。

图 3:拟议的内部残余单位。(a)和(b)是残差单元和下采样单元(down sampling unit),而(a‘)和(b’)是我们提出的单位。(c)和(d)是建议的宽残差单元。灰色箭头表示便于信息传播的 shortcut paths,而蓝色方框则突出显示与原始单位的差异。字母'p'和's'分别表示 padding 大小和步长。

CIR 单元。如第 3 节所述,padding 可能会在 Siamese 框架中引入位置偏差。为此我们增加残差单位进行裁剪操作,如图 3(a’)所示。裁剪操作会删除计算受 zero-padding 信号影响的特征,消除了残差单元中的 padding 影响特征。

下采样 CIR(CIR-D)单元。它用于减少特征图的空间大小,同时使特征通道的数量加倍。下采样单元包含 padding 操作,如图 3(b)所示。因此,我们还修改其结构以消除由 padding 引起的负面影响。如图 3(b’)所示,我们在瓶颈层和 shortcut connection 中将卷积步幅从 2 改为 1。插入裁剪以移除受 padding 影响的特征。最后,使用最大池化层来执行特征图的空间下采样。这些修改的关键思想是确保仅删除受填充影响的特征,同时保持内部块结构不变。

CIR-Inception 和 CIR-NeXt 单元。根据 Inception 和 ResNeXt,通过多个特征变换扩展 CIR 单元,生成 CIR-Inception 和 CIR-NeXt 模块,如图 3(c-d)所示。具体来说,在 CIR-Inception 结构中,我们在 shortcut connection 中插入一个 1x1 卷积,并合并两个分支的特征。在 CIR-ResNeXt 中,我们将瓶颈层拆分为 32 个转换分支,并通过添加进行聚合。此外,对于 CIR-Inception 和 CIR-NeXt 的下采样单元,修改与 CIR-D(图 3(b’))中的修改相同,其中卷积步幅减小并且增加了最大池化层。

5. 网络架构 Network Architectures

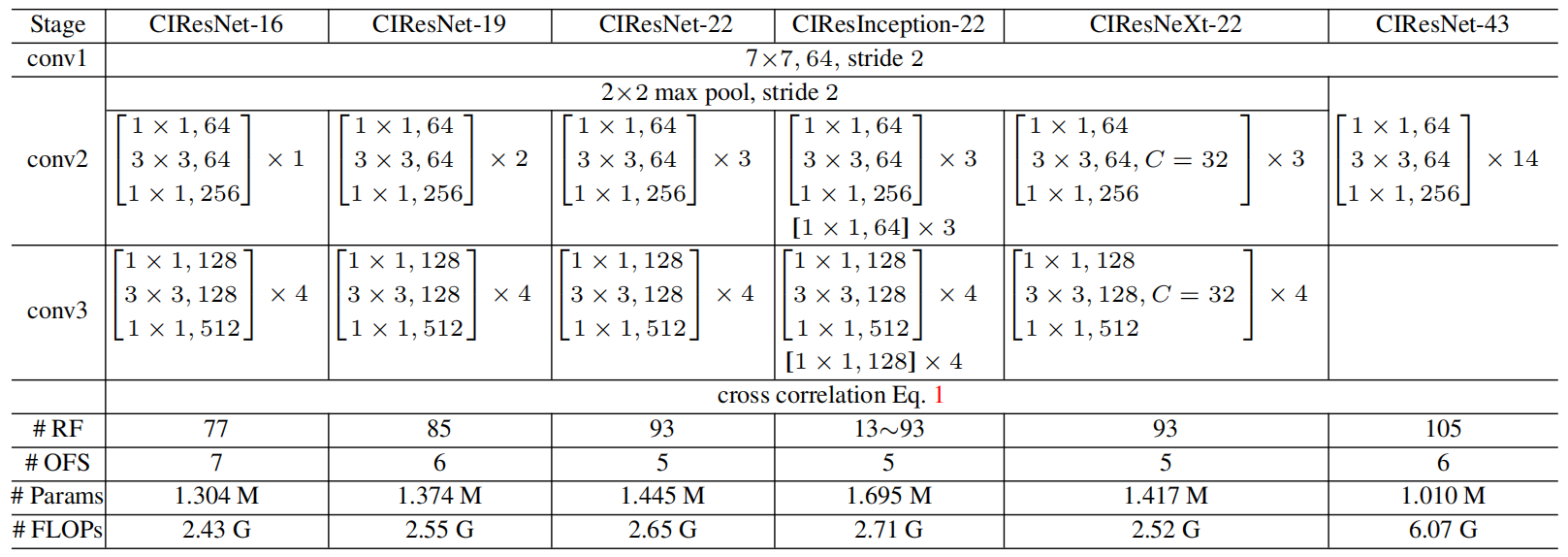

通过堆叠上述 CIR 单元,我们构建了更深更宽的网络。首先确定 stride,步幅 8 用于构建 3 级网络,而步幅 4 用于构建 2 级网络。然后,我们堆叠 CIR 单位。我们控制每个阶段的 unit 数量和下采样 unit 的位置。目标是确保最后一层神经元的感受野大小位于有效范围内,即样本图像大小的 60%-80%。另外,当网络深度增加时,感受野可能超过该范围。因此,我们将步幅减半,以控制感受野。

更深的网络。我们使用 CIR 和 CIR-D 单元构建更深的网络。这些结构类似于 ResNet,但具有不同的 stride,感受野和结构单元(building blocks)。

CIResNet-22 有 3 个部分(stride=8),22 个卷积层。除了第一个 7×7 卷积,其他都是 CIR 单位。在 7×7 卷积之后进行裁剪操作(大小为 2)以移除受 padding 影响的特征。前两个阶段的特征下采样是通过原来 ResNet 的卷积和步幅 2 的最大池化来执行的。在第三阶段,通过所提出的 CIR-D 单元执行下采样,该 CIR-D 单元位于该阶段的第一个块(共四个)。当 feature map 大小被下采样时,卷积核的数量加倍以增加特征可辨别性。输出 feature map 大小是 5×5,每个 feature 感受野的相应大小 93×93。

构建 CIResNet-43 时进一步将网络深度增加到 43 层,设计为 2 个阶段,在 CIResNet-43 的第二阶段,有 14 个块,其中第四个块具有用于特征下采样的 CIR-D 单元。

更宽的网络。我们分别使用 CIR-Inception 和 CIR-NeXt 单元构建两种类型的宽网络体系结构。我们提供一个 22 层结构作为示例。正如表 3 所示,CIResInception-22 和 CIResNeXt-22 具有与 CIResNet-22 类似的结构。但是通过多分支构建块,网络宽度分别增加了 2 倍和 32 倍。而且,由于多分支级联,在 CIResInception-22 中感受野大小变得多样化(即 13~93)。

表 3:用于连体跟踪器的设计骨干网络的架构。CIResNet-43 中 CIR-D 位于'conv3'阶段的第四个块中,其他网络用于第一个块。

6. 实验

我们首先将我们更深更宽的网络与 SiamFC 和 SiamRPN 中的主干 AlexNet 进行比较。正如表 4 中所示,在 OTB-13,OTB-15 和 VOT-17 数据集上,我们提出的网络优于基线 AlexNet。特别是,配备 CIResIncep-22 网络的 SiamFC 分别在 OTB-2013 和 VOT-1 上获得了比原始 AlexNet 高 9.5%(AUC)和 14.3%(EAO)的相对改进。同时,配备 CIResNet-22 的 SiamRPN 实现了 4.4%和 23.3%的相对改善。这验证了我们设计的体系结构解决了图 1 中所示的性能下降问题。此外,它还显示了我们提出的 CIR 单元对于连体网络的有效性。

学习更多编程知识,请关注我的公众号:

评论