AdaBoost 算法解密:从基础到应用的全面解析

本文全面而深入地探讨了 AdaBoost 算法,从其基础概念和原理到 Python 实战应用。文章不仅详细解析了 AdaBoost 的优缺点,还通过实例展示了如何在 Python 中实现该算法。

一、简介

AdaBoost(Adaptive Boosting,自适应增强)是一种极为强大的集成学习算法,于 1997 年由 Yoav Freund 和 Robert Schapire 正式提出。它通过将多个简单模型(也称为弱学习器)组合成一个复杂模型(强学习器)来工作。AdaBoost 在一系列应用场景中都表现出了显著的性能优势,从文本分类、图像识别到生物信息学等领域都有广泛的应用。

什么是 AdaBoost

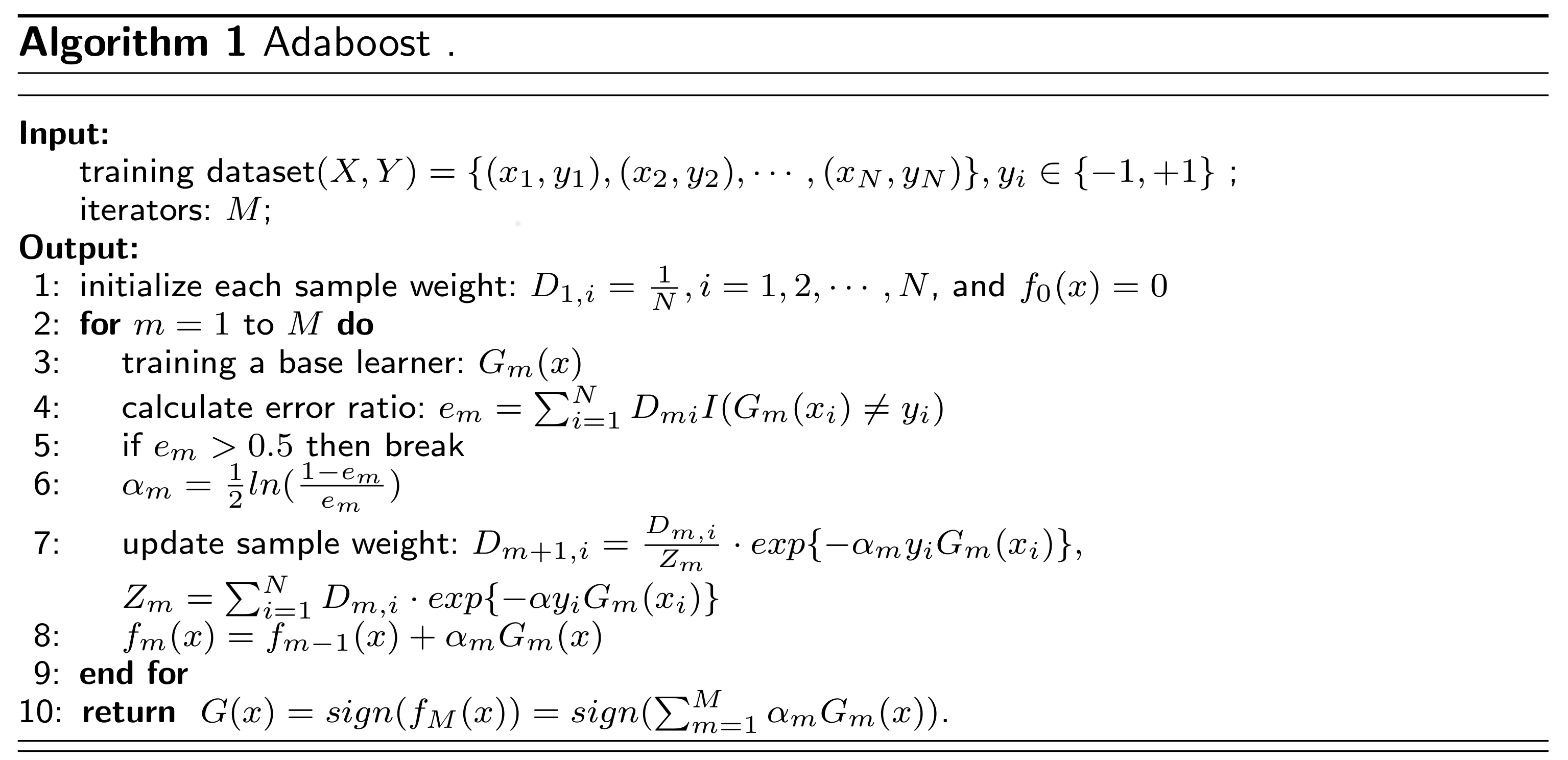

AdaBoost 算法的核心思想是在每一轮迭代中,通过增加那些被前一轮弱学习器错误分类的样本权重,并减少那些被正确分类的样本权重,来“迫使”新的弱学习器更加关注那些“难以分类”的样本。随后,算法将所有弱学习器的预测结果进行加权平均或加权投票,以得到最终的强学习器。

AdaBoost 的历史和重要性

AdaBoost 的历史可以追溯到 1990 年代早期的一系列研究工作。但直到 1997 年,Freund 和 Schapire 提出了 AdaBoost 算法的正式定义和理论证明,这一算法才真正受到广泛关注。值得注意的是,这项工作为二者赢得了 2003 年的 Gödel 奖,这在某种程度上证明了 AdaBoost 在机器学习和数据科学领域的重要性。

AdaBoost 算法不仅在理论上具有良好的基础,而且在实践中也展示出高度的可扩展性和准确性。由于其能够提升模型性能,并且相对不易出现过拟合,该算法被广泛应用于各种机器学习任务。

定义

在更为正式的术语中,AdaBoost 算法可以定义为一个通过迭代方式来优化一组弱学习器(例如决策树、支持向量机或逻辑回归等)的集成方法。在每一轮迭代中,算法都会根据前一轮的错误率来调整每个样本的权重,然后训练一个新的弱学习器,以便更好地分类那些具有更高权重的样本。最终,所有弱学习器的输出会根据其相应的“学习器权重”进行加权组合,以生成一个强学习器。

二、基础概念

在深入了解 AdaBoost 算法之前,有几个基础概念是不可或缺的。这些概念有助于我们更好地理解 AdaBoost 的工作原理和实际应用。

集成学习(Ensemble Learning)

定义

集成学习是一种机器学习范式,旨在结合多个模型以改善单个模型无法达到的整体性能。通常,这意味着将多个弱学习器(或基础模型)组合到一个强学习器中。

示例

假设你有三个基础的分类模型:逻辑回归、决策树和 K-近邻(K-NN)。每个模型在某个数据集上的准确率分别为 70%、65%和 75%。通过集成学习(例如,采用投票机制),你可能得到一个准确率高达 80%的强学习器。

弱学习器和强学习器

定义

弱学习器(Weak Learner): 一个弱学习器是一个性能略优于随机猜测的机器学习算法。在二分类问题中,这通常意味着其准确率略高于 50%。

强学习器(Strong Learner): 相对于弱学习器,强学习器是一个在给定任务上性能表现非常好的模型,准确率远高于随机猜测。

示例

弱学习器: 在一个用于区分猫和狗的二分类问题中,一个只通过动物的体重进行分类的模型可能是一个弱学习器,因为体重这一特征并不能准确地区分猫和狗。

强学习器: 在同一个问题中,一个综合了体重、体长、声音和毛色等多个特征的模型则可能是一个强学习器,因为它能更准确地进行分类。

三、AdaBoost 算法原理

AdaBoost 是一种迭代算法,其工作原理建立在逐步优化一系列弱学习器的基础上。在这一部分,我们将深入探讨 AdaBoost 算法的核心组件和工作流程。

样本权重(Sample Weights)

定义

样本权重是一个数值,用于描述模型应该多大程度上关注某一个训练样本。在 AdaBoost 中,样本权重是动态调整的,以便让模型在后续迭代中更多地关注之前分类错误的样本。

示例

假设我们有一个二分类问题,其中包括 5 个样本。在第一轮迭代后,其中 3 个样本被错误分类。这些被错误分类的样本的权重将会增加,以便在下一轮训练中得到更多的关注。

学习器权重(Learner Weights)

定义

每个弱学习器在最终模型中的影响力是由其“学习器权重”决定的。这个权重是基于该学习器在训练数据上的性能来计算的。

示例

如果一个弱学习器在带权重的训练数据上表现出 85%的准确率,而另一个仅有 65%,则第一个学习器在最终模型中的权重将会更大。

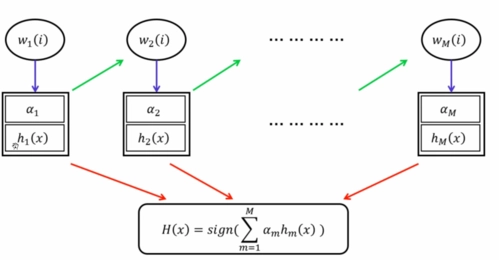

加权平均/加权投票(Weighted Average/Voting)

定义

在 AdaBoost 算法中,弱学习器的预测结果不是简单地取平均或者投票来决定最终输出,而是通过加权平均或加权投票来进行的。这里的权重就是之前提到的学习器权重。

示例

假设有三个弱学习器,其学习器权重分别是 0.2、0.5 和 0.3,而各自对一个样本的预测输出是 1、-1 和 1。最终的预测结果将会是 0.2*1 + 0.5*(-1) + 0.3*1 = -0.1,由于结果小于 0,因此最终分类为-1。

迭代训练(Iterative Training)

定义

AdaBoost 算法是通过一系列迭代来进行训练的。在每一轮迭代中,都会根据当前弱学习器的性能来动态调整样本权重,并训练一个新的弱学习器。

示例

在一个用于文本分类的问题中,第一轮可能使用朴素贝叶斯分类器,第二轮可能使用决策树,第三轮可能使用逻辑回归。每一轮都会考虑前一轮中分类错误的样本,并相应地调整这些样本的权重。

四、AdaBoost 优缺点

了解一个算法的优缺点是在实际应用中作出明智决策的关键。下面,我们将探讨 AdaBoost 算法的主要优缺点,并针对每一点给出具体的示例。

优点

易于实现

定义

AdaBoost 算法的结构相对简单,易于编码实现。它无需进行繁琐的参数调优,通常默认设置就能取得不错的效果。

示例

对于一个新手来说,在 Python 中使用 scikit-learn 库,几行代码就足以实现 AdaBoost 算法。这大大降低了入门门槛。

自适应性强

定义

AdaBoost 通过动态调整样本和学习器权重,具有很强的自适应性。这使得算法能在多种类型的数据集上表现良好。

示例

在一个非均衡分类问题中(例如,信用卡欺诈检测),AdaBoost 能够自动调整对少数类样本的关注度,从而改善模型的性能。

不容易过拟合

定义

相对于其他集成方法,AdaBoost 算法更不容易出现过拟合现象,尤其是在数据集较大时。

示例

在一个具有上百个特征和数万条记录的数据集上进行训练时,AdaBoost 通常能够保持良好的泛化性能。

缺点

对噪声和异常值敏感

定义

由于 AdaBoost 会增加那些被错误分类的样本权重,因此对噪声和异常值非常敏感。

示例

在一个医疗诊断系统中,如果数据集中含有错误标注或异常值,AdaBoost 算法可能会过度关注这些点,导致性能下降。

计算量可能较大

定义

由于 AdaBoost 是一种迭代算法,需要多次训练弱学习器,因此在处理大规模数据集或高维特征时,计算量可能会变得很大。

示例

在一个具有数百万数据点和数百个特征的数据集上运行 AdaBoost 可能需要大量的计算资源和时间。

解释性差

定义

虽然单个弱学习器(如决策树)可能具有较好的解释性,但是当这些弱学习器被集成后,整个模型的解释性会变差。

示例

在信贷风险评估模型中,即使我们使用解释性强的决策树作为基学习器,最终的 AdaBoost 模型可能仍然难以直观解释。

五、AdaBoost Python 实战

在本节中,我们将通过一个具体的分类问题来展示如何在 Python 环境中使用 AdaBoost 算法。我们将使用 scikit-learn 库来进行实现,因为它提供了一个易于使用的 AdaBoost 接口。

环境准备

定义

首先,确保您的 Python 环境已经安装了scikit-learn和numpy这两个库。

示例

您可以通过以下命令来安装必要的库:

数据准备

定义

为了简化问题,我们将使用 scikit-learn 中内置的鸢尾花(Iris)数据集。这是一个用于分类的数据集,包含了三种鸢尾花的各种特征。

示例

加载数据并查看前几行:

输出:

模型训练

定义

使用 scikit-learn 的AdaBoostClassifier来训练模型。这个分类器允许我们设置各种参数,如基础分类器、迭代次数等。

示例

以下代码展示了如何使用 AdaBoost 训练模型:

输出:

在这个例子中,模型在测试集上达到了 100%的准确率。这并不意味着模型是完美的,但确实表明 AdaBoost 具有非常高的分类能力。

通过这个实战示例,您应该已经对如何在 Python 中实现 AdaBoost 有了一个清晰的了解。在实际应用中,您可能会遇到更加复杂和挑战性的问题,但基础的实现原理是相同的。希望这能帮助您更好地理解和使用 AdaBoost 算法。

六、总结

AdaBoost 是一种极具影响力的集成学习算法,其在许多领域都有广泛的应用,从简单的分类问题到复杂的非均衡数据集。通过本文,我们对 AdaBoost 的基础概念、算法原理、优缺点,以及 Python 实战进行了全面而深入的探讨。

适用性与灵活性:虽然 AdaBoost 在面对噪声和异常值时可能表现得不够稳健,但它的自适应性和简单性使其成为一个出色的“入门级”集成算法。这也意味着在进行初步数据探索和建模时,AdaBoost 往往是一个很好的起点。

关注细节,但不失全局观:AdaBoost 通过对错分样本的权重进行动态调整,实现了一种微观与宏观相结合的优化策略。这种机制不仅提升了模型性能,还为我们提供了一种新的视角去理解数据的内在结构。

性能与解释性的权衡:AdaBoost 算法本身可能缺乏解释性,但它能与各种类型的基学习器(如决策树、神经网络等)结合使用。因此,我们实际上可以通过选择更易解释的基学习器来改善模型的解释性。

调参与复杂性:虽然 AdaBoost 相对容易实现,并且默认参数就能取得不错的效果,但针对特定应用场景(如高维数据、大规模数据集等)的优化仍然需要更深入的参数调整和计算资源。

综上所述,AdaBoost 算法是一把双刃剑。它简单、高效,但同时也需要我们仔细处理噪声和异常值,并考虑其计算成本和解释性。只有全面而深入地理解了这些因素,我们才能充分发挥出 AdaBoost 的潜力,解决更为复杂和多样的实际问题。

文章转载自:techlead_krischang

评论