手把手教你部署 DeepSeek 本地模型

本文目标:部署 DeepSeek 本地模型,并通过 Ollama 提供 API 支持,Chatbox 提供 UI 界面。原则:不搞那些高深的玩法,让小白也能理解并真正的上手实践。

1.下载 Ollama 并安装运行 DeepSeek

2.下载 Chatbox 并配置为本地 DeepSeek

3.无需联网也能和 DeepSeek 畅快聊天

1.下载 Ollama 并安装运行 DeepSeek

从 Ollama 官方网站下载 Ollama:

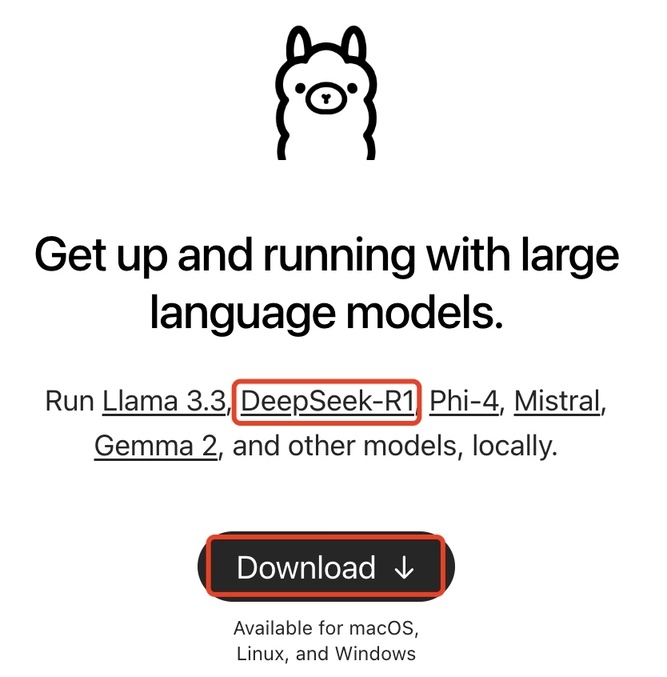

进入 Ollama 官方网站后,可以看到 Ollama 已经支持 DeepSeek-R1 的部署:

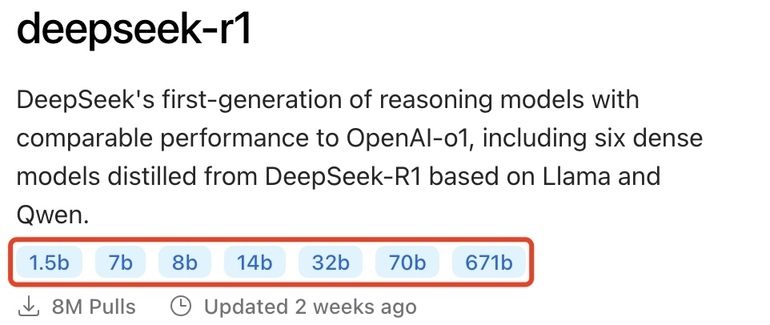

点击DeepSeek-R1的链接可以看到有关 deepseek-r1 的详细介绍:

目前 deepseek-r1 模型大小提供了 7 个选择:1.5b、7b、8b、14b、32b、70b、671b。因为我笔记本的显卡配置较低,所以这里只能选择最小的 1.5b 模型来做演示:

你可以根据你的硬件情况选择,通常模型大小(参数量)越大,模型的理解和生成能力越强,但也会消耗更多的计算资源。

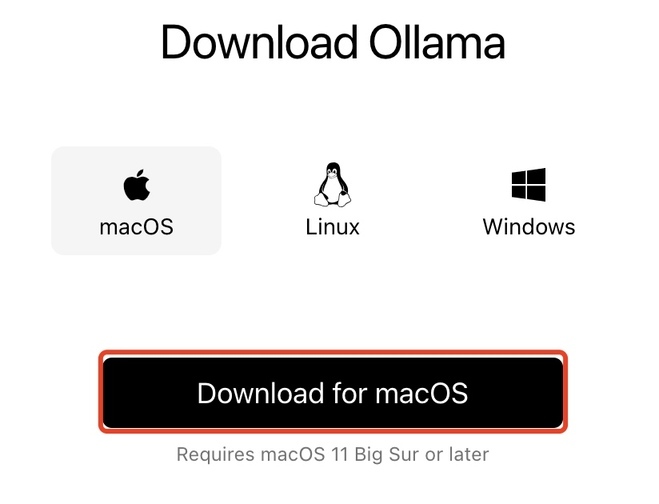

点击Download按钮下载符合自己平台的 Ollama:

我这里选择 macOS,点击下载。下载文件大小不到 200M,文件名为:Ollama-darwin.zip。

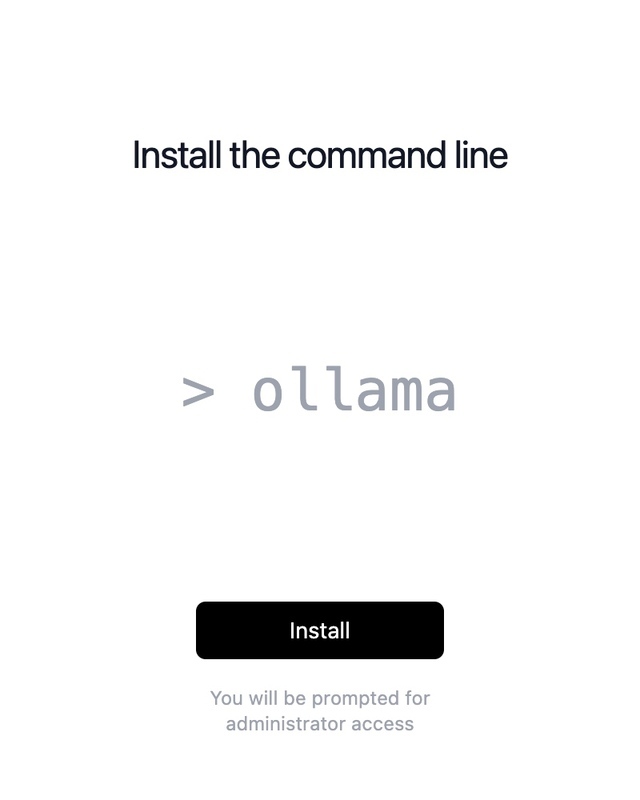

解压后打开 Ollama 应用程序,提示:

点击Install安装 ollama。

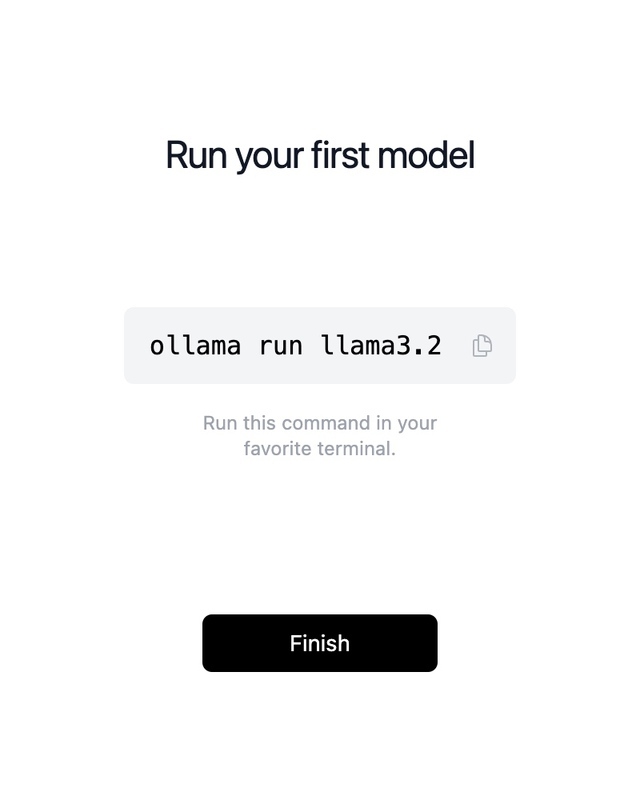

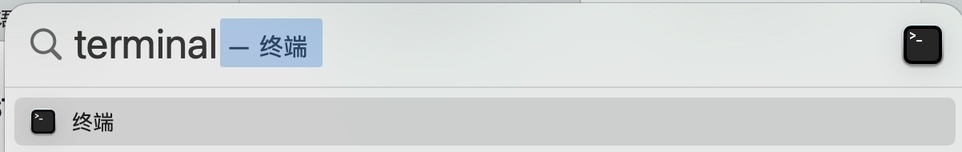

按照提示,打开终端,使用 Command + Space 快捷键调用 terminal:

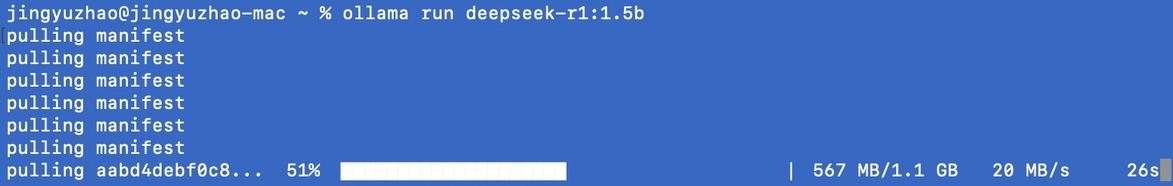

这里 Ollama 默认给出的例子是下载/运行 llama3.2 大模型,我们这里不使用这个 llama3.2 模型,直接下载/运行 deepseek,参数选择最小的 1.5b,在终端窗口运行下面命令:

这里就直接可以和 DeepSeek 对话了:

2.下载 Chatbox 并配置为本地 DeepSeek

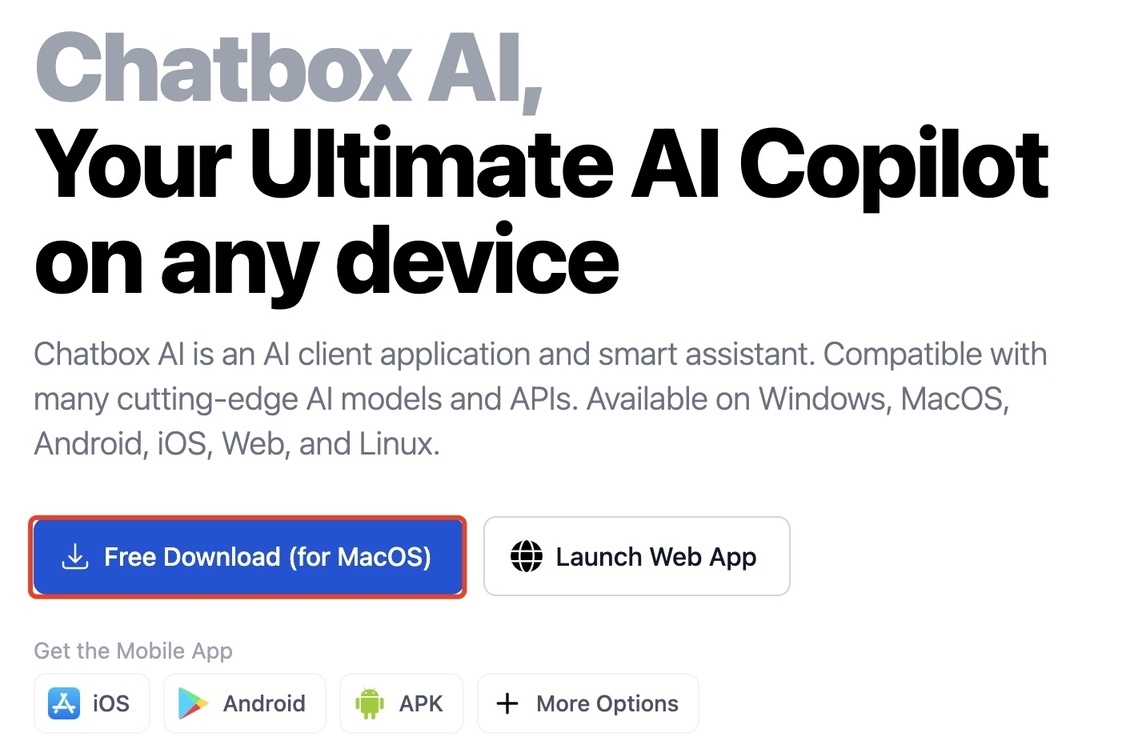

Chatbox 官方网站:

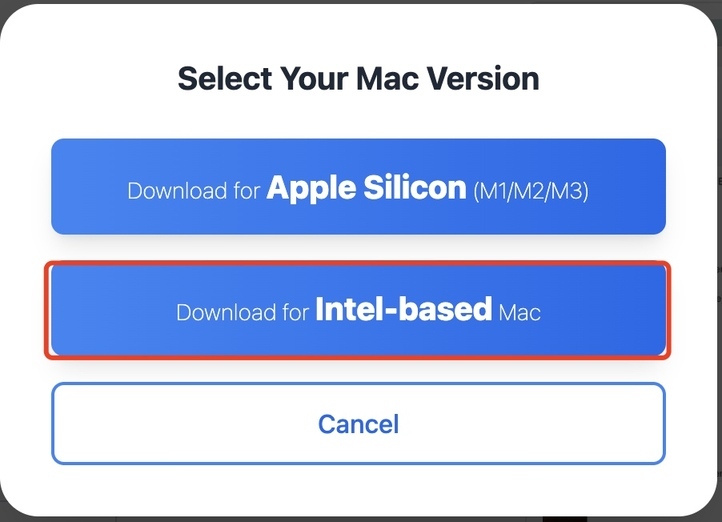

我这里还是 Intel-based 的 MAC,

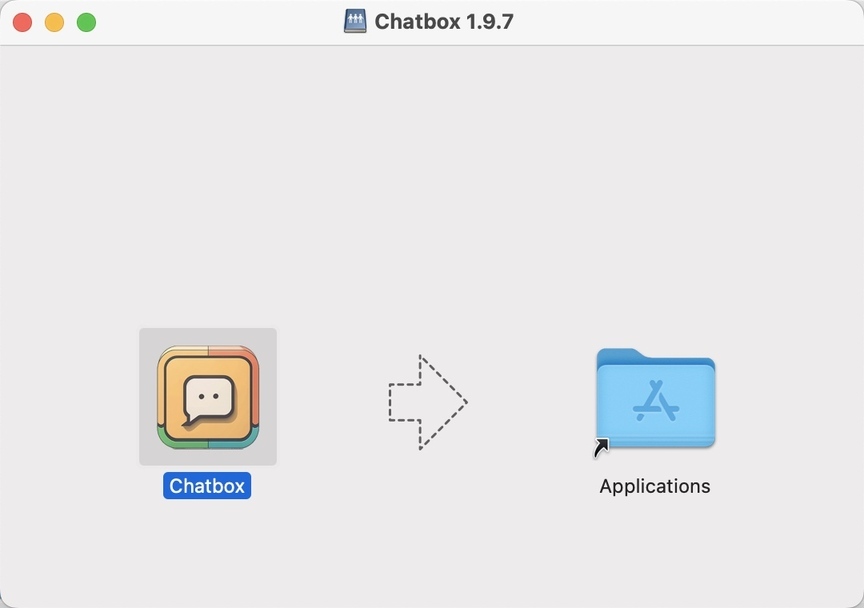

下载的Chatbox-1.9.7.dmg,大小 100M 多点,点击安装,按下面提示拖到 Applications 内:

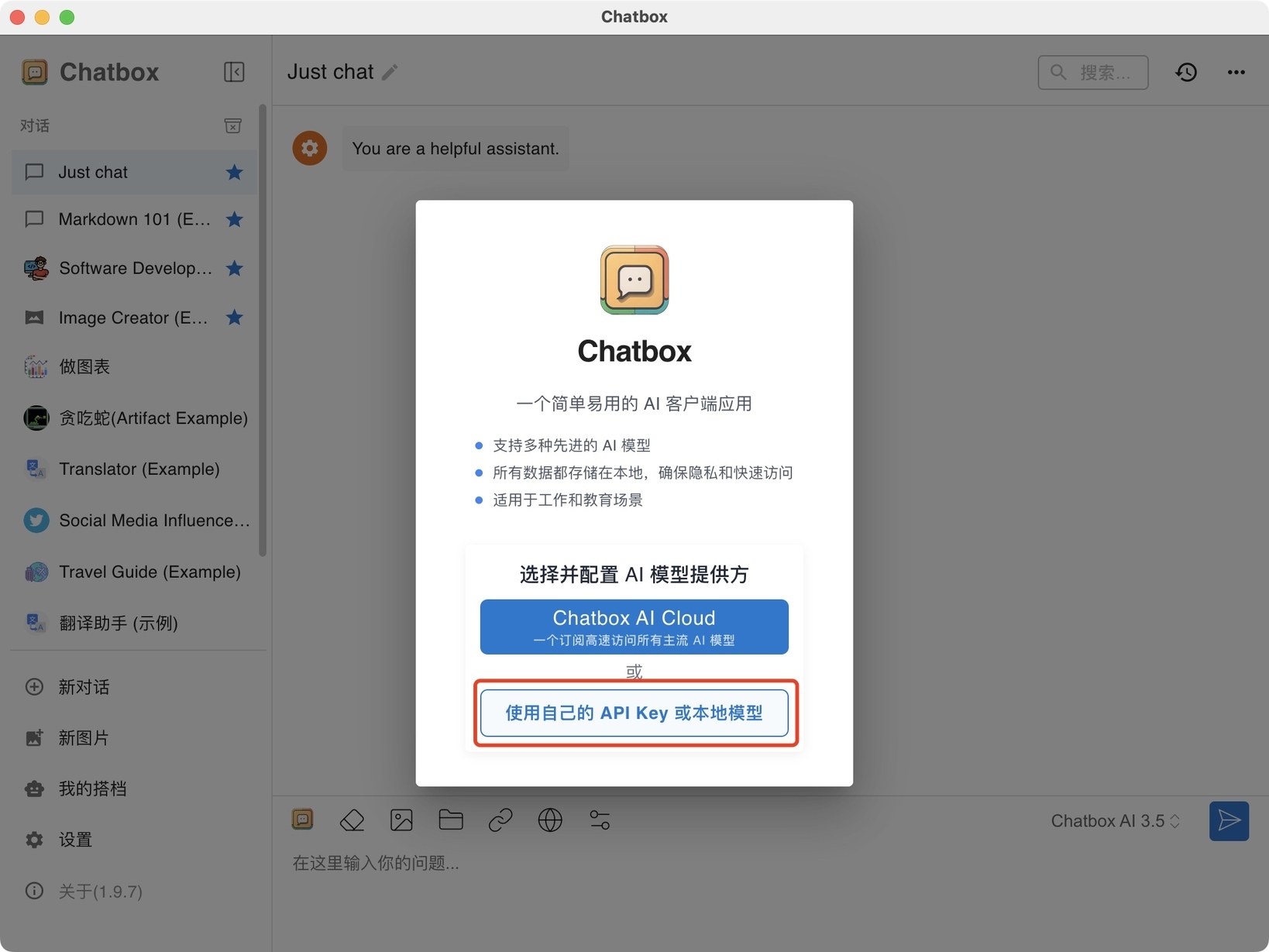

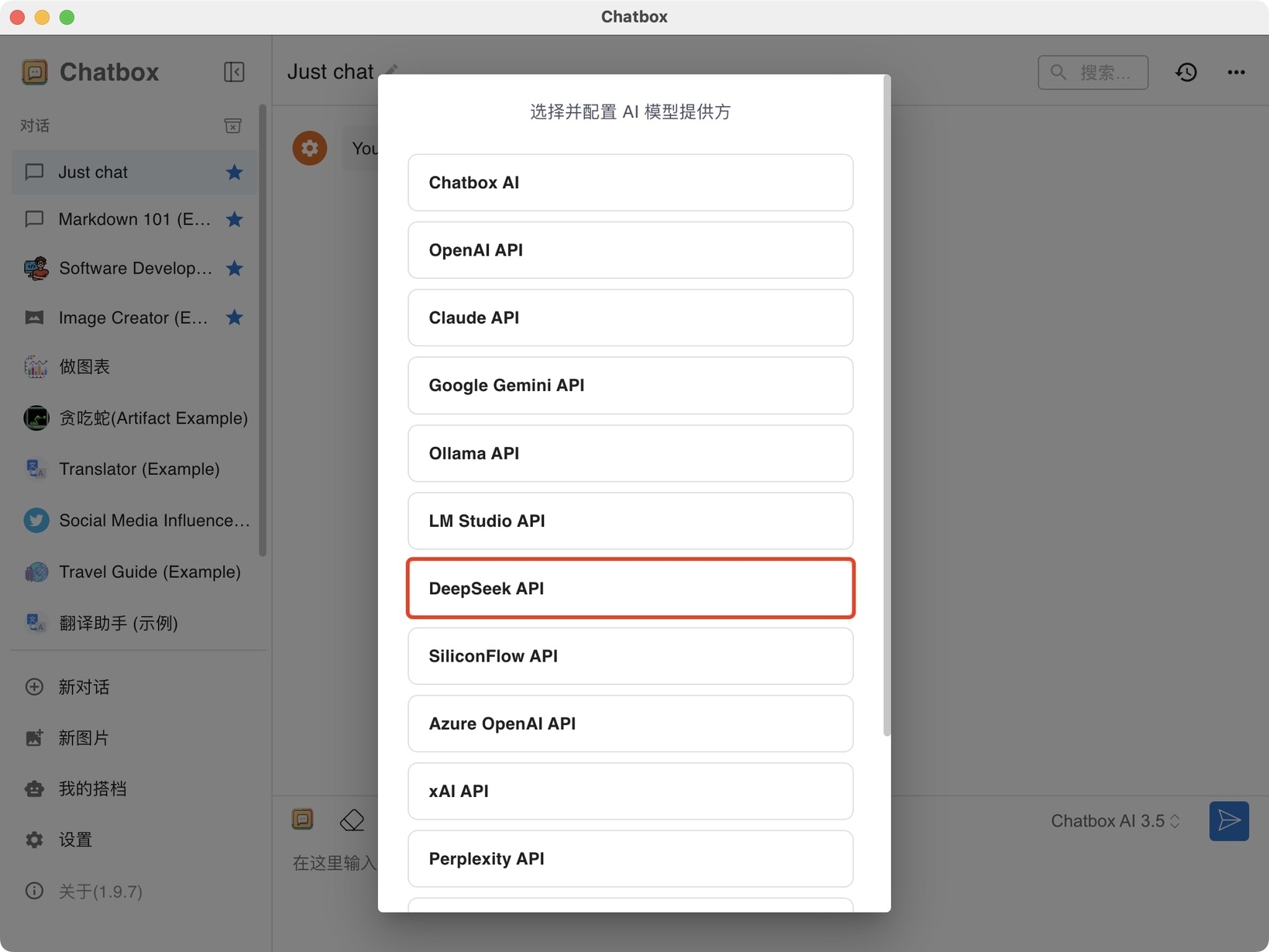

注意,这里我故意选错成 DeepSeek API,这也是初学者经常会选错的,实际上,若选择这个你就找不到你本地的 DeepSeek 模型。

实际正确应该选择 OLLAMA API,然后就可以看到我们上一步安装好的deepseek-r1:1.5b。

3.无需联网也能和 DeepSeek 畅快聊天

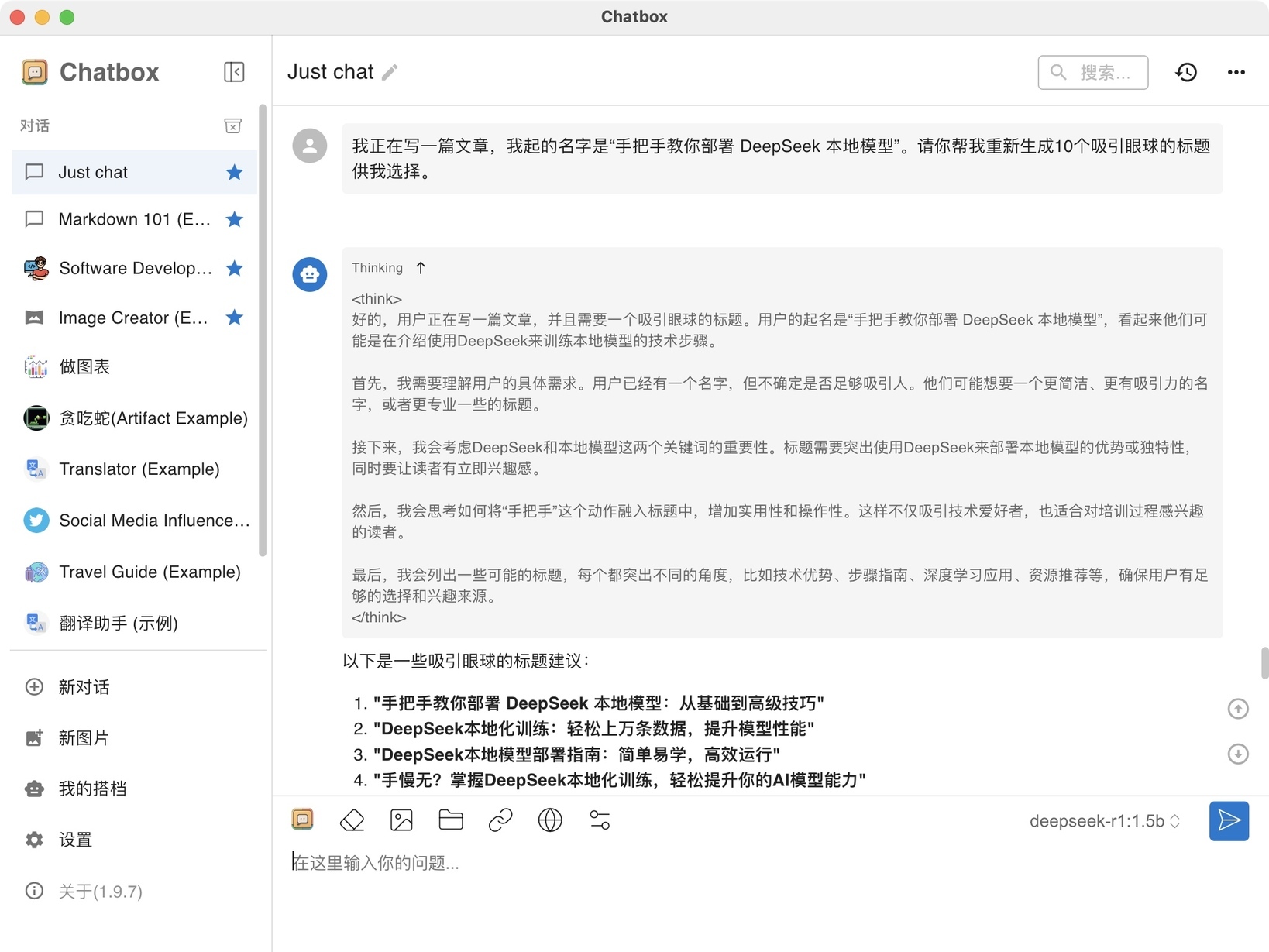

配置好 DeepSeek 本地模型之后,就可以实现在断网情况下自由问答了,比如,此刻我正在写这篇文章,于是就问他帮我想几个备选的标题:

他真的迅速给我起了 10 个吸引眼球的标题,还提供了它思考的过程,而且在我这 4 年前的电脑上跑起来都很迅速。

文章转载自:AlfredZhao

原文链接:https://www.cnblogs.com/jyzhao/p/18700202/shou-ba-shou-jiao-ni-bu-shu-deepseek-ben-de-mo-xin

评论