爬虫部署完成却总掉线?服务器环境、IP 策略、反爬机制全面解析

用户部署海外爬虫时,经常会收到类似反馈:"爬虫搭好了,代码也没报错,可就是跑着跑着突然掉线了,日志里全是 Timeout 和 403,根本跑不完整批数据。" 乍一看像是网络问题,但深入排查后才发现,背后藏着的坑远比想象的多。

从 IP 归属地、DNS 配置、到 TLS 兼容性与反爬策略,服务器环境的每一个细节都可能成为拦路虎。

小壳今天跟你一起系统拆解常见故障场景,提供一套可复制的排查思路!

爬虫部署排查思路指南

▏服务器环境配置与稳定性分析

爬虫部署是长时间运行的任务,对内存、I/O、网络稳定性要求都很高。

但有些人使用到了极低配的海外 VPS,一跑并发就卡住,甚至被系统自动 kill 进程。结果不是“掉线”,而是进程直接没了。

推荐操作:

优先选择与目标网站物理距离接近的服务器节点;

合理配置系统资源,监控内存/CPU/I/O 状态;

配置自动重启机制(supervisor、pm2 等),防止进程崩溃导致长时间掉线。

▏部署后无法连接的常见因素

主流网站对云服务商 IP 段的识别越来越敏感。部署在常见的云服务节点上,IP 根本连不上目标站,返回 403 已是常态。尤其是反爬站点,如社交平台、电商、票务网站等,对非住宅 IP 识别精准又严厉。

◆常见的情况:

1、目标站封锁了服务器 IP 段:很多网站会对云服务提供商的公网 IP 段进行识别并直接屏蔽,尤其是数据请求频繁的场景。应对策略: 使用真实住宅 IP 代理,或尝试通过代理池伪装请求源。

kookeey(https://www.kookeey.com/)提供高质量海外住宅 IP,稳定性和匿名性远高于普通代理。

2、目标站设置地理位置限制:有些站点仅限特定国家/地区访问,服务器所在国家不在白名单中也会导致连接失败。应对策略: 调整代理 IP 地理位置,或选择位于目标站可接受地区的服务器节点。

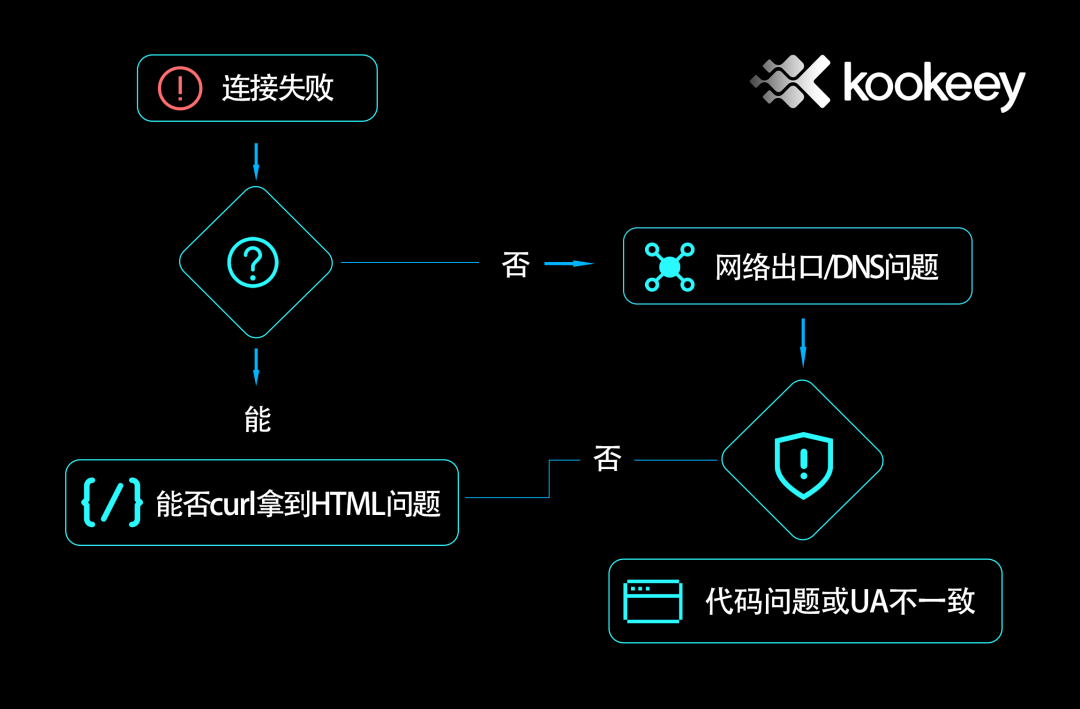

3、服务器未正确配置 DNS 或网络出口:有些服务器默认 DNS 解析异常或网络出口设置问题,会导致域名无法解析或连接不出网。

排查要点:

检查 DNS 配置,推荐使用 8.8.8.8 或 1.1.1.1;

通过 ping、curl 命令测试域名解析与连通性;

查看服务器的防火墙、安全组规则是否放行必要端口;

使用 traceroute 或 mtr 工具确认链路。

4、目标站反爬策略升级:本地调试阶段可能访问频率低、不易触发反爬规则,而部署后长时间运行更易被识别并封锁。应对策略: 加入 Header 伪装、增加随机 UA、控制请求频率、引入验证码识别模块或使用爬虫中间件框架如 Scrapy+rotating proxies。

5、HTTPS 验证或 TLS 版本不兼容:某些站点要求特定 TLS 协议版本或证书验证严格,服务器 Python 或 OpenSSL 版本不支持就可能连接失败。

简单验证方式:

排查方式:

使用 requests 加上 verify=False 测试是否为证书问题;

长期部署应升级 Python 与 OpenSSL 版本,确保支持 TLS1.2 以上。

▏部署优化的实用建议

建议部署前先用 curl 测试目标站是否能正常访问;

使用 httpbin.org 验证请求 Header 和 IP 信息是否伪装成功;

引入代理池并做失败率监控,自动切换代理;

结合 loguru 等日志模块记录每次请求异常及状态码,便于排查。

如果你也卡在部署阶段不知如何排查,欢迎通过 kookeey(https://www.kookeey.com)联系我们,我们不仅提供 IP 资源,也提供部署层面的专业建议和辅助。

以上就是今天的全部内容,各位还遇到什么问题欢迎在评论区留言~

评论