ICCV 2023 | 当尺度感知调制遇上 Transformer,会碰撞出怎样的火花?

作者 | AFzzz

1 文章介绍

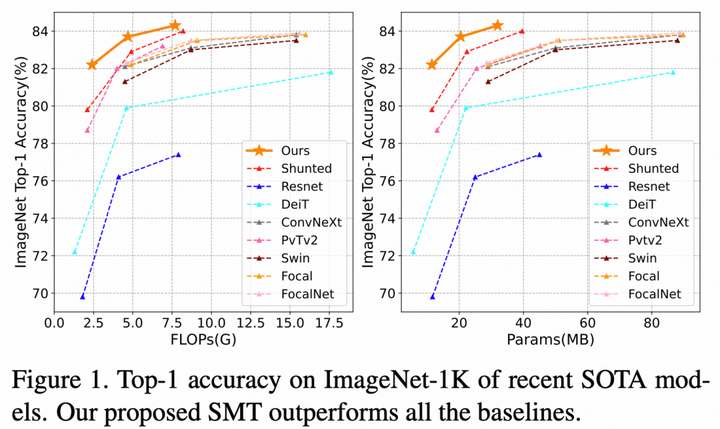

近年来,基于 Transformer 和 CNN 的视觉基础模型取得巨大成功。有许多研究进一步地将 Transformer 结构与 CNN 架构结合,设计出了更为高效的 hybrid CNN-Transformer Network,但它们的精度仍然不尽如意。本文介绍了一种新的基础模型 SMT(Scale-Aware Modulation Transformer),它以更低的参数量(params)和计算量(flops)取得了大幅性能的提升。

不同于其他 CNN-Transformer 结合的方案,SMT 基于卷积计算设计了一个新颖的轻量尺度感知调制单元 Scale-Aware Modulation(SAM) ,它能够捕捉多尺度特征的同时扩展感受野,进一步增强卷积调制能力。此外,SMT 提出了一种进化混合网络 Evolutionary Hybrid Network(EHN) ,它能够有效地模拟网络从浅层变深时捕捉依赖关系从局部到全局的转变,从而实现更优异的性能。在 ImagNet、COCO 以及 ADE20k 等任务上都验证了该模型的有效性。值得一提的是,SMT 在 ImageNet-22k 上预训练后以仅仅 80.5M 的参数量在 ImageNet-1k 上达到了 88.1%的精度。

2 出发点

对于多层级的网络架构来说,由于浅层特征图分辨率大的原因,自注意力的二次复杂性会带来严重的计算负担。因此,如何为浅层 stage 设计高效的 attention 计算机制是十分重要的。

回顾以往的大部分 Hierarchical(Multi-scale)的模型,以 Swin 为代表,以及后续的 CvT,PvT,Shunted Transformer 等等,它们的主要贡献点都是设计出了一种更高效的 attention 计算单元,比如 local attention,lightweight convolution attention 等等。

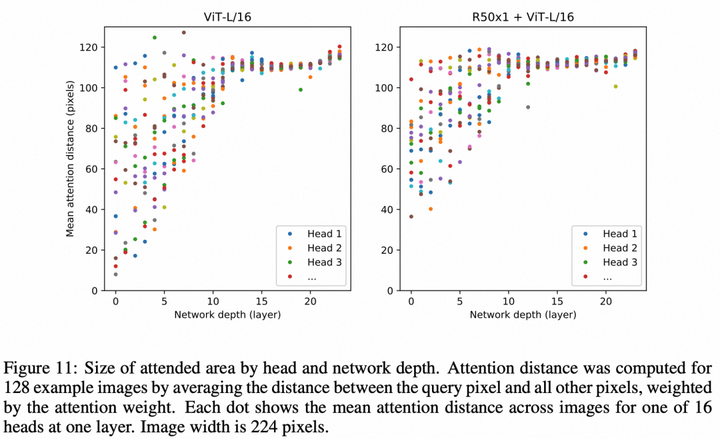

ViT 论文中提出,Transformer 模型的注意力捕捉依赖关系为,浅层捕捉 local 信息,深层捕捉 global 信息,而这种特性在多层级网络架构上也会出现。

作者认为,模拟并建模这种捕捉依赖过渡是重要且有效的。

3 SMT 框架算法

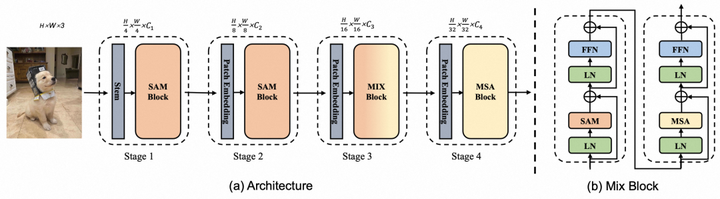

SMT 的总体框架如图 1 所示。整个网络包括四个阶段,每个阶段的下采样率为{4, 8, 16, 32}。我们并非和 FocalNet 一样构建一个无注意力机制的网络,而是首先在前两个阶段采用文章提出的尺度感知调制(SAM),然后在倒数第二个阶段中依次堆叠一个 SAM Block 和一个多头自注意力(MSA) Block,以建模从捕捉局部到全局依赖关系的转变。对于最后一个阶段,我们仅使用 MSA 块来有效地捕捉长距离依赖关系。

3.1 Scale-Aware Modulation 模块

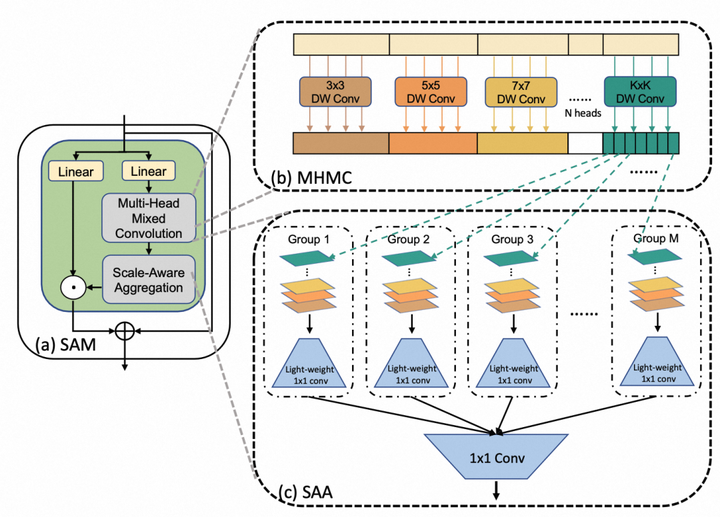

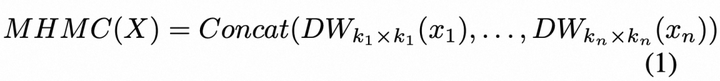

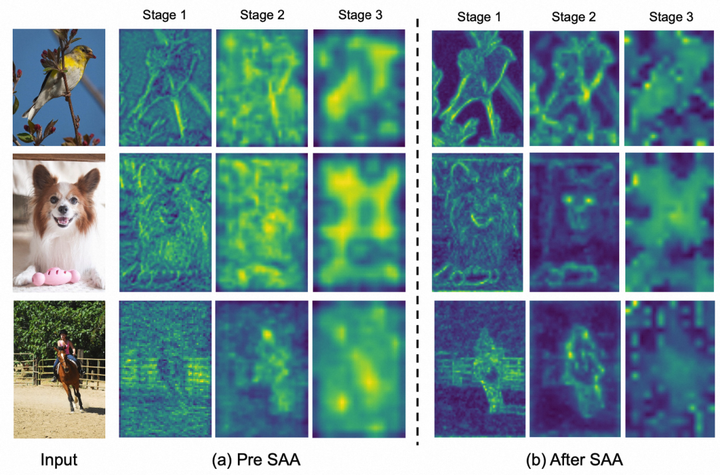

多头混合卷积 MHMC(Multi-Head Mixed Convolution)

在 MHMC 中,我们引入了具有不同卷积核大小的多个卷积层,使其能够捕捉多个尺度上的空间特征。当我们将 N head 设置得较大时,能够引入大卷积核来扩大感受野,增强其建模长距离依赖关系的能力。如图 2(b)所示,MHMC 将输入通道分为 N 个头,对每个头应用独立的深度可分离卷积。我们将卷积核大小初始化为 3x3,并逐头递增。这种方法使得我们能够人为的通过调整头的数量来调节感受野的范围和多粒度信息。

多尺度感知聚合 SAA(Scale-Aware Aggregation)

为了增强 MHMC 中多个头之间的信息交互,我们引入了一种新的轻量化聚合模块,称为多尺度感知聚合(SAA),如图 2(c)所示。SAA 首先对 MHMC 生成的不同粒度的特征进行重组和分组。具体而言,我们从每个头中选择一个通道来构建一个组,然后在每个组内进行 up-down 的特征融合,从而增强多尺度特征的多样性。值得注意的是,Num_group = C / N_head,C 为输入通道数,这意味着组的数量与 MHMC 中头的数量成反比,每个组里只包含 N 个特征通道。随后,我们使用 1x1 卷积进行组内-组间模式的跨组信息融合,从而实现轻量且高效的聚合效果。

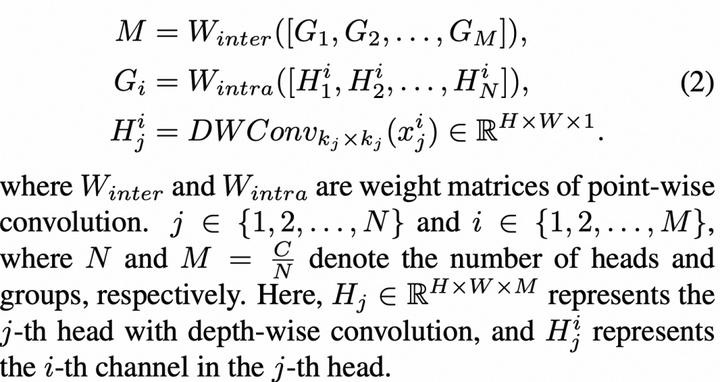

如图 3 所示,我们可视化出 SAA 前和 SAA 后的特征图,可以观察到 SAA 模块加强了语义相关的低频信号,并准确地聚焦于目标物体最重要的部分。与聚合之前的卷积映射相比,SAA 模块展示了更好的能力来捕捉和表示视觉识别任务的关键特征。

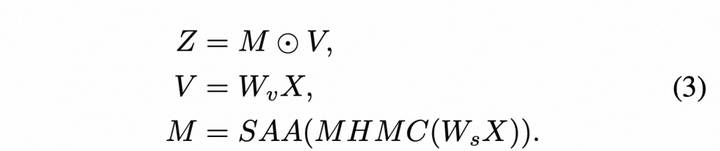

尺度感知调制器 SAM(Scale-Aware Modulation)

如图 2(a)所示,在使用 MHMC 捕捉多尺度空间特征并通过 SAA 进行聚合后,我们获得一个输出特征图,我们称之为调制器 Modulator。然后,我们使用标量乘积采用这个调制器来调制 value V。

3.2 混合进化网络 Evolutionary Hybrid Network

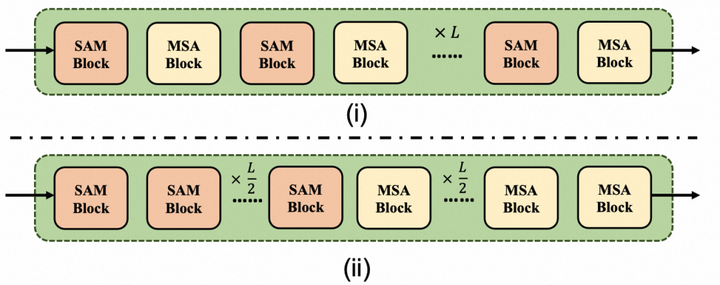

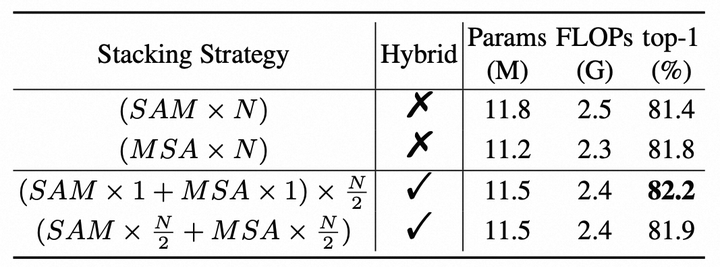

在本节中,我们提出根据网络的捕捉范围依赖关系的变化模式重新分配适当的计算模块,以实现更好的计算性能。我们提出了两种混合堆叠策略用于倒数第二个阶段,(i) 依次堆叠一个 SAM 块和一个 MSA 块。(ii) 在 stage 的前半部分使用 SAM 块,在后半部分使用 MSA 块。为了评估这两种混合堆叠策略的有效性,我们在 ImageNet-1K 上评估了它们的 top-1 准确率。可以看到,(i)混合堆叠策略更加有效。

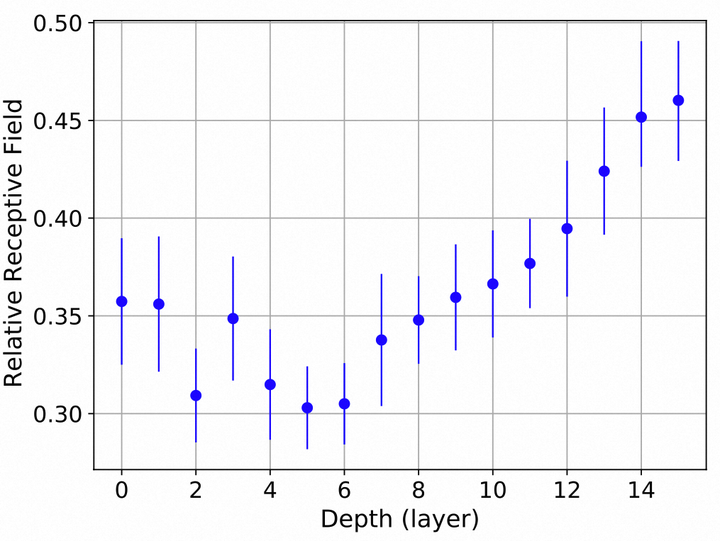

不仅如此,我们还计算了倒数第二个阶段中 MSA 块的相对感受野。值得注意的是,浅层 layer 的相对感受野开始阶段有一个轻微的下降趋势。作者认为这种下降可以归因于 SAM 对早期 MSA Block 的影响,我们将这种现象称为计算单元磨合适应期。而随着网络的加深,我们可以看到感受野呈平稳上升的趋势,这表明我们提出的进化混合网络有效地模拟了从局部到全局依赖捕捉的过渡。

4 实验

4.1 分类实验

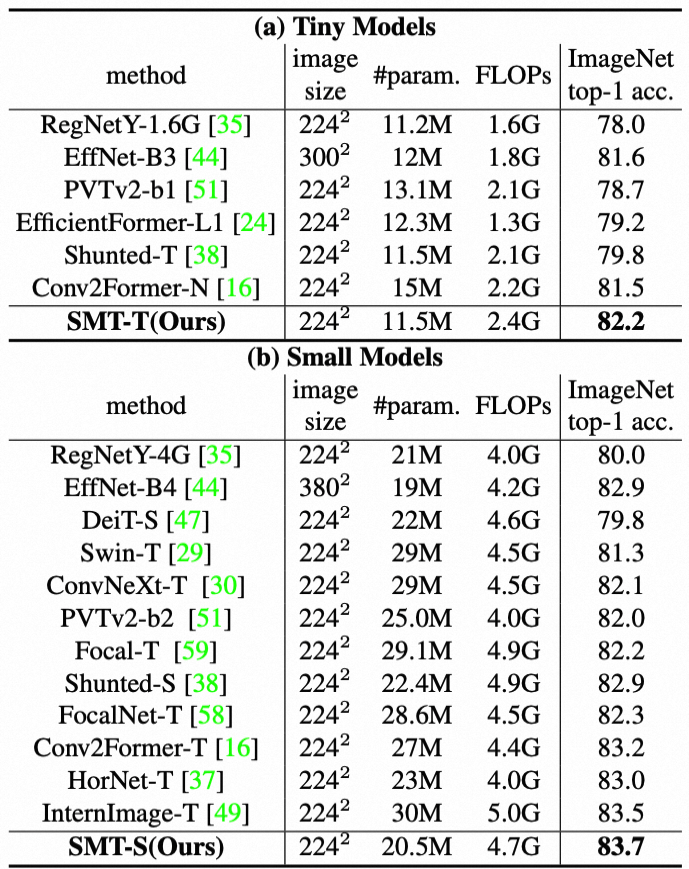

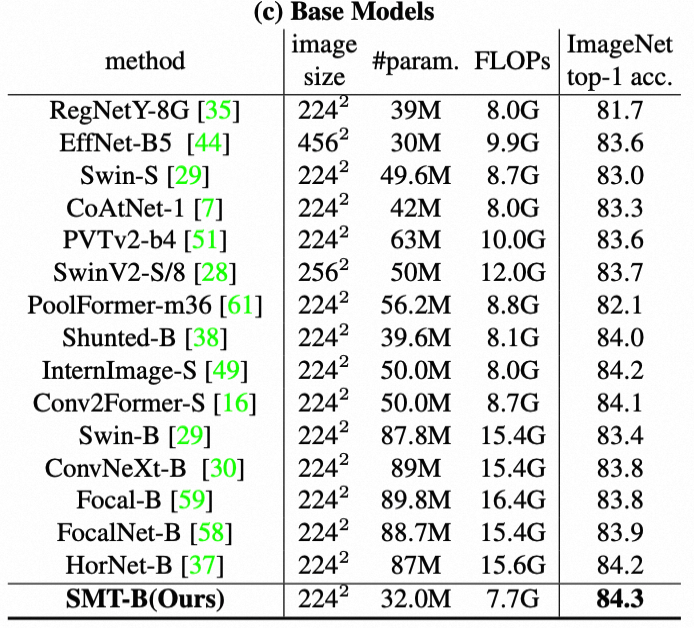

上表给出了不同模型大小在 ImageNet-1k 上的性能对比,从中可以看到:

SMT 在 tiny、small 和 base 规模上都以更低的参数量和计算量达到了更优的性能;

SMT-B 在仅仅 32.0M 和 7.7GFlops 下就取得了 84.3%的精度,甚至比大多数 80M 和 15G 以上的模型更好。

当采用 ImageNet-22k 与大尺度数据预训练之后,SMT-L 精度提升到 87.1%和 88.1%,优于现有的 CNN 和 Transformer 模型。特别地,SMT-L 用 4x 低的参数量和 3x 低的计算量就超过了 InternImage-XL(88.0%)

这些结果表明 SMT 是一个 scalability 能力很强的模型,在各种尺度参数下都具有优异的性能。

4.2 目标检测实验

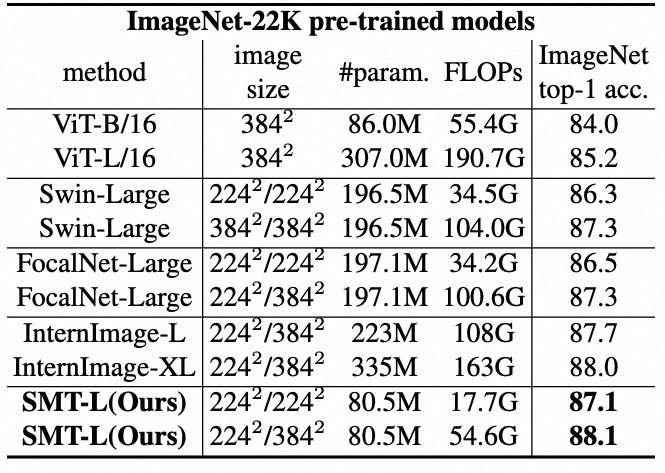

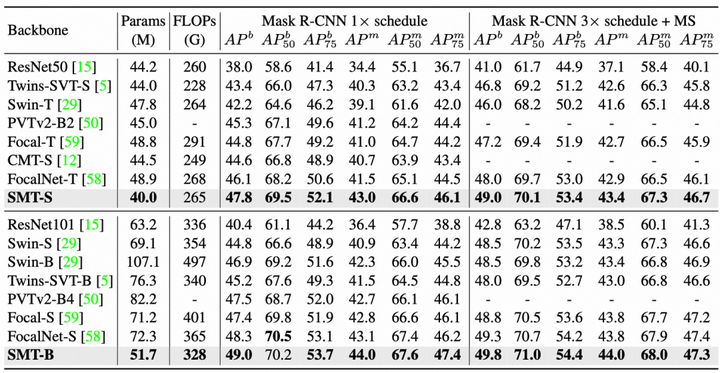

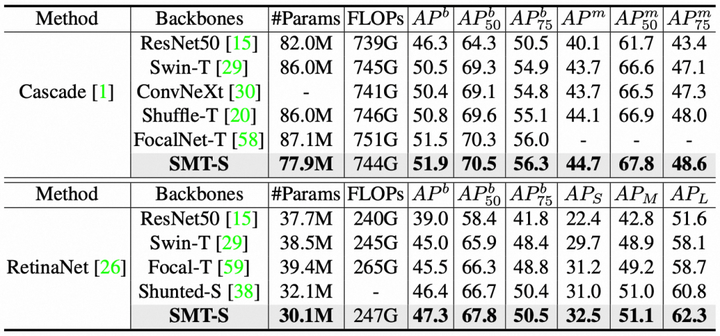

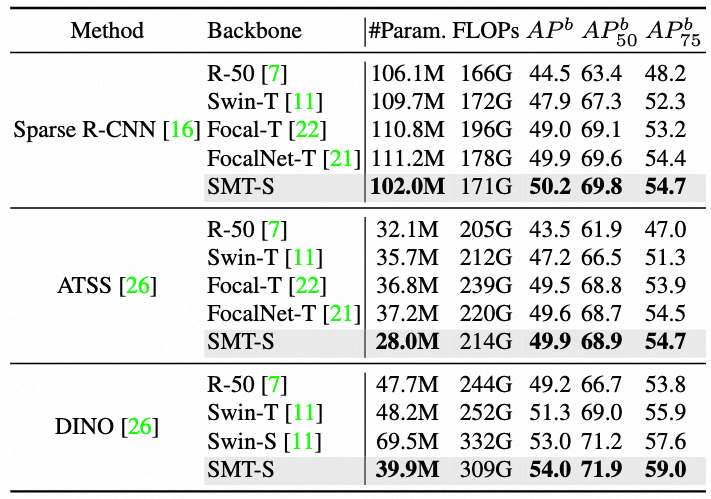

上述三个表格是在多个检测框架上的性能对比实验,可以看到

在多个检测框架上,包括 Mask R-CNN、Cascade R-CNN、RetinaNet、Sparse R-CNN、ATSS 和 DINO 中,SMT 都获得了更优的性能。

对于 Mask R-CNN,在 1x 和 3x 中,SMT-B 分别比 Swin-B 高 2.1mAP 和 1.3mAP,同时参数量只有 Swin-B 的一半。

对于 DINO 检测框架,SMT-S 仅仅用 39.9M 的参数量就达到了 54.0mAP,超越了现有同等规模大小的其他模型。

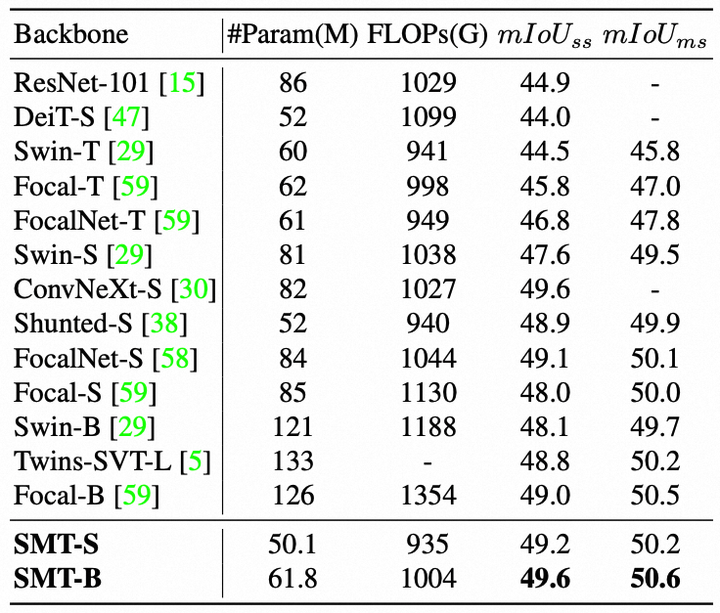

4.3 分割实验

上表给出了 ADE20K 分割任务上的性能对比,从中可以看到当我们使用 uperNet 框架时,SMT 在不同尺度下拥有更低的参数量和计算量,同时精度也优于其他模型。

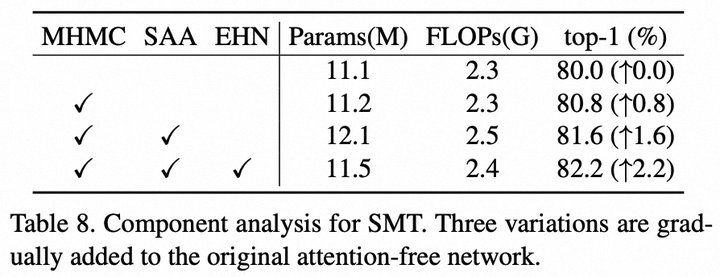

4.4 消融实验

5 总结与展望

总的来说,在视觉基础模型 backbone 的探索路程中,我们有着对未来的展望:

以视觉 Transformer 为例,除了在自监督学习等预训练中依旧用着 ViT 这种 plain Vision Transformer,大部分视觉基础模型都以 Swin 和 PvT 这种 Hierarchical 架构为基础设计范式。而这种范式需要解决的问题就是如何在浅层 stage 中设计更高效的注意力机制计算来解决自注意力的二次复杂性带来的计算负担。是否有更优秀的计算模块能够代替 SAM 或者是 MSA 是我们后续需要继续探索的路。

2023 年,更多的视觉 Transformer 模型和 CNN 基础大模型被提出,它们在各大榜单上你追我赶,可以发现 CV 领域中 CNN 依旧有着一席之地。如果 Transformer 不能够在 CV 领域完全替代 cnn 神经网络,那么将两者的优势结合起来是否是更好的选择?因此,我们希望 SMT 可以作为 Hybrid CNN-Transformer 方向新的 baseline,推动该领域的进步和发展。

● Arxiv 地址:

https://arxiv.org/abs/2307.08579

● Github 地址:

https://github.com/AFeng-x/SMT

● modelscope 地址:

https://modelscope.cn/models/PAI/SMT/summary

● 论文链接:

https://arxiv.org/pdf/2307.08579.pdf

● 代码链接:

https://github.com/AFeng-x/SMT

Reference

[1] Scale-Aware Modulation Meet Transformer[https://arxiv.org/abs/2307.08579]

[2] An image is worth 16x16 words transformers for image recognition at scale [https://arxiv.org/pdf/2010.11929.pdf]

[2] Focal Modulation Network [https://arxiv.org/abs/2203.11926]

[3] MixConv: Mixed Depthwise Convolutional Kernels [https://arxiv.org/abs/1907.09595]

[4] Swin Transformer: Hierarchical Vision Transformer using Shifted Windows [https://arxiv.org/abs/2103.14030]

[5] InternImage: Exploring Large-Scale Vision Foundation Models with Deformable Convolutions [https://arxiv.org/abs/2211.05778]

论文信息

● 论文标题:

Scale-Aware Modulation Meet Transformer

● 论文作者:

林炜丰、吴梓恒、陈佳禹、黄俊、金连文

● 论文 PDF 链接:

版权声明: 本文为 InfoQ 作者【阿里云大数据AI技术】的原创文章。

原文链接:【http://xie.infoq.cn/article/6d7d3a0c39eaff5fa89f9eeeb】。文章转载请联系作者。

评论