用 Arthas 定位 Spring Boot 接口的超时问题,让应用起飞~

背景

公司有个渠道系统,专门对接三方渠道使用,没有什么业务逻辑,主要是转换报文和参数校验之类的工作,起着一个承上启下的作用。

最近在优化接口的响应时间,优化了代码之后,但是时间还是达不到要求;有一个诡异的 100ms 左右的耗时问题,在接口中打印了请求处理时间后,和调用方的响应时间还有差了 100ms 左右。比如程序里记录 150ms,但是调用方等待时间却为 250ms 左右。

下面记录下当时详细的定位 &解决流程(其实解决很简单,关键在于怎么定位并找到解决问题的方法)

定位过程

分析代码

渠道系统是一个常见的 spring-boot web 工程,使用了集成的 tomcat。分析了代码之后,发现并没有特殊的地方,没有特殊的过滤器或者拦截器,所以初步排除是业务代码问题

分析调用流程

出现这个问题之后,首先确认了下接口的调用流程。由于是内部测试,所以调用流程较少。

公司是云服务器,网络走的也是云的内网。由于不明确问题的原因,所以用排除法,首先确认服务器网络是否有问题。

先确认发送端到 Nginx Host 是否有问题:

从 ping 结果上看,发送端到 Nginx 主机的延迟是无问题的,接下来查看 Nginx 到渠道系统的网络。

从 ping 结果上看,Nginx 到渠道系统服务器网络延迟也是没问题的

既然网络看似没问题,那么可以继续排除法,砍掉 Nginx,客户端直接再渠道系统的服务器上,通过回环地址(localhost)直连,避免经过网卡/dns,缩小问题范围看看能否复现(这个应用和地址是我后期模拟的,测试的是一个空接口):

从 curl 日志上看,通过回环地址调用一个空接口耗时也有 73ms。这就奇怪了,跳过了中间所有调用节点(包括过滤器 &拦截器之类),直接请求应用一个空接口,都有 73ms 的耗时,再请求一次看看:

更奇怪的是,第二次请求耗时就正常了,变成了 3ms。经查阅资料,linux curl 是默认开启 http keep-alive 的。就算不开启 keep-alive,每次重新 handshake,也不至于需要 70ms。

经过不断分析测试发现,连续请求的话时间就会很短,每次请求只需要几毫秒,但是如果隔一段时间再请求,就会花费 70ms 以上。

从这个现象猜想,可能是某些缓存机制导致的,连续请求因为有缓存,所以速度快,时间长缓存失效后导致时间长。

那么这个问题点到底在哪一层呢?tomcat 层还是 spring-webmvc 呢?

光猜想定位不了问题,还是得实际测试一下,把渠道系统的代码放到本地 ide 里启动测试能否复现

但是导入本地 Ide 后,在 Ide 中启动后并不能复现问题,并没有 70+ms 的延迟问题。这下头疼了,本地无法复现,不能 Debug,由于问题点不在业务代码,也不能通过加日志的方式来 Debug

这时候可以祭出神器 Arthas 了

Arthas 分析问题

Arthas 是 Alibaba 开源的 Java 诊断工具,深受开发者喜爱。当你遇到以下类似问题而束手无策时,Arthas 可以帮助你解决:

这个类从哪个 jar 包加载的?为什么会报各种类相关的 Exception?

我改的代码为什么没有执行到?难道是我没 commit?分支搞错了?

遇到问题无法在线上 debug,难道只能通过加日志再重新发布吗?

线上遇到某个用户的数据处理有问题,但线上同样无法 debug,线下无法重现!

是否有一个全局视角来查看系统的运行状况?

有什么办法可以监控到 JVM 的实时运行状态?

上面是 Arthas 的官方简介,这次我只需要用他的一个小功能 trace。动态计算方法调用路径和时间,这样我就可以定位时间在哪个地方被消耗了。

trace 方法内部调用路径,并输出方法路径上的每个节点上耗时

trace 命令能主动搜索 class-pattern/method-pattern

对应的方法调用路径,渲染和统计整个调用链路上的所有性能开销和追踪调用链路。

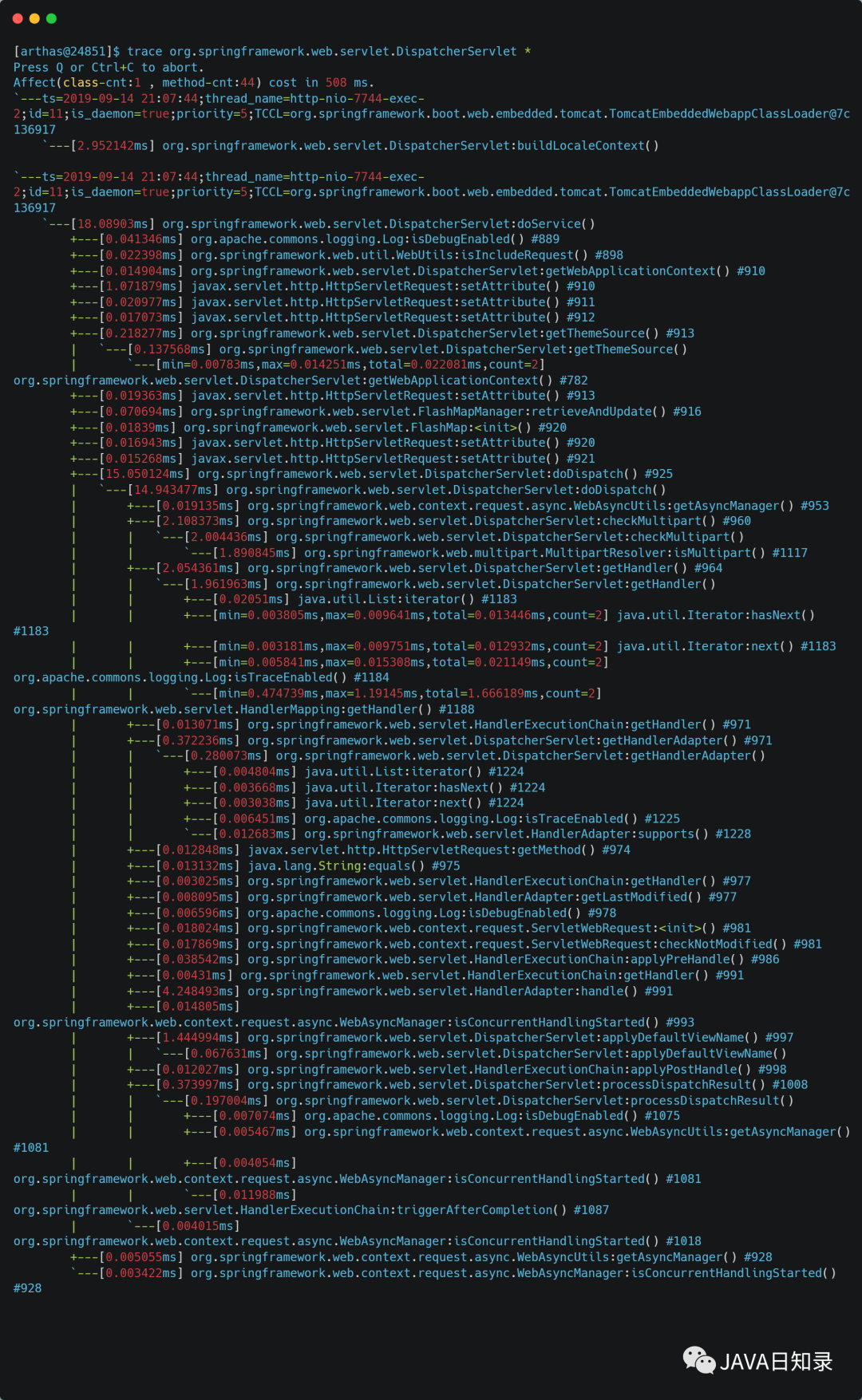

有了神器,那么该追踪什么方法呢?由于我对 Tomcat 源码不是很熟,所以只能从 spring mvc 下手,先来 trace 一下 spring mvc 的入口:

~

本次调用,调用端时间花费 115ms,但是从 arthas trace 上看,spring mvc 只消耗了 18ms,那么剩下的 97ms 去哪了呢?

本地测试后已经可以排除 spring mvc 的问题了,最后也是唯一可能出问题的点就是 tomcat

可是本人并不熟悉 tomcat 中的源码,就连请求入口都不清楚,tomcat 里需要 trace 的类都不好找。。。

不过没关系,有神器 Arthas,可以通过 stack 命令来反向查找调用路径,以org.springframework.web.servlet.DispatcherServlet作为参数:

“

stack 输出当前方法被调用的调用路径

很多时候我们都知道一个方法被执行,但这个方法被执行的路径非常多,或者你根本就不知道这个方法是从那里被执行了,此时你需要的是 stack 命令。

”

从 stack 日志上可以很直观的看出 DispatchServlet 的调用栈,那么这么长的路径,该 trace 哪个类呢(这里跳过 spring mvc 中的过滤器的 trace 过程,实际排查的时候也 trace 了一遍,但这诡异的时间消耗不是由这里过滤器产生的)?

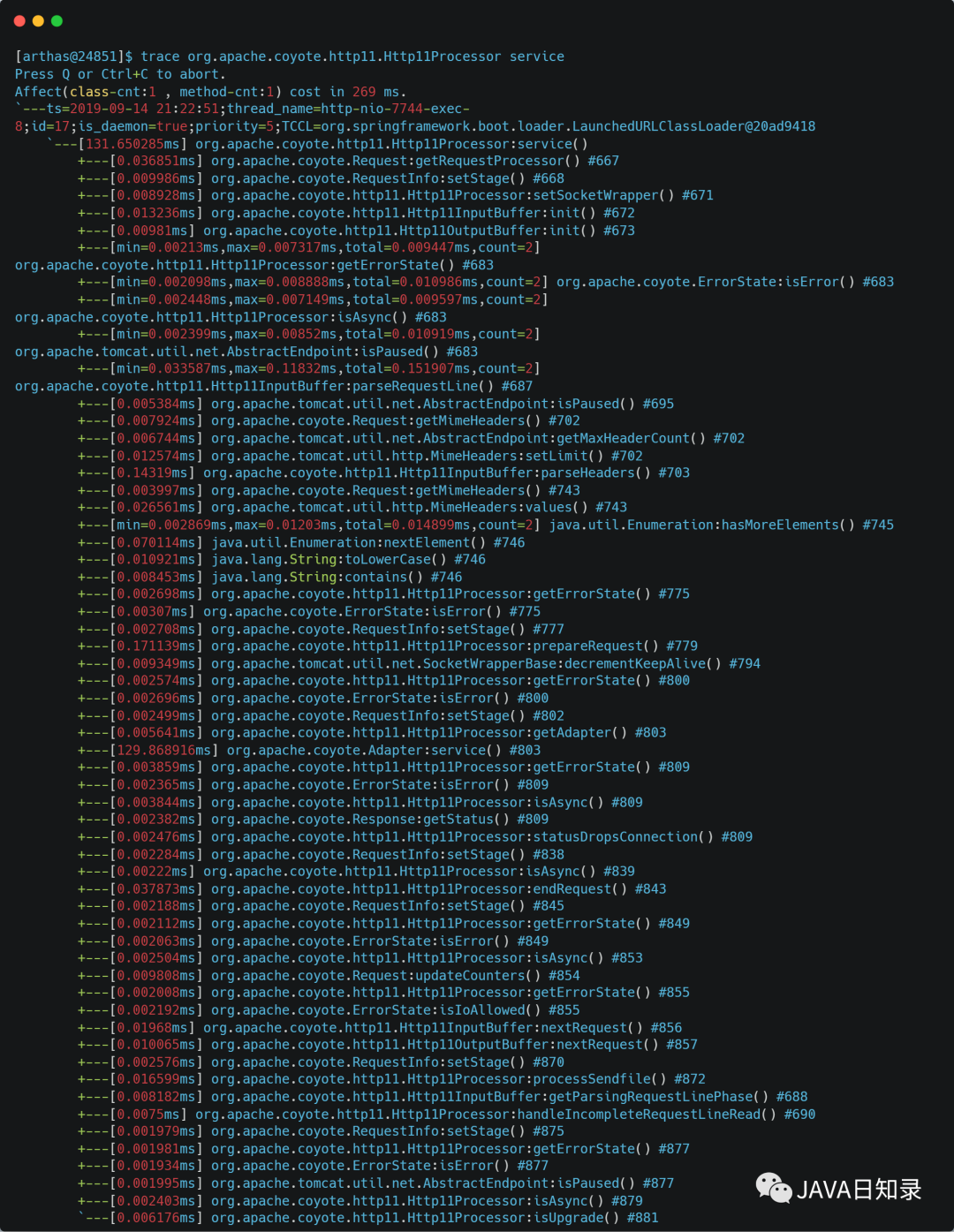

有一定经验的老司机从名字上大概也能猜出来从哪里下手比较好,那就是org.apache.coyote.http11.Http11Processor.service,从名字上看,http1.1 处理器,这可能是一个比较好的切入点。下面来 trace 一下:

日志里有一个 129ms 的耗时点(时间比没开 arthas 的时候更长是因为 arthas 本身带来的性能消耗,所以生产环境小心使用),这个就是要找的问题点。

打问题点找到了,那怎么定位是什么导致的问题呢,又如何解决呢?

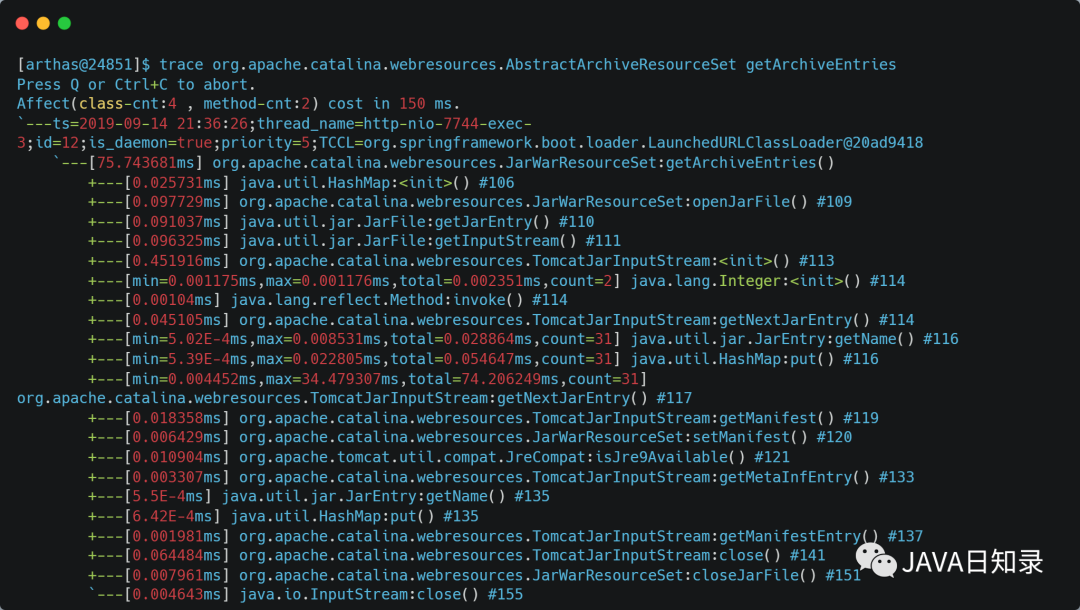

继续 trace 吧,细化到具体的代码块或者内容。trace 由于性能考虑,不会展示所有的调用路径,如果调用路径过深,只有手动深入 trace,原则就是 trace 耗时长的那个方法:

一段无聊的手动深入 trace 之后………………

发现了一个值得暂停思考的点:

这行代码加载了 31 次,一共耗时 74ms;从名字上看,应该是 tomcat 加载 jar 包时的耗时,那么是加载了 31 个 jar 包的耗时,还是加载了 jar 包内的某些资源 31 次耗时呢?

TomcatJarInputStream 这个类源码的注释写到:

大概意思也就是,获取 jar 包内 META-INF/,META-INF/MANIFEST 的资源,这是一个子类,更多的功能在父类 JarInputStream 里。

其实看到这里大概也能猜到问题了,tomcat 加载 jar 包内 META-INF/,META-INF/MANIFEST 的资源导致的耗时,至于为什么连续请求不会耗时,应该是 tomcat 的缓存机制(下面介绍源码分析)

不着急定位问题,试着通过 Arthas 最终定位问题细节,继续手动深入 trace

从方法名上看,还是加载资源之类的意思。都已经到 jdk 源码了,这时候来看一下TomcatJarInputStream这个类的源码:

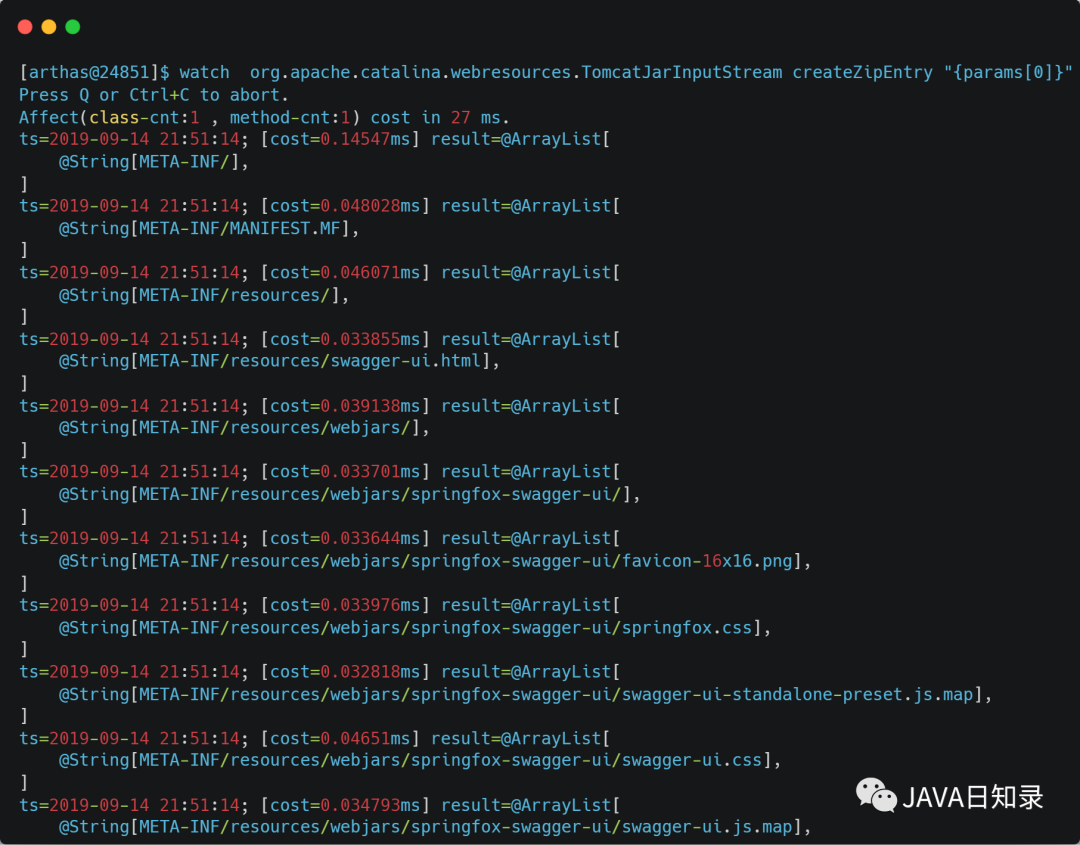

这个createZipEntry有个 name 参数,从注释上看,是 jar/zip 文件名,如果能得到文件名这种关键信息,就可以直接定位问题了;还是通过 Arthas,使用 watch 命令,动态监测方法调用数据

watch 方法执行数据观测

“

让你能方便的观察到指定方法的调用情况。能观察到的范围为:返回值、抛出异常、入参,通过编写 OGNL 表达式进行对应变量的查看。

”

watch 该方法的入参

这下直接看到了具体加载的资源名,这么熟悉的名字:swagger-ui,一个国外的 rest 接口文档工具,又有国内开发者基于 swagger-ui 做了一套 spring mvc 的集成工具,通过注解就可以自动生成 swagger-ui 需要的接口定义 json 文件,用起来还比较方便,就是侵入性较强。

删除 swagger 的 jar 包后问题,诡异的 70+ms 就消失了

那么为什么 swagger 会导致请求耗时呢,为什么每次请求偶读会加载 swagger 内部的静态资源呢?

其实这是 tomcat-embed 的一个 bug 吧,下面详细介绍一下该 Bug

Tomcat embed Bug 分析 &解决

源码分析过程实在太漫长,而且也不是本文的重点,所以就不介绍了, 下面直接介绍下分析结果

顺便贴一张 tomcat 处理请求的核心类图

为什么每次请求会加载 Jar 包内的静态资源

关键在于org.apache.catalina.mapper.Mapper#internalMapWrapper这个方法,该版本下处理请求的方式有问题,导致每次都校验静态资源。

为什么连续请求不会出现问题

因为 Tomcat 对于这种静态资源的解析是有缓存的,优先从缓存查找,缓存过期后再重新解析。具体参考org.apache.catalina.webresources.Cache,默认过期时间 ttl 是 5000ms。

为什么本地不会复现

其实确切的说,是通过 spring-boot 打包插件后不能复现。由于启动方式的不同,tomcat 使用了不同的类去处理静态资源,所以没问题

如何解决

升级 tomcat-embed 版本即可

当前出现 Bug 的版本为:

spring-boot:2.0.2.RELEASE,内置的 tomcat embed 版本为 8.5.31

升级 tomcat embed 版本至 8.5.40+即可解决此问题,新版本已经修复了

通过替换 springboot pom properties 方式

如果项目是 maven 是继承的 springboot,即 parent 配置为 springboot 的,或者 dependencyManagement 中 import spring boot 包的

pom 中直接覆盖 properties 即可:

升级 spring boot 版本

springboot 2.1.0.RELEASE 中的 tomcat embed 版本已经大于 8.5.31 了,所以直接将 springboot 升级至该版本及以上版本就可以解决此问题!

评论