微软提出 TinyMIM,首次用掩码预训练改进小型 ViT

出品人:Towhee 技术团队 顾梦佳

掩码图像建模(MIM)在预训练的大型视觉 Transformer(ViTs)中表现强劲,然而实际生产中更实用的小模型却依然受益不显。为此,微软提出 TinyMIM 探索蒸馏技术,期望将 MIM 在大型预训练模型上的成功迁移到较小的模型。该方法系统地研究了蒸馏框架中的不同选项,包括蒸馏目标、损失、输入、网络正则化、顺序蒸馏等。TinyMIM 显著地改进了模型微调精度,首次成功地为较小的 ViT 模型执行 MIM 预训练方法。

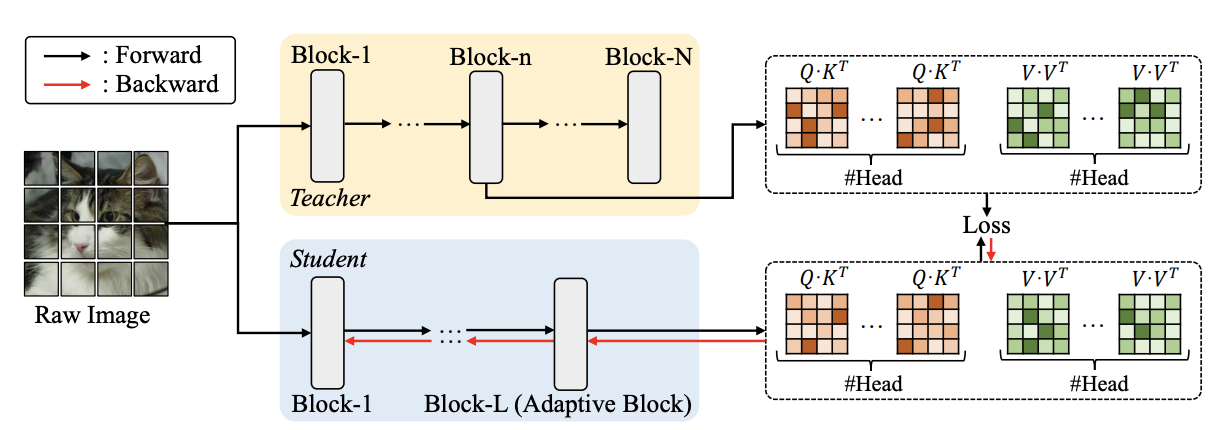

The default knowledge distillation strategy of TinyMIM

TinyMIM 采用较大的 MIM 预训练模型作为教师模型、较小的 ViT 作为学生模型。该策略的目标是通过模仿教师网络在知识蒸馏中产生的目标,训练随机初始化的学生模型。经过 TinyMIM 预训练的模型可以转移到各种下游任务。根据热度和难度,TinyMIM 在实验中选择了 MAE 进行掩码图像建模。经过优化的学生网络(例如 ViT-B)通过以原始图像作为输入的教师模型(例如 ViT-L)的中间块,模仿模块之间的关系。将学生模型中最后一个模块替换成一个自适应模块,无需额外计算成本就可以匹配教师网络的连接头个数。预训练(知识蒸馏)后,学生模型能够被转移到各种下游任务。

相关资料:

代码地址:https://github.com/OliverRensu/TinyMIM

论文链接:TinyMIM: An Empirical Study of Distilling MIM Pre-trained Models

评论