week_012 总结

1.没有数据的存储就没有一切,没有计算,没有存储没有分析。

2.HDFS->{name_node,data_node}

3.map_reduce是一切的基石,得搞清楚。技术要点和解决方案。

4.学别人的技术就都不是顶尖的技术了,不是顶尖的,就规规矩矩得在路上走。

5.所有的map_reduce的输出必然是一个key-value结构。

6.map_reduce的排序不是为了执行某种逻辑,而是如果相同的key需要有顺序要求。网络copy会把相同的key拷贝在一起。

7.broker是HFDFS的概念,split是map_reduce的概念;这两个可以统一可以不统一,统一的话效率更高一点。

8.map函数写满一个buffer就把排序号的数据spill到硬盘中去。

9.相同key的放在一个reduce中去,可以有多个不同的reduce进程。

10.大数据领域最重要的一个单词:values exchanged by shuffle process。(不同的Key分发到不同的reduce进程中去)

11.组成有向无环图

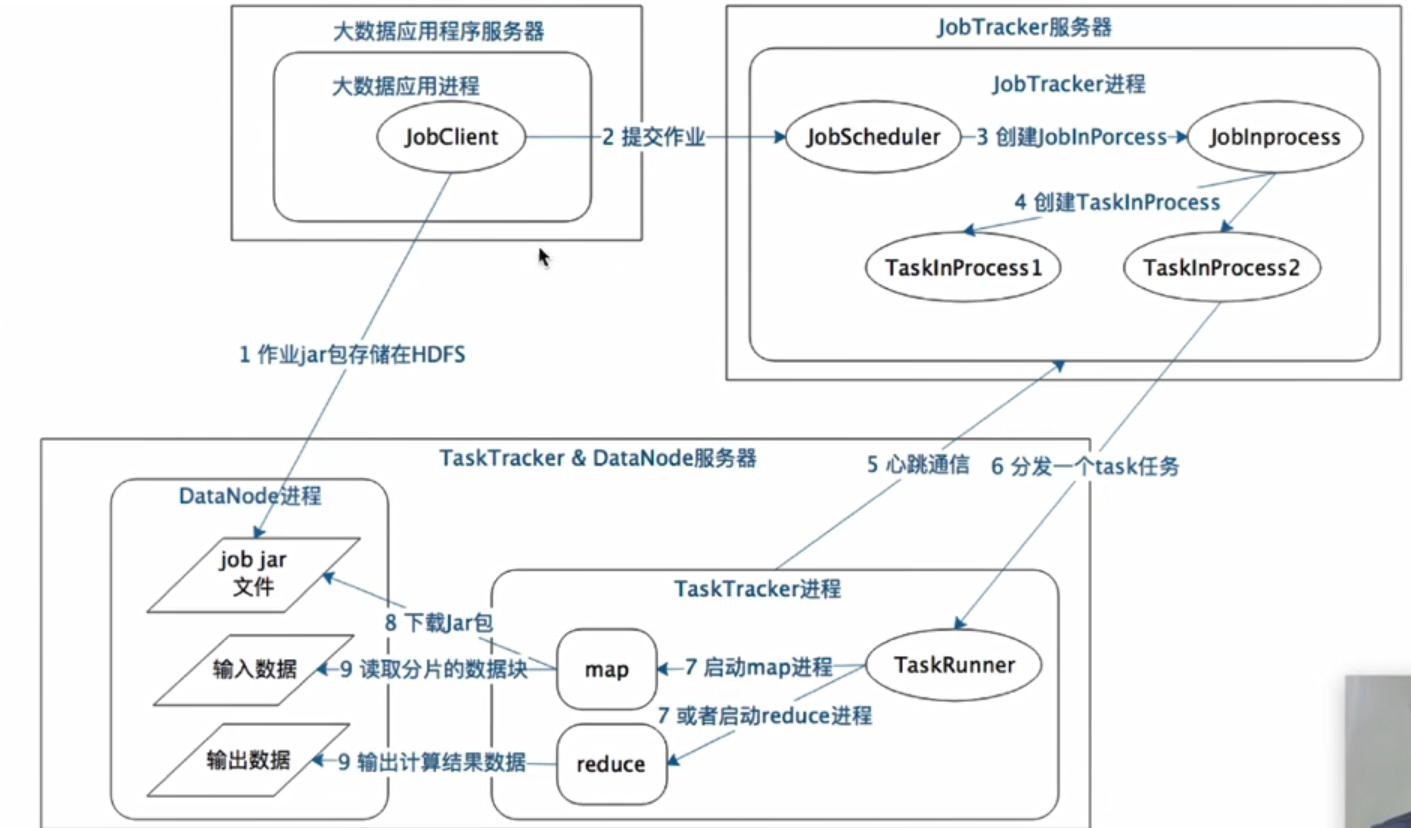

12.JobTracker作业管理

13.TaskTracker最佳实践总是DataNode放在一起。

14.

15.目标是能报所有一切自己实现出来(简版.....

16.只是没时间去做这么个东西,但这些东西需要的知识储备是足够的。

17.公司不同团队对公司的价值是不一样的,优先服务为公司创造利益的团队,调度算法很重要,要协调好相关关系人。

18.这个技术要解决的问题是什么?问题比技术重要。

20.Yarn->{resource_manager,node_manager}

21.Map Join,大小表之间的关联,可以将小表先加载到所有map机器的内存中,直接在map阶段进行reduce,这样可以减少网络传输。

22.hive没有insert操作,可以写到一个文本文档里,再用load将文档和表关联起来。

评论