Rust Tokio 框架源码解析:基于异步运行时的高并发编程实践

目录

前言:Tokio 框架的定位与价值

异步编程基础:理解 Tokio 的技术基石

2.1 Rust 异步编程的核心要素

2.2 Tokio 与 Rust 标准库的关系

Tokio 异步运行时核心架构源码剖析

3.1 运行时初始化:Runtime::new()的底层逻辑

3.2 任务调度核心:工作窃取算法的实现

Tokio 关键组件深度解读(结合源码)

4.1 IO 驱动:基于 mio 的封装与扩展

4.2 定时器:高精度任务调度的实现

4.3 任务包装:JoinHandle与任务生命周期管理

基于 Tokio 的高并发编程实践案例

5.1 :高并发 TCP 回声服务器

5.2 :分布式任务调度系统

5.3 :实时日志收集与分析平台

5.4 :生产级 Web 服务(基于 Axum 框架)

Tokio 框架的性能优化与进阶技巧

6.1 任务调度优化:合理设置工作线程数

6.2 IO 性能优化:使用Bytes与BufReader/BufWriter

6.3 任务取消与资源清理:CancellationToken的使用

思考 Tokio 框架的核心优势与潜在挑战

7.1 核心优势

7.2 潜在挑战

总结:Tokio 在 Rust 异步生态中的地位与未来

一、前言:Tokio 框架的定位与价值

在 Rust 异步编程生态中,Tokio 并非简单的“异步库集合”,而是作为工业级异步运行时,为高并发场景提供从底层调度到上层工具的完整解决方案。无论是高性能网络服务、分布式任务调度,还是实时数据处理系统,Tokio 都凭借“零成本抽象”“低延迟”“高吞吐量”的特性,成为 Rust 开发者构建异步应用的首选框架。Tokio 不仅自身提供 TCP/UDP 网络、定时器、信号处理等核心能力,更支撑了 Actix-web、Axum 等主流 Web 框架的运行,是 Rust 异步生态的“基础设施”。我将从源码层面拆解 Tokio 的核心设计,揭示其通过异步运行时实现高效并发的原理,同时结合实践案例,帮助开发者掌握从“理解原理”到“落地应用”的完整路径。

二、异步编程基础:理解 Tokio 的技术基石

2.1 Rust 异步编程的核心要素

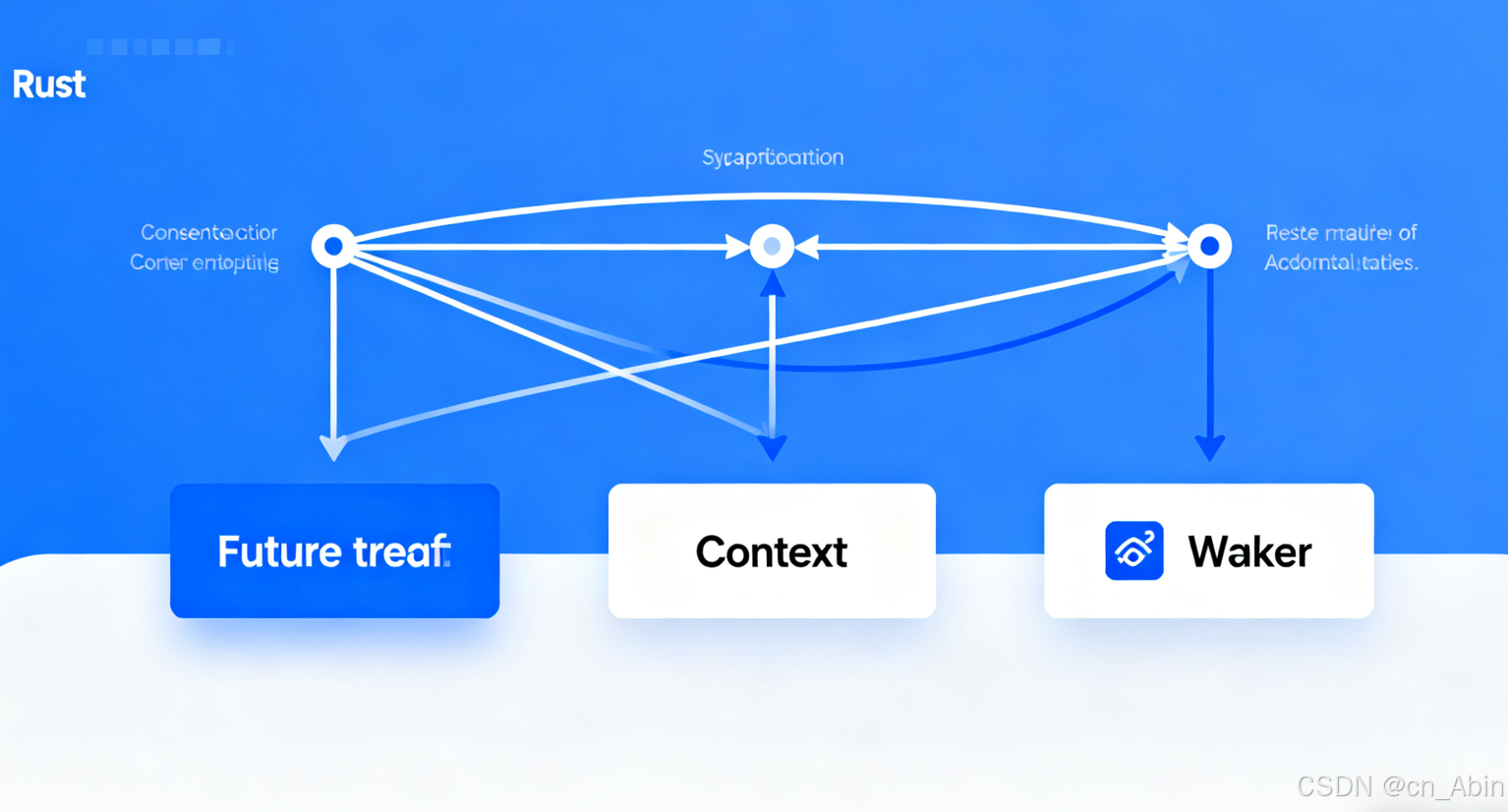

Future trait:异步任务的抽象表示,定义poll(&mut self, cx: &mut Context<'_>) -> Poll<T>方法,用于判断任务是否完成(Poll::Ready(T))或需要等待(Poll::Pending)。Tokio 的所有异步任务最终都以Future形式存在,是运行时调度的基础。

Context 与 Waker:Context包含任务唤醒所需的Waker,当异步任务等待的事件(如 IO 就绪、定时器到期)发生时,Waker会唤醒任务,使其重新进入调度队列。这一机制避免传统轮询的资源浪费,是 Tokio 高效调度的关键。

2.2 Tokio 与 Rust 标准库的关系

Rust 标准库虽提供Future等基础异步 trait,但未实现运行时——即缺乏任务调度、IO 驱动、线程管理等核心能力。而 Tokio 的核心价值,正是填补这一空白:通过实现完整的异步运行时,将标准库的“异步抽象”转化为可落地的“高并发能力”。

三、Tokio 异步运行时核心架构源码剖析

3.1 运行时初始化:Runtime::new()的底层逻辑

Tokio 运行时的初始化入口在tokio::runtime::Runtime结构体,其new()方法本质是构建“调度器 + IO 驱动 + 计时器”的组合体,简化后源码逻辑如下:

pub fn new() -> Result<Self, Error> { // 1. 构建IO驱动(基于mio库封装,负责IO事件监听与通知) let io_driver = IoDriver::new()?; // 2. 构建计时器(基于HRTimer或系统定时器,处理定时任务) let timer = Timer::new(io_driver.handle()); // 3. 构建多线程工作窃取调度器(负责异步任务分配与执行) let scheduler = ThreadPoolScheduler::new(Default::default()); // 4. 组装运行时组件,对外提供统一接口 Ok(Self { io_driver, timer, scheduler, // ...其他辅助组件(如任务统计、资源管理) })}

复制代码

3.2 任务调度核心:工作窃取算法的实现

Tokio 的多线程调度器基于“工作窃取”(Work-Stealing)算法,核心逻辑在tokio::runtime::scheduler::thread_pool模块中,核心机制拆解如下:

调度器结构:每个工作线程(Worker)维护一个本地任务队列(LocalQueue),存储待执行的Future任务;同时存在一个全局任务队列(GlobalQueue),用于任务的跨线程分发。

任务分配逻辑:

本地线程优先执行本地队列中的任务,执行完后通过“窃取”其他线程的本地队列尾部任务(减少竞争)补充任务;

当全局队列有任务时,工作线程会定期从全局队列获取任务,避免局部任务不均衡。

源码关键片段:

// 工作线程的任务执行循环(简化版)fn run(&mut self) { loop { // 1. 先尝试从本地队列获取任务 if let Some(task) = self.local_queue.pop() { self.execute_task(task); } // 2. 本地队列空时,尝试窃取其他线程的任务 else if let Some(task) = self.steal_tasks() { self.execute_task(task); } // 3. 无任务时进入休眠,等待唤醒 else { self.park(); } }}

复制代码

四、Tokio 关键组件深度解读

4.1 IO 驱动:基于 mio 的封装与扩展

Tokio 的 IO 驱动基于mio(Rust 的跨平台 IO 多路复用库)实现,核心模块为tokio::io::driver,主要扩展能力如下:

// IO事件注册(简化版)pub fn register( &self, io: &impl AsRawFd, interest: Interest,) -> Result<Registration> { let token = self.alloc_token(); // 分配唯一标识token // 向mio注册IO事件 self.mio_registry.register(io, token, interest.into_mio())?; Ok(Registration::new(self, token)) // 返回注册器,用于后续事件监听}

复制代码

4.2 定时器:高精度任务调度的实现

Tokio 定时器模块为tokio::time,基于“最小堆”数据结构管理定时任务,核心特性如下:

// 定时任务插入(简化版)pub fn insert(&mut self, delay: Duration, task: Task) { let deadline = self.now() + delay; // 将任务按到期时间插入最小堆 self.heap.push(HeapEntry { deadline, task }); // 若插入的是最早到期任务,更新系统定时器 if self.heap.peek().unwrap().deadline == deadline { self.update_system_timer(deadline); }}

复制代码

4.3 任务包装:JoinHandle与任务生命周期管理

Tokio 通过JoinHandle封装异步任务的执行结果,核心作用如下:

结果获取:通过await获取任务执行结果(Result<T, JoinError>),支持任务取消(abort()方法);

生命周期绑定:JoinHandle持有任务的所有权,当JoinHandle被 drop 且任务未执行时,任务会被取消,避免资源泄漏;

源码关键逻辑:

// JoinHandle的await实现(简化版)impl<T> Future for JoinHandle<T> { type Output = Result<T, JoinError>; fn poll(self: Pin<&mut Self>, cx: &mut Context<'_>) -> Poll<Self::Output> { let task = self.task.as_mut().unwrap(); // 检查任务是否完成 match task.poll(cx) { Poll::Ready(res) => Poll::Ready(Ok(res)), Poll::Pending => { // 注册Waker,任务完成时唤醒当前上下文 task.set_waker(cx.waker().clone()); Poll::Pending } } }}

复制代码

五、基于 Tokio 的高并发编程实践案例

5.1 案例一:高并发 TCP 回声服务器

场景:需要支持上万客户端同时连接的实时通信场景(如物联网设备数据回传)。

核心需求:低延迟数据转发、连接数动态扩展、在线状态监控。

实现步骤

初始化运行时与监听:

#[tokio::main(flavor = "multi_thread", worker_threads = 8)]async fn main() -> Result<(), Box<dyn Error>> { let listener = TcpListener::bind("0.0.0.0:8080").await?; let (tx, rx) = tokio::sync::mpsc::channel(100); // 用于连接状态通知 // 启动连接监控任务 tokio::spawn(monitor_connections(rx)); // 循环接收连接 loop { let (stream, addr) = listener.accept().await?; let tx = tx.clone(); tokio::spawn(async move { // 通知监控任务:新连接 let _ = tx.send((addr, true)).await; // 处理连接 if let Err(e) = handle_connection(stream).await { eprintln!("连接处理错误: {}", e); } // 通知监控任务:连接断开 let _ = tx.send((addr, false)).await; }); }}

复制代码

连接处理与双向转发:

async fn handle_connection(mut stream: TcpStream) -> Result<(), io::Error> { let (mut read_half, mut write_half) = stream.split(); // 双向数据转发(零拷贝优化) tokio::io::copy_bidirectional(&mut read_half, &mut write_half).await?; Ok(())}

// 连接监控任务async fn monitor_connections(mut rx: tokio::sync::mpsc::Receiver<(SocketAddr, bool)>) { let mut count = 0; while let Some((addr, is_connect)) = rx.recv().await { if is_connect { count += 1; println!("客户端 {} 连接,当前在线: {}", addr, count); } else { count -= 1; println!("客户端 {} 断开,当前在线: {}", addr, count); } }}

复制代码

技术亮点:

通过worker_threads = 8配置适配 8 核 CPU 的调度线程,避免线程切换开销;

使用mpsc通道实现连接状态异步通知,无锁设计提升并发效率;

copy_bidirectional基于 Tokio 异步 IO 驱动,单线程可支撑数万连接。

5.2 案例二:分布式任务调度系统

场景:电商平台秒杀活动中的订单处理(峰值每秒数万任务)。

核心需求:任务优先级调度、失败重试、超时控制、集群负载均衡。

核心实现

任务定义与优先级队列:

// 任务结构体(实现Future)struct Task { id: String, priority: u8, // 1-5级,5为最高 action: Box<dyn FnOnce() -> Result<(), TaskError> + Send + 'static>, deadline: Instant, // 超时时间}

// 优先级队列(基于Tokio的mpsc+优先堆)struct PriorityTaskQueue { inner: tokio::sync::mpsc::Receiver<Task>,}

impl PriorityTaskQueue { async fn next_task(&mut self) -> Option<Task> { // 按优先级和超时时间排序取任务 self.inner.recv().await }}

复制代码

分布式调度核心:

#[tokio::main]async fn main() { // 从Redis获取待处理任务(集群模式) let redis_client = redis::Client::open("redis://127.0.0.1:6379").unwrap(); let mut conn = redis_client.get_async_connection().await.unwrap(); // 启动10个工作线程处理任务 for i in 0..10 { let mut conn = redis_client.get_async_connection().await.unwrap(); tokio::spawn(async move { loop { // 阻塞获取高优先级任务(带超时) let task: Option<Task> = redis::cmd("BLPOP") .arg("high_priority_tasks") .arg(5) // 5秒超时 .query_async(&mut conn) .await.unwrap(); if let Some(mut task) = task { // 超时控制 let result = tokio::time::timeout( task.deadline.duration_since(Instant::now()), async move { (task.action)() } ).await; match result { Ok(Ok(_)) => println!("任务 {} 完成", task.id), Ok(Err(e)) => { println!("任务 {} 失败: {}", task.id, e); // 失败重试(限3次) retry_task(&mut conn, task).await; } Err(_) => println!("任务 {} 超时", task.id), } } } }); }}

复制代码

技术亮点:

结合tokio::time::timeout实现任务超时控制,避免资源长期占用;

通过 Redis 分布式队列实现集群任务分发,Tokio 异步 Redis 客户端(redis-async)避免 IO 阻塞;

优先级队列与工作窃取调度结合,确保高优先级任务优先执行。

5.3 案例三:实时日志收集与分析平台

场景:分布式系统的日志实时收集(每秒数十万条日志)、过滤与聚合。

核心需求:高吞吐接收、低延迟分析、内存可控。

核心实现

日志接收与缓冲:

use tokio::io::{AsyncReadExt, AsyncWriteExt};use tokio::sync::broadcast;

#[tokio::main]async fn main() { // 广播通道:日志数据分发到多个分析器 let (tx, _) = broadcast::channel(10000); // 启动日志服务器 let listener = TcpListener::bind("0.0.0.0:5140").await.unwrap(); println!("日志服务器启动,监听 5140 端口"); // 启动分析任务(独立线程池,避免影响接收性能) tokio::spawn(analyze_logs(tx.subscribe())); // 接收日志 loop { let (mut stream, _) = listener.accept().await.unwrap(); let tx = tx.clone(); tokio::spawn(async move { let mut buf = Vec::with_capacity(1024); while stream.read_to_end(&mut buf).await.unwrap() > 0 { // 广播日志数据(非阻塞,满了就丢弃老数据) let _ = tx.send(buf.clone()); buf.clear(); } }); }}

复制代码

实时分析与聚合:

async fn analyze_logs(mut rx: broadcast::Receiver<Vec<u8>>) { let mut error_count = 0; let mut interval = tokio::time::interval(Duration::from_secs(10)); loop { tokio::select! { // 接收日志并分析 Ok(log) = rx.recv() => { let log_str = String::from_utf8_lossy(&log); if log_str.contains("ERROR") { error_count += 1; } } // 每10秒输出统计结果 _ = interval.tick() => { println!("过去10秒错误日志数: {}", error_count); error_count = 0; } } }}

复制代码

技术亮点:

使用broadcast通道实现日志数据一对多分发,支持多分析器并行处理;

select!宏实现“接收日志”与“定时统计”的并发逻辑,避免阻塞;

缓冲池(Vec::with_capacity)减少内存分配开销,提升吞吐量。

5.4 案例四:生产级 Web 服务(基于 Axum 框架)

场景:高并发 API 服务(如支付系统接口,峰值 QPS 10 万+)。

核心需求:低延迟响应、连接复用、限流保护、优雅关闭。

核心实现

服务初始化与路由:

use axum::{Router, routing::get, http::StatusCode, response::IntoResponse};use tokio::sync::Semaphore;use std::sync::Arc;

#[tokio::main]async fn main() { // 限流信号量(最多1000并发请求) let semaphore = Arc::new(Semaphore::new(1000)); // 路由定义 let app = Router::new() .route("/pay", get(pay_handler)) .with_state(semaphore); // 注入状态 // 绑定地址并启动服务 let listener = TcpListener::bind("0.0.0.0:8080").await.unwrap(); axum::serve(listener, app) .with_graceful_shutdown(shutdown_signal()) .await.unwrap();}

复制代码

请求处理与限流:

async fn pay_handler(semaphore: Arc<Semaphore>) -> impl IntoResponse { // acquire permit(超时1秒) let permit = match semaphore.acquire_timeout(Duration::from_secs(1)).await { Ok(p) => p, Err(_) => return (StatusCode::TOO_MANY_REQUESTS, "请求过于频繁"), }; // 处理支付逻辑(模拟数据库操作) let result = process_payment().await; drop(permit); // 释放信号量 match result { Ok(_) => (StatusCode::OK, "支付成功"), Err(e) => (StatusCode::INTERNAL_SERVER_ERROR, format!("支付失败: {}", e)), }}

// 模拟支付处理(异步数据库操作)async fn process_payment() -> Result<(), String> { tokio::time::sleep(Duration::from_millis(10)).await; // 模拟IO延迟 Ok(())}

// 优雅关闭信号(监听Ctrl+C)async fn shutdown_signal() { let ctrl_c = async { tokio::signal::ctrl_c().await.unwrap(); }; #[cfg(unix)] let terminate = async { tokio::signal::unix::signal(tokio::signal::unix::SignalKind::terminate()) .unwrap() .recv() .await; }; #[cfg(not(unix))] let terminate = std::future::pending::<()>(); tokio::select! { _ = ctrl_c => println!("收到Ctrl+C,开始关闭"), _ = terminate => println!("收到终止信号,开始关闭"), } // 等待现有请求处理完成(最多30秒) tokio::time::sleep(Duration::from_secs(30)).await;}

复制代码

技术亮点:

六、Tokio 框架的性能优化与进阶技巧

6.1 任务调度优化:合理设置工作线程数

6.2 IO 性能优化:使用Bytes与BufReader/BufWriter

let mut reader = BufReader::new(read_half);let mut writer = BufWriter::new(write_half);// 缓冲读取数据let mut buf = [0; 1024];let n = reader.read(&mut buf).await?;// 缓冲写入数据writer.write_all(&buf[..n]).await?;writer.flush().await?;

复制代码

6.3 任务取消与资源清理:CancellationToken的使用

// 创建取消令牌let token = CancellationToken::new();let child_token = token.clone();

// 启动任务,监听取消信号tokio::spawn(async move { loop { // 检查是否收到取消信号 if child_token.is_cancelled() { println!("任务取消,释放资源"); return; } // 执行任务逻辑 tokio::time::sleep(Duration::from_secs(1)).await; }});

// 主动取消任务token.cancel();

复制代码

七、思考 Tokio 框架的核心优势与潜在挑战

7.1 核心优势

性能高效:工作窃取调度器减少任务竞争,异步 IO 避免阻塞,支持高吞吐量场景;

生态完善:支撑众多上层框架(Actix-web、Axum),提供丰富的工具链(如tokio-sync、tokio-util);

安全可靠:基于 Rust 的内存安全特性,避免空指针、数据竞争等问题,降低生产环境崩溃风险。

7.2 潜在挑战

学习成本:异步编程模型(Future、await)与 Rust 所有权结合,对新手门槛较高;

调试难度:异步任务的调度流程复杂,传统调试工具(如断点)难以追踪任务执行路径;

兼容性问题:部分同步库(如std::fs)需通过tokio::task::spawn_blocking包装才能在 Tokio 运行时中使用,可能引入性能开销。

八、总结:Tokio 在 Rust 异步生态中的地位与未来

Tokio 是 Rust 异步生态的 “基础设施”。凭借完整的异步运行时、高效的调度机制与丰富的组件,解决了高并发场景下的性能与安全痛点,已成为构建工业级异步应用的核心框架。从未来演进方向看,Tokio 将聚焦三大维度持续突破:

性能深度优化:迭代调度算法,例如引入更智能的任务窃取策略;优化 IO 驱动底层,支持更多操作系统特性,进一步提升系统吞吐量。

生态协同深化:加强与 WebAssembly、分布式系统等领域框架的联动,打破场景边界,拓展异步应用的落地范围。

开发体验升级:优化工具链,完善异步调试工具;补充文档体系,降低开发者的学习与实践门槛。

对于 Rust 开发者而言,掌握 Tokio 是提升高并发编程能力的关键和深入理解 Rust 异步生态的核心路径。随着 Rust 在云原生、边缘计算等领域的渗透,Tokio 的应用价值与生态影响力将进一步凸显。

评论